Peut-on comprendre et expliquer une décision automatisée prise par un système d’intelligence artificielle ? Pouvons-nous faire confiance à ce système autonome ? En tant qu’utilisateur, cela engage notre responsabilité et pose des questions. A travers Binaire, plusieurs chercheurs ont partagé leur travail à ce sujet ! Voici un résumé et récapitulatif autour de l’explicabilité et l’interprétabilité proposé par Ikram Chraibi Kaadoud chercheuse en IA passionnée de médiation ! Marie-Agnès Enard, Pascal Guitton et Thierry Viéville.

Un petit rappel de contexte

Dans de nombreux domaines, les mutations technologiques de ces dernières années ont mené à la disponibilité et à la prédominance de données complexes et hétérogènes. Par conséquent, de plus en plus de domaines d’application font appels aux systèmes d’intelligence artificielle (IA) dans le but de comprendre ces données, réaliser des prédictions jusqu’à aider l’humain à prendre des décisions. Dans notre quotidien, les prises de décisions assistées par des systèmes d’IA (voir automatisées quand urgence oblige) sont ainsi devenues une réalité quasi-omniprésente : algorithme de recommandation de médias, identification ou reconnaissance d’espèces animales et végétales, détection de pathologies, etc.

Dans ce contexte, l’humain, à la fois concepteur et utilisateur de tels systèmes d’IA, est un acteur incontournable. Amené à prendre des décisions basées sur ces systèmes, il engage sa responsabilité dans les choix qu’il effectue ce qui entraîne une exigence forte en termes de transparence et de compréhension des comportements de ces systèmes d’IA. Or, cette compréhension est loin d’être garantie puisque l’explicabilité* des modèles (notamment les propriétés d’interprétabilité des modèles à base de réseaux de neurones) est actuellement un sujet très complexe, objet d’études et de débats au sein même de la communauté scientifique en IA. Ce qui se traduit par de la méfiance de la part du grand public, face à ces systèmes considérés comme opaques parfois qualifiés de « boîtes noires ».

L’explicabilité* d’une IA vs celle d’un expert: Quand un expert humain prend une décision, il peut expliquer sur quelles connaissances, à partir de quels faits et quelles inférences il a utilisées pour arriver à sa conclusion. On parle d’explicabilité pour un système d’IA quand il peut lui aussi décrire comment a été construite sa décision. Dans certains cas, cette explication peut-être très complexe, voire impossible à appréhender par un humain ; en effet, un système de raisonnement automatisé peut enchaîner un très grand nombre de données, d’inférences qui dépassent de loin la capacité de nos cerveaux. Et c’est d’ailleurs bien pour ça que nous faisons appels à des machines qui ne sont pas intelligentes mais qui savent traiter des masses gigantesques d’informations.

Depuis 2018, l’entrée en vigueur du règlement européen général de protection de données (RGPD), ainsi que les exigences sociétales en faveur de systèmes IA de confiance, ont permis l’essor d’algorithmes d’IA explicables et transparents dans le paysage informatique. Chacune et chacun a, en théorie, le droit et la possibilité d’exiger une explication des processus de traitement automatique de données tels que justement les systèmes d’IA, mais pouvoir le faire au niveau des connaissances de toutes et tous est un défi culturel et pédagogique.

Cela a eu comme conséquence une explosion des travaux de recherche publiés sur ces sujets (explicabilité, interprétabilité, transparence, éthique, biais), et également une restriction de l’utilisation et l’amélioration d’un certain nombre de modèles existants autant dans l’industrie que – et surtout – dans la recherche.

Mais qu’est-ce que l’IA explicable (ou XAI pour eXplainable Artificial Intelligence) ?

En résumé, l’IA explicable peut être considérée comme une solution permettant de démystifier le comportement des systèmes d’IA et les raisons à l’origine de ce dernier. Il s’agit d’un ensemble d’approches et d’algorithmes permettant de proposer, par exemple, des systèmes d’aide à la décision et d’explication de ces décisions. Expliquer le raisonnement d’un système, avec ses points forts et faibles, ainsi que son potentiel comportement dans le futur est le but de ce domaine. Pourquoi cela ? Entre autres: 1) favoriser l’acceptabilité de ces systèmes en prenant en compte les aspects éthiques et transparents, et le profil de l’utilisateur cible de cette explication, 2) veiller au respect de l’intégrité morale et physique de chacune et chacun, 3) augmenter les connaissances des experts grâce à la connaissance extraite par ces mécanismes d’IA explicable.

En résumé, la dimension humaine est donc omniprésente depuis la conception jusqu’ à l’utilisation en passant par l’évaluation de modèle d’IA explicable.

Pour en savoir plus, le blog binaire récapitule les liens vers les articles que nous avons déjà partagés sur ces sujets :

Comment comprendre ce que font les réseaux de neurones est le point d’entrée de ce sujet. Voici une série de trois articles grand public pour commencer de Marine LHUILLIER , Ingénieure d’études et Data engineer (spécialiste des données et de leur traitements) :

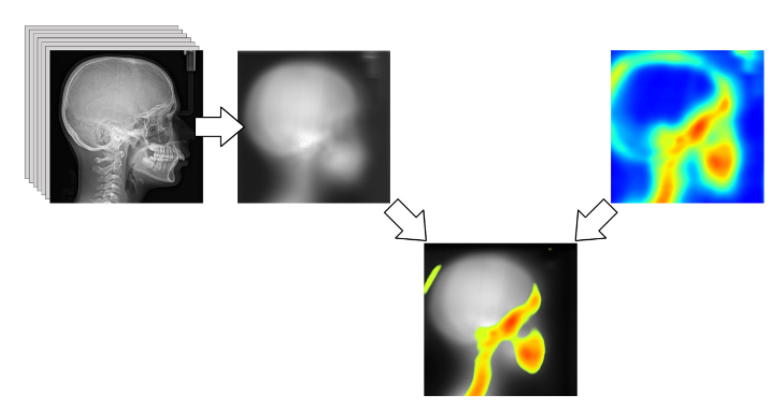

Démystifier des systèmes d’IA d’aide à la décision et les expliquer, permet également d’amener une connaissance pertinente à la portée du public ciblé. Un médecin peut donc voir en un système d’IA un moyen d’acquérir plus de connaissances sur une pathologie par exemple. L’IA transparente devient alors un outil d’apprentissage au service d’une expertise. Le Dr Masrour Makaremi nous avait partagé son point de vue sur cet aspect :

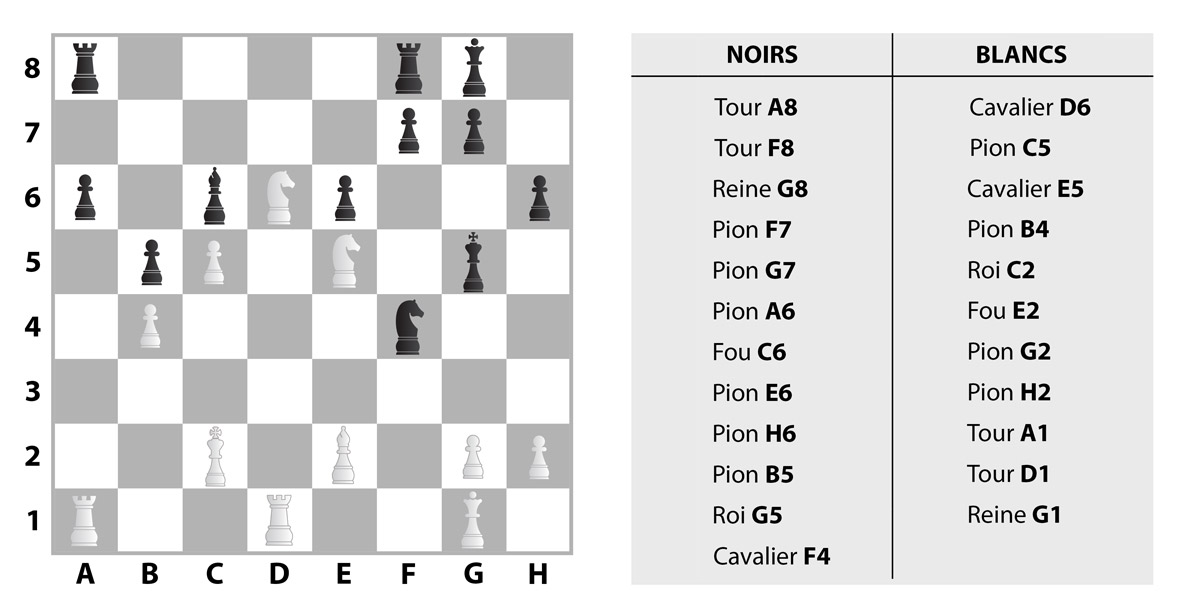

Les algorithmes d’explicabilité peuvent être aussi être utilisés dans des contextes très ludiques comme le jeu de bridge. Il s’agit d’un jeu de cartes qui nécessite de maîtriser plusieurs compétences intéressantes à modéliser artificiellement et à démystifier, telles que faire des déductions, émettre et réviser des hypothèses, anticiper les coups de l’adversaire ou encore évaluer les probabilités. Marie-Christine Rousset, Professeur d’informatique à l’Université Grenoble Alpes, se penche et explique comment fonctionne le robot de bridge Nook, développé par NukkAI, laboratoire privé d’Intelligence Artificielle français dédié aux développements d’IA explicables :

L’IA explicable peut aussi être un moyen de favoriser l’acceptabilité de l’IA dans l’agriculture. Dans ce domaine, où la compétence de terrain est très présente, l’IA peut se révéler être un objet de frustration car elle ne permet pas de comprendre les tenants et les aboutissants. Emmanuel Frénod, mathématicien et professeur à l’Université de Bretagne Sud, au sein du Laboratoire de Mathématiques de Bretagne Atlantique, aborde le sujet de l’intégration d’outils en IA en agriculture et de la problématique des boîtes noires dans ce domaine :

NOTRE PETIT PLUS : UNE NOUVELLE VIDÉO !

Deux chercheuses en IA de l’IMT Atlantique, Lina Fahed et Ikram Chraibi Kaadoud, sont intervenues à Women Teckmakers Montréal et Québec 2021, un programme mis en place par le Google developpers Group afin de souligner le talent des femmes dans le milieu de l’informatique, de promouvoir la passion et d’accroître la visibilité de la communauté technologique féminine. Ces chercheuses ont ainsi abordé des éléments de réponses aux questions de confiance en IA et ont discuté des concepts de transparence et d’éthique à travers l’explicabilité en IA, un sujet de recherche toujours d’actualité.

Cette présentation en français (avec des planches en anglais facilement lisibles, nous permettant aussi de se familiariser avec ce vocabulaire anglo-saxon) introduit aux concepts d’explicabilité et d’interprétabilité en IA, et fournit une description des grandes familles de stratégies en explicabilité, y compris d’un point de vue technique. Il aborde également les difficultés inhérentes au domaine notamment lorsque les données sont hétérogènes (c’est à dire de différents formats) , ou encore en questionnant l’impact éthique et sociétale du sujet au vu de l’omniprésence des systèmes IA dans notre environnement.

Ikram Chraibi Kaadoud , chercheuse postdoctorale travaillant actuellement sur le sujet de l’intelligence artificielle eXplainable (XAI) sur des séries temporelles hétérogènes à l’Institut des Mines Télécom Atlantique.