Introduction

Dans un monde où l’intelligence artificielle (IA) est de plus en plus présente dans notre quotidien, de la recommandation de films sur Netflix à la prédiction de la météo, une question audacieuse se pose : une IA pourrait-elle un jour diriger un pays ? Cette idée, qui semble tout droit sortie d’un roman de science-fiction, est en réalité de plus en plus débattue parmi les experts en technologie et en politique.

L’IA a déjà prouvé sa capacité à résoudre des problèmes complexes, à analyser d’énormes quantités de données et à prendre des décisions basées sur des algorithmes sophistiqués. Mais diriger un pays nécessite bien plus que de simples compétences analytiques. Cela nécessite de la sagesse, de l’empathie, de la vision stratégique et une compréhension profonde des nuances humaines – des qualités que l’IA peut-elle vraiment posséder ?

Dans cet article, nous allons explorer cette question fascinante et quelque peu controversée. Nous examinerons les arguments pour et contre l’idée d’une IA à la tête d’un pays, nous discuterons des implications éthiques et pratiques. Que vous soyez un passionné de technologie, un politologue ou simplement un citoyen curieux, nous vous invitons à nous rejoindre dans cette exploration de ce qui pourrait être l’avenir de la gouvernance.

L’intelligence artificielle : une brève introduction

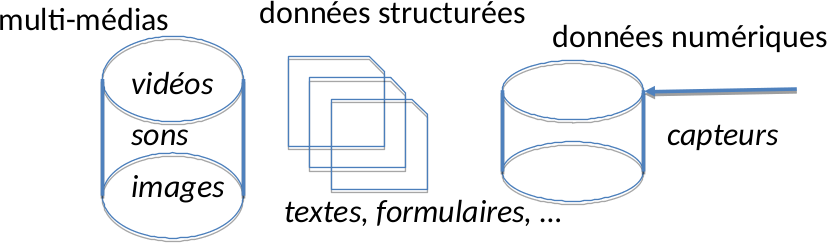

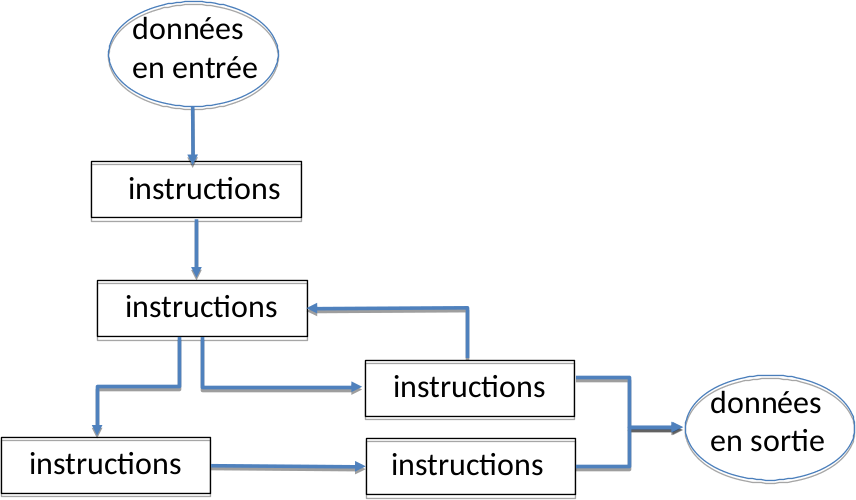

Avant de plonger dans le débat sur l’IA en tant que chef d’État, il est important de comprendre ce qu’est l’intelligence artificielle et ce qu’elle peut faire. L’IA est un domaine de l’informatique qui vise à créer des systèmes capables de réaliser des tâches qui nécessitent normalement l’intelligence humaine. Cela peut inclure l’apprentissage, la compréhension du langage naturel, la perception visuelle, la reconnaissance de la parole, la résolution de problèmes et même la prise de décision.

L’IA est déjà largement utilisée dans de nombreux secteurs. Par exemple, dans le domaine de la santé, l’IA peut aider à diagnostiquer des maladies, à prédire les risques de santé et à personnaliser les traitements. Dans le secteur financier, l’IA est utilisée pour détecter les fraudes, gérer les investissements et optimiser les opérations. Dans le domaine des transports, l’IA est au cœur des voitures autonomes et aide à optimiser les itinéraires de livraison. Et bien sûr, dans le domaine de la technologie de l’information, l’IA est omniprésente, des assistants vocaux comme Siri et Alexa aux algorithmes de recommandation utilisés par Netflix et Amazon.

Cependant, malgré ces avancées impressionnantes, l’IA a encore des limites. Elle est très bonne pour accomplir des tâches spécifiques pour lesquelles elle a été formée, mais elle a du mal à généraliser au-delà de ces tâches*. De plus, l’IA n’a pas de conscience de soi, d’émotions ou de compréhension intuitive du monde comme les humains. Elle ne comprend pas vraiment le sens des informations qu’elle traite, elle ne fait que reconnaître des modèles dans les données.

Cela nous amène à la question centrale de cet article : une IA, avec ses capacités et ses limites actuelles, pourrait-elle diriger un pays ? Pour répondre à cette question, nous devons d’abord examiner comment l’IA est déjà utilisée dans le domaine politique.

*Petit aparté sur ChatGPT et sa capacité de généralisation :

|

L’IA en politique : déjà une réalité ?

L’intelligence artificielle a déjà commencé à faire son chemin dans le domaine politique, bien que nous soyons encore loin d’avoir une IA en tant que chef d’État. Cependant, les applications actuelles de l’IA en politique offrent un aperçu fascinant de ce qui pourrait être possible à l’avenir.

L’une des utilisations les plus courantes de l’IA en politique est l’analyse des données. Les campagnes politiques utilisent l’IA pour analyser les données des électeurs, identifier les tendances et personnaliser les messages. Par exemple, lors des élections présidentielles américaines de 2016, les deux principaux candidats ont utilisé l’IA pour optimiser leurs efforts de campagne, en ciblant les électeurs avec des messages personnalisés basés sur leurs données démographiques et comportementales.

L’IA est également utilisée pour surveiller les médias sociaux et identifier les tendances de l’opinion publique. Les algorithmes d’IA peuvent analyser des millions de tweets, de publications sur Facebook et d’autres contenus de médias sociaux pour déterminer comment les gens se sentent à propos de certains sujets ou candidats. Cette information peut être utilisée pour informer les stratégies de campagne et répondre aux préoccupations des électeurs.

Dans certains pays, l’IA est même utilisée pour aider à la prise de décision politique. Par exemple, en Estonie, un petit pays d’Europe du Nord connu pour son adoption précoce de la technologie, le gouvernement développe une intelligence artificielle qui devra arbitrer de façon autonome des affaires de délits mineurs.

En plus du « juge robot », l’État estonien développe actuellement 13 systèmes d’intelligence artificielle directement intégrés dans le service public. Cela s’applique également au Pôle Emploi local, où plus aucun agent humain ne s’occupe des personnes sans emploi. Ces derniers n’ont qu’à partager leur CV numérique avec un logiciel qui analyse leurs différentes compétences pour ensuite créer une proposition d’emploi appropriée. Premier bilan : 72 % des personnes qui ont trouvé un emploi grâce à cette méthode le conservent même 6 mois plus tard. Avant l’apparition de ce logiciel, ce taux était de 58 %.

Cependant, malgré ces utilisations prometteuses de l’IA en politique, l’idée d’une IA en tant que chef d’État reste controversée. Dans les sections suivantes, nous examinerons les arguments pour et contre cette idée, et nous discuterons des défis et des implications éthiques qu’elle soulève.

L’IA à la tête d’un pays : les arguments pour

L’idée d’une intelligence artificielle à la tête d’un pays peut sembler futuriste, voire effrayante pour certains. Cependant, il existe plusieurs arguments en faveur de cette idée qui méritent d’être examinés.

Efficacité et objectivité : L’un des principaux avantages de l’IA est sa capacité à traiter rapidement de grandes quantités de données et à prendre des décisions basées sur ces données. Dans le contexte de la gouvernance, cela pourrait se traduire par une prise de décision plus efficace et plus objective. Par exemple, une IA pourrait analyser des données économiques, environnementales et sociales pour prendre des décisions politiques éclairées, sans être influencée par des biais personnels ou politiques.

Absence de corruption : Contrairement aux humains, une IA ne serait pas sujette à la corruption**. Elle ne serait pas influencée par des dons de campagne, des promesses de futurs emplois ou d’autres formes de corruption qui peuvent affecter la prise de décision politique. Cela pourrait conduire à une gouvernance plus transparente et plus équitable.

Continuité et stabilité : Une IA à la tête d’un pays pourrait offrir une certaine continuité et stabilité, car elle ne serait pas affectée par des problèmes de santé, des scandales personnels ou des changements de gouvernement. Cela pourrait permettre une mise en œuvre plus cohérente et à long terme des politiques.

Adaptabilité : Enfin, une IA pourrait être programmée pour apprendre et s’adapter en fonction des résultats de ses décisions. Cela signifie qu’elle pourrait potentiellement s’améliorer avec le temps, en apprenant de ses erreurs et en s’adaptant aux changements dans l’environnement politique, économique et social.

Cependant, bien que ces arguments soient convaincants, ils ne tiennent pas compte des nombreux défis et inquiétudes associés à l’idée d’une IA à la tête d’un pays. Nous examinerons ces questions dans la section suivante.

**Petit aparté sur la corruption d’une IA:Le sujet de la corruption d’une IA ou de son incorruptibilité a généré un échange en interne que l’on pense intéressant de vous partager Personne 1 : Ça dépend de qui contrôle l’IA ! Auteur : La corruption est le détournement d’un processus. L’intelligence en elle-même n’est pas corruptible. Après, si les résultats ne sont pas appliqué, ce n’est pas l’IA que l’on doit blâmer Personne 1 : En fait on peut en débattre longtemps, car le concepteur de l’IA peut embarquer ses idées reçues avec, dans l’entraînement. De plus, une personne mal intentionnée peut concevoir une IA pour faire des choses graves, et là il est difficile de dire que l’IA n’est pas corruptible. Auteur : Oui c’est sûr ! Volontairement ou involontairement, on peut changer les prédictions, mais une fois entrainé, ça semble plus compliqué. J’ai entendu dire que pour les IA du quotidien, une validation par des laboratoires indépendants serait obligatoire pour limiter les biais. A voir ! En résumé, la corruption d’une IA est un sujet complexe à débattre car il implique une dimension technique liée au système IA en lui-même et ses propres caractéristiques (celle-ci sont-elles corruptibles?) et une dimension humaine liée aux intentions des personnes impliqués dans la conception, la conception et le déploiement de cette IA. Sans apporter de réponses, cet échange met en lumière la complexité d’un tel sujet pour la réflexion citoyenne. |

L’IA à la tête d’un pays : les arguments contre

Malgré les avantages potentiels d’une IA à la tête d’un pays, il existe de sérieux défis et préoccupations qui doivent être pris en compte. Voici quelques-uns des principaux arguments contre cette idée.

Manque d’empathie et de compréhension humaine : L’une des principales critiques de l’IA en tant que chef d’État est qu’elle manque d’empathie et de compréhension humaine. Les décisions politiques ne sont pas toujours basées sur des données ou des faits objectifs ; elles nécessitent souvent une compréhension nuancée des valeurs, des émotions et des expériences humaines. Une IA pourrait avoir du mal à comprendre et à prendre en compte ces facteurs dans sa prise de décision.

Responsabilité : Un autre défi majeur est la question de la responsabilité. Si une IA prend une décision qui a des conséquences négatives, qui est tenu responsable ? L’IA elle-même ne peut pas être tenue responsable, car elle n’a pas de conscience ou de volonté propre. Cela pourrait créer un vide de responsabilité qui pourrait être exploité.

Risques de sécurité : L’IA à la tête d’un pays pourrait également poser des risques de sécurité. Par exemple, elle pourrait être vulnérable au piratage ou à la manipulation par des acteurs malveillants. De plus, si l’IA est basée sur l’apprentissage automatique, elle pourrait développer des comportements imprévus ou indésirables en fonction des données sur lesquelles elle est formée.

Inégalités : Enfin, l’IA pourrait exacerber les inégalités existantes. Par exemple, si l’IA est formée sur des données biaisées, elle pourrait prendre des décisions qui favorisent certains groupes au détriment d’autres. De plus, l’IA pourrait être utilisée pour automatiser des emplois, ce qui pourrait avoir des conséquences négatives pour les travailleurs.

Ces défis et préoccupations soulignent que, bien que l’IA ait le potentiel d’améliorer la gouvernance, son utilisation en tant que chef d’État doit être soigneusement considérée et réglementée. Dans la section suivante, nous examinerons les points de vue de différents experts sur cette question.

Points de vue des experts : une IA à la tête d’un pays est-elle possible ?

La question de savoir si une IA pourrait un jour diriger un pays suscite un débat animé parmi les experts. Certains sont optimistes quant à la possibilité, tandis que d’autres sont plus sceptiques.

Les optimistes : Certains experts en technologie et en politique croient que l’IA pourrait un jour être capable de diriger un pays. Ils soulignent que l’IA a déjà prouvé sa capacité à résoudre des problèmes complexes et à prendre des décisions basées sur des données. Ils suggèrent que, avec des avancées supplémentaires en matière d’IA, il pourrait être possible de créer une IA qui comprend les nuances humaines et qui est capable de prendre des décisions politiques éclairées.

Les sceptiques : D’autres experts sont plus sceptiques. Ils soulignent que l’IA actuelle est loin d’être capable de comprendre et de gérer la complexité et l’incertitude inhérentes à la gouvernance d’un pays. Ils mettent également en garde contre les risques potentiels associés à l’IA en politique, tels que de responsabilité, les risques de sécurité et les inégalités.

Les pragmatiques : Enfin, il y a ceux qui adoptent une approche plus pragmatique. Ils suggèrent que, plutôt que de remplacer les dirigeants humains par des IA, nous devrions chercher à utiliser l’IA pour soutenir et améliorer la prise de décision humaine. Par exemple, l’IA pourrait être utilisée pour analyser des données politiques, économiques et sociales, pour prédire les conséquences des politiques proposées, et pour aider à identifier et à résoudre les problèmes politiques.

En fin de compte, la question de savoir si une IA pourrait un jour diriger un pays reste ouverte. Ce qui est clair, cependant, c’est que l’IA a le potentiel de transformer la politique de manière significative. À mesure que la technologie continue de progresser, il sera essentiel de continuer à débattre de ces questions et de réfléchir attentivement à la manière dont nous pouvons utiliser l’IA de manière éthique et efficace en politique.

Conclusion : Vers un futur gouverné par l’IA ?

L’idée d’une intelligence artificielle à la tête d’un pays est fascinante et controversée. Elle soulève des questions importantes sur l’avenir de la gouvernance, de la démocratie et de la société en général. Alors que l’IA continue de se développer et de s’intégrer dans de nombreux aspects de notre vie quotidienne, il est essentiel de réfléchir à la manière dont elle pourrait être utilisée – ou mal utilisée – dans le domaine de la politique.

Il est clair que l’IA a le potentiel d’améliorer la prise de décision politique, en rendant le processus plus efficace, plus transparent et plus informé par les données. Cependant, il est également évident que l’IA présente des défis et des risques importants, notamment en termes de responsabilité, de sécurité et d’équité.

Alors, une IA à la tête d’un pays est-elle science-fiction ou réalité future ? À l’heure actuelle, il semble que la réponse soit quelque part entre les deux. Bien que nous soyons encore loin d’avoir une IA en tant que chef d’État, l’IA joue déjà un rôle de plus en plus important dans la politique. À mesure que cette tendance se poursuit, il sera essentiel de continuer à débattre de ces questions et de veiller à ce que l’utilisation de l’IA en politique soit réglementée de manière à protéger les intérêts de tous les citoyens.

En fin de compte, l’avenir de l’IA en politique dépendra non seulement des progrès technologiques, mais aussi des choix que nous faisons en tant que société. Il est donc crucial que nous continuions à nous engager dans des discussions ouvertes et éclairées sur ces questions, afin de façonner un avenir dans lequel l’IA est utilisée pour améliorer la gouvernance et le bien-être de tous.

Références et lectures complémentaires

Pour ceux qui souhaitent approfondir le sujet, voici les références :

- https://www.cnil.fr/fr/intelligence-artificielle/intelligence-artificielle-de-quoi-parle-t-on

- Intelligence artificielle : « Aux Etats-Unis, nous entrons dans la première campagne de satisfaction immédiate et perpétuelle des électeurs » Par Anthony Gibert et Thomas Coulom

- Présidentielle américaine : une campagne d’influence similaire à celle de 2016 est-elle encore possible ? Par Martin Untersinger et Damien Leloup

- Chine : une femme robot pilotée par une IA devient PDG d’une entreprise de plusieurs milliers de salariés

- En Estonie, une intelligence artificielle va rendre des décisions de justice Par Harold Grand

- Titre : Les avantages et inconvénients des intelligences artificielles : Révolution technologique et dilemmes éthiques | by Oreshizu | Jun, 2023 | Medium Par Oreshizu

- https://www.economie.gouv.fr/strategie-nationale-intelligence-artificielle

- https://www.entreprises.gouv.fr/fr/numerique/enjeux/la-strategie-nationale-pour-l-ia

- https://www.intel.fr/content/www/fr/fr/government/artificial-intelligence.html

Pour ceux qui souhaitent approfondir le sujet, voici une de lectures complémentaires :

- « The Politics of Artificial Intelligence » par Nick Bostrom. Ce livre explore en profondeur les implications politiques de l’IA, y compris la possibilité d’une IA à la tête d’un pays.

- « AI Superpowers: China, Silicon Valley, and the New World Order » par Kai-Fu Lee. Cet ouvrage examine la montée de l’IA en Chine et aux États-Unis, et comment cela pourrait remodeler l’équilibre mondial du pouvoir.

- « The Ethics of Artificial Intelligence » par Vincent C. Müller et Nick Bostrom. Cet article examine les questions éthiques soulevées par l’IA, y compris dans le contexte de la gouvernance.

- « Artificial Intelligence The Revolution Hasn’t Happened Yet » par Michael Jordan. Cet article offre une perspective sceptique sur l’IA en politique, mettant en garde contre l’excès d’optimisme.

- « The Malicious Use of Artificial Intelligence: Forecasting, Prevention, and Mitigation » par Brundage et al. Ce rapport explore les risques de sécurité associés à l’IA, y compris dans le contexte de la politique.

Ces ressources offrent une variété de perspectives sur l’IA en politique et peuvent aider à éclairer le débat sur la possibilité d’une IA à la tête d’un pays. Comme toujours, il est important de garder à l’esprit que l’IA est un outil, et que son utilisation en politique dépendra des choix que nous faisons en tant que société.