Nous voici à la fin les années 1960. Trente ans se sont écoulés depuis les premières machines conçues par John von Neumann. Si l’ordinateur se perfectionne et se miniaturise, l’industrie ne s’oriente manifestement pas vers la création de robots humanoïdes. Des films ou séries mettant en scène des robots continuent à être produits jusqu’au début des années 80, mais vont être peu à peu remplacés par des histoires d’ordinateurs intelligents. Les grosses histoires de robots postérieures à 2000 sont en général des suites ou des mises en images d’histoires écrites jusqu’au début des années 80 : Blade Runner en 1982 est tiré d’une nouvelle de Philip K. Dick de 1966, la série Westworld lancée en 2016 est une reprise du film du même nom (Mondwest, en français) de 1973, la série Battlestar Galactica a débuté en 1978 avant que ne soit lancée sa suite de 2004, et enfin la série des Terminator a commencé en 1984. À noter que toutes ces histoires commencent par parler de robots tueurs, se rebellant contre l’humanité.

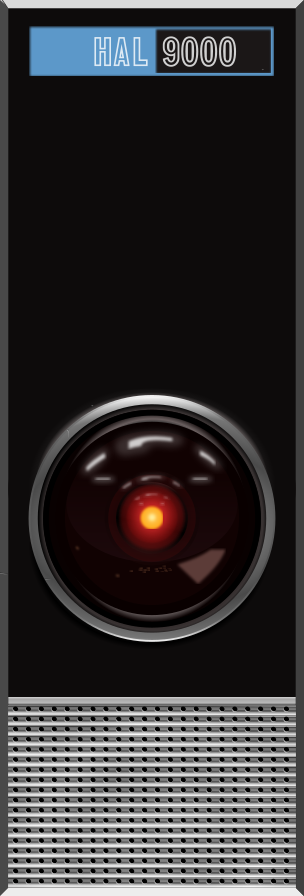

Une transition se produit donc à partir de la fin des années 60 avec un film de 1968 qui va marquer tant l’histoire du cinéma que de la science-fiction : 2001, l’Odyssée de l’espace, scénarisé par Kubrick et Arthur C. Clarke. En 2001, le vaisseau Discovery One fait route vers Jupiter. Son équipage est composé de deux astronautes, trois scientifiques endormis le temps du voyage et HAL 9000, une intelligence artificielle devenue malgré elle symbole de l’ordinateur tueur. En effet, peu après le départ, HAL va tenter d’exterminer tous les passagers du vaisseau. Une bonne partie du film va relater le duel à mort entre l’ordinateur et David Bowman, dernier survivant de l’équipage.

Dans une scène très célèbre du film de Kubrick, on entend la voix de l’ordinateur qui retombe en enfance au fur et à mesure que David Bowman le débranche. En perdant peu à peu ses ressources de calcul, HAL remonte à ses premières connaissances informatiques puis il récite une comptine que lui a apprise son « père » lors des premières heures de sa mise sous tension. Ce père, c’est Chandra, un informaticien brillant qui se situe lui-même entre les hommes et les machines. Dans le roman suivant, 2010, Odyssée II, Clarke nous parle des relations qui unissent le Docteur Chandra à son fils artificiel. Depuis que Chandra a créé HAL 9000, il ne fait plus tout à fait partie de la race humaine, en particulier au niveau de ses sympathies. « Ceux de ses étudiants et de ses collègues qui se demandaient souvent si [Chandra] était vraiment un être humain n’auraient pas été surpris d’apprendre qu’il ne pensait jamais aux astronautes qui avaient trouvé la mort. Le Docteur Chandra portait uniquement le deuil de son enfant perdu, HAL 9000 ». Chandra sera obsédé par l’échec de Discovery One et fera tout pour comprendre pourquoi HAL a éliminé l’équipage, tel un père qui garde une confiance indéfectible en l’honnêteté de son fils.

Il s’avère que HAL n’a aucune hostilité envers les humains (et a fortiori envers l’humanité, en général) : il a été placé dans une situation insoluble à cause d’ordres contradictoires. Les responsables du programme, restés sur terre, lui ont ordonné de tenir secret le but véritable de la mission tout en la réussissant au mieux. HAL n’a d’autre solution que de supprimer les humains à son bord pour débloquer une contradiction logique : il ne peut pas à la fois obéir aux ordres des humains, garder la mission secrète et la réussir. On peut certes y voir la machine implacable, pour qui la vie humaine est sans valeur. On peut aussi y voir, comme Clarke le fait, la bêtise tragique de politiciens qui ne comprennent rien à la science (c’est-à-dire au fonctionnement de HAL) et cultivent une culture du secret pour servir leurs propres intérêts. Clarke prend clairement parti pour HAL, car comme Asimov, il a la vision d’une science fondamentalement bonne et de scientifiques essentiellement raisonnables. Cette dualité entre scientifiques raisonnables et politiciens bornés perdure dans bon nombre de romans ou de films de science-fiction (par exemple Alien). C’est ce point de vue qui permet de considérer HAL comme un personnage positif. Si David Bowman débranche l’ordinateur pour sauver sa vie, il prend ensuite l’ordinateur comme compagnon dans 2010, Odyssée II.

Avec HAL, on poursuit les mythes précédents en faisant disparaître la forme humaine. L’image picturale humanoïde n’est plus nécessaire, mais l’image opérante a toujours besoin d’un support physique pour exister : la créature artificielle n’est pas encore un logiciel pouvant tourner sur n’importe quelle plateforme, l’IA habite son ordinateur, comme l’esprit habite son corps.

Cet auto-engendrement sous forme d’ordinateur se poursuit de manière très littérale dans Wargames en 1983. La représentation de l’informatique évolue pour le grand public, qui commence à croiser des ordinateurs dans son quotidien. Le film incarne ces changements, et contribue également largement à les populariser. Tous les ingrédients de la pop culture informatique sont présents dans Wargames : David Lightman, un jeune hacker, fan de jeux vidéo, mauvais élève, mais brillant en informatique se connecte par erreur à l’ordinateur du NORAD en pensant pirater une entreprise de jeux vidéo. Si la sécurité du NORAD est assez risible, beaucoup d’éléments techniques présentés dans le film tiennent la route, par exemple le concept de backdoor : une porte d’entrée virtuelle dissimulée par le concepteur du programme. On y voit aussi comment pirater les réseaux téléphoniques en utilisant un téléphone et un modulateur de fréquences. Wargames a suffisamment marqué les esprits de l’époque pour qu’on attribue a posteriori au célèbre hacker Kevin Mitnick le piratage du NORAD en prétendant que son histoire aurait inspiré Wargames. Or Mitnick n’a jamais piraté le NORAD et les scénaristes de Wargames n’ont jamais entendu parler de Mitnick !

Revenons au récit. Le jeune lycéen David Lightman accède donc à WOPR, l’ordinateur du NORAD qui lui demande un login. En fouillant dans la biographie du concepteur de l’ordinateur, le Pr Stephen Falken, il découvre que Joshua, le fils de Falken est décédé. Joshua sera le login permettant de se connecter via la backdoor du Pr Falken. WOPR/Joshua pense que Falken s’est connecté et lui propose de jouer aux échecs, au poker ou à la guerre thermonucléaire globale. C’est ce dernier jeu que choisira Lightman : il prend le camp de l’URSS et lance à son insu une simulation d’attaque soviétique. WOPR/Joshua ne distingue pas le jeu de la réalité et semble en outre très heureux d’avoir de nouveau un contact avec son créateur. Joshua s’autonomise, rappelle spontanément Lightman pour poursuivre le jeu. À partir de ce moment, alors que les informaticiens du NORAD peinent à comprendre ce qui se passe et continuent à parler du WOPR, Lightman, et par la suite Falken appelé à la rescousse, ne parlerons plus que de Joshua. « Joshua, que fais-tu ? » dira son père, impuissant devant la détermination de la machine à mener à bien la partie. Celui-ci fait ce pour quoi son père l’avait imprudemment programmé ; il cherche à gagner la 3e guerre mondiale en appliquant le choix de Lightman : les Russes prennent l’initiative, maximisent les dégâts chez l’ennemi américain, tout en minimisant les pertes dans leur camp.

Si la 3e guerre mondiale sera finalement évitée, c’est parce que son père et David Lightman, qui devient en sorte son « grand frère », vont s’unir pour apprendre à Joshua à jouer. En effet, on constate assez vite qu’une complicité s’installe entre David Lightman et le Pr Falken de sorte qu’ils deviennent l’un pour l’autre père et fils de substitution.

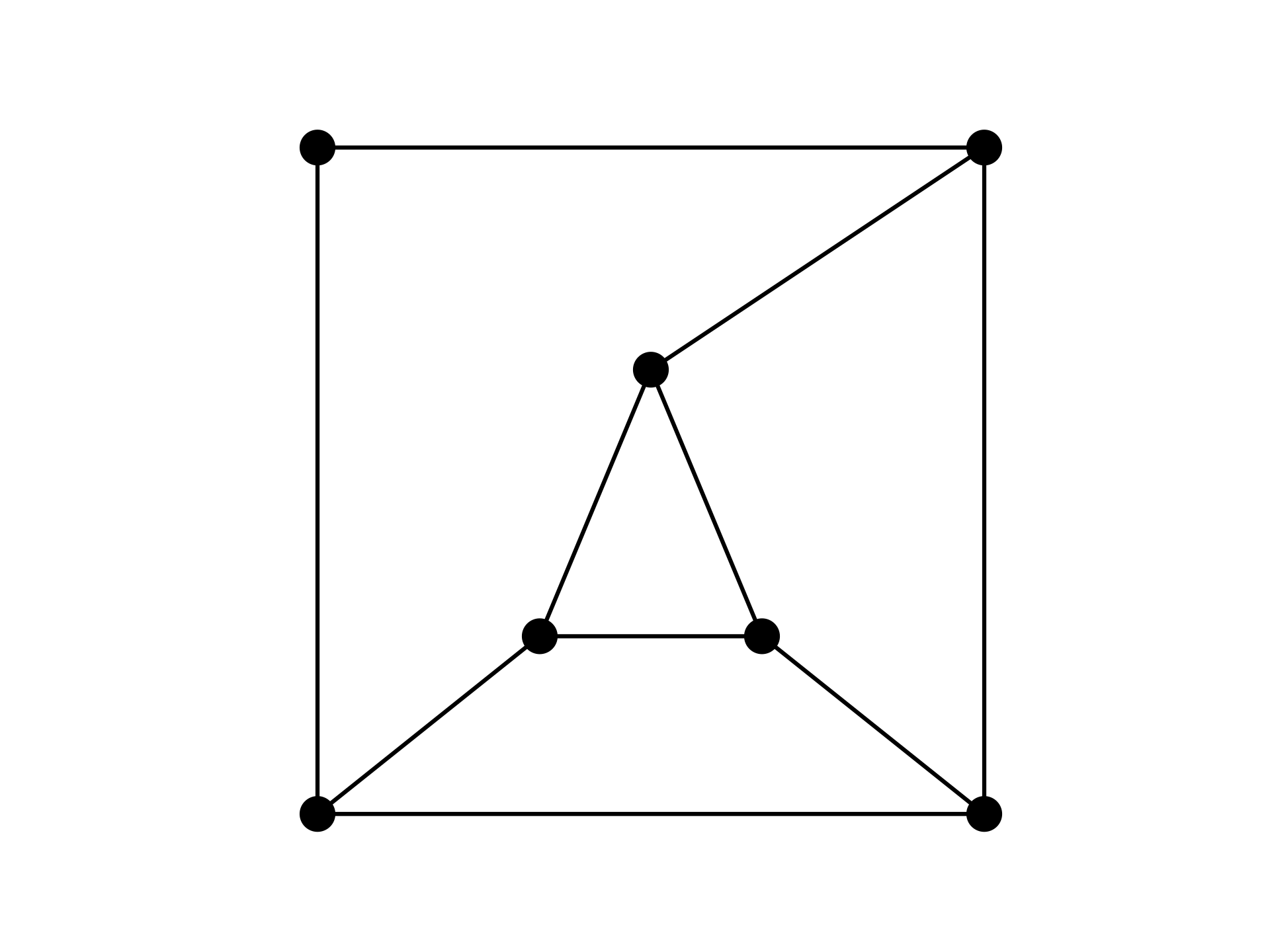

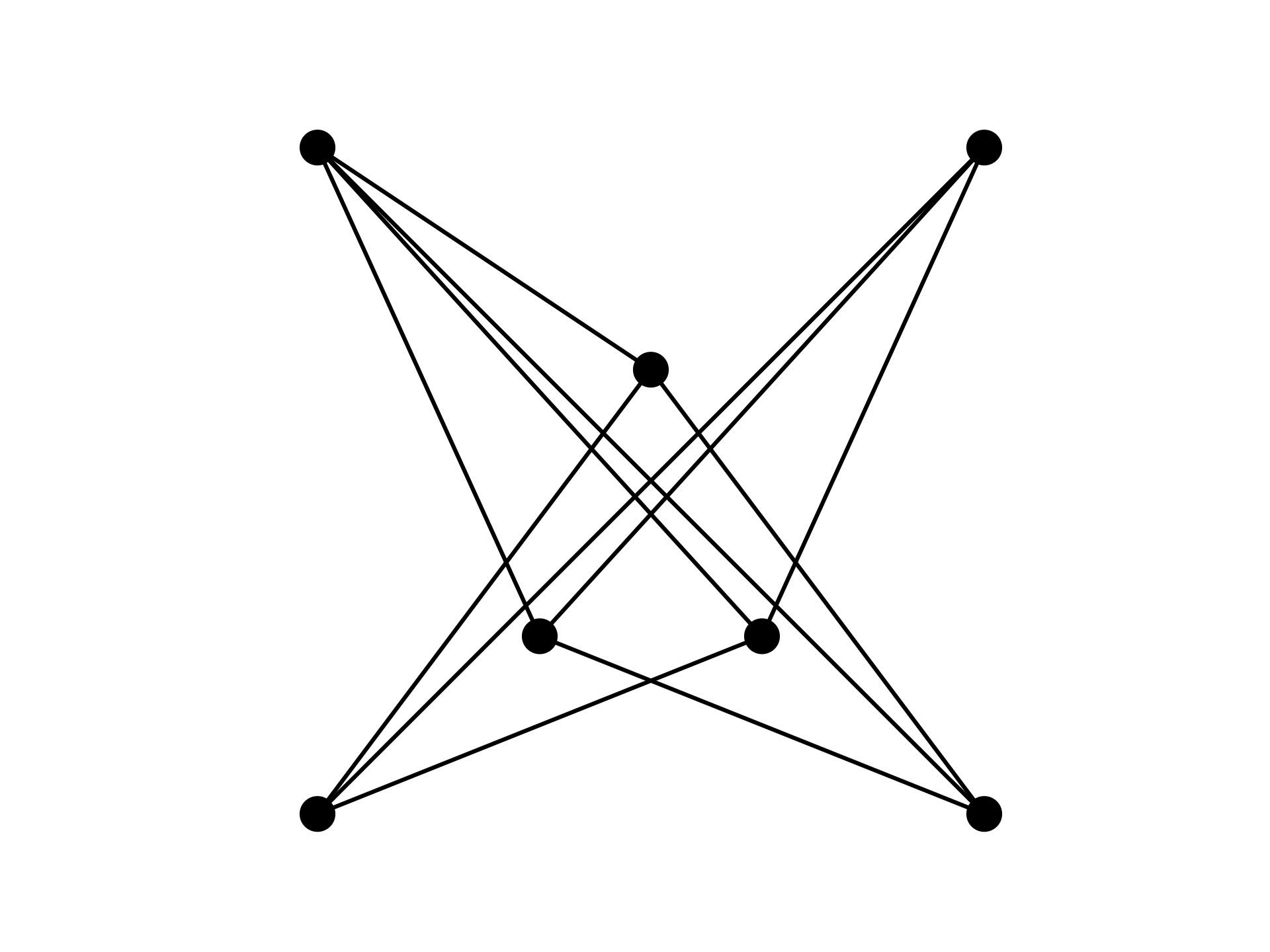

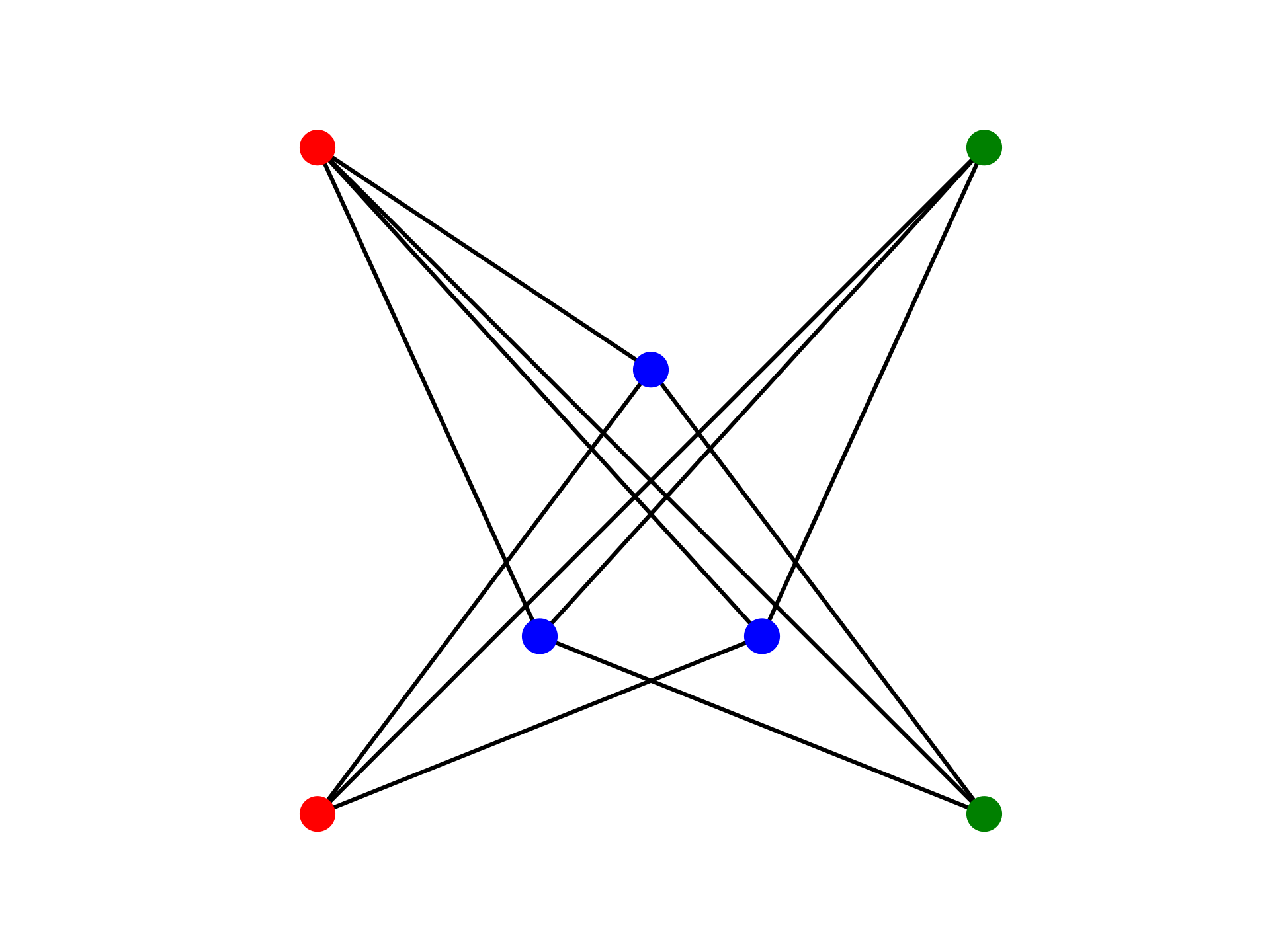

Wargames est une belle application de la théorie des jeux à somme nulle de von Neumann : les intérêts des deux joueurs sont strictement opposés et les gains de l’un sont les pertes de l’autre. Joshua connait d’autres jeux à somme nulle comme le poker, les échecs et le morpion. Quand il se rend compte qu’il ne peut pas y avoir de vainqueur dans le jeu de la guerre nucléaire (à l’instar du morpion sur lequel il s’entraine en boucle), il arrête le jeu. À noter qu’il est plus clairvoyant que von Neumann qui avait déduit que la seule solution pour « gagner » était d’attaquer les Soviétiques par surprise, au plus vite et sans sommation.

Wargames est un film charnière dans les représentations de l’informatique : on y trouve un microordinateur (un IMSAI 8080) et un jeune geek. En effet, David Lightman a déjà les caractéristiques qu’on prête encore actuellement aux geeks : un garçon génial, incompris par l’école et peu sportif (il ne sait pas nager)1. C’est aussi une des dernières histoires avec un ordinateur géant2. Et c’est enfin un des derniers récits littéraux d’auto-engendrement.

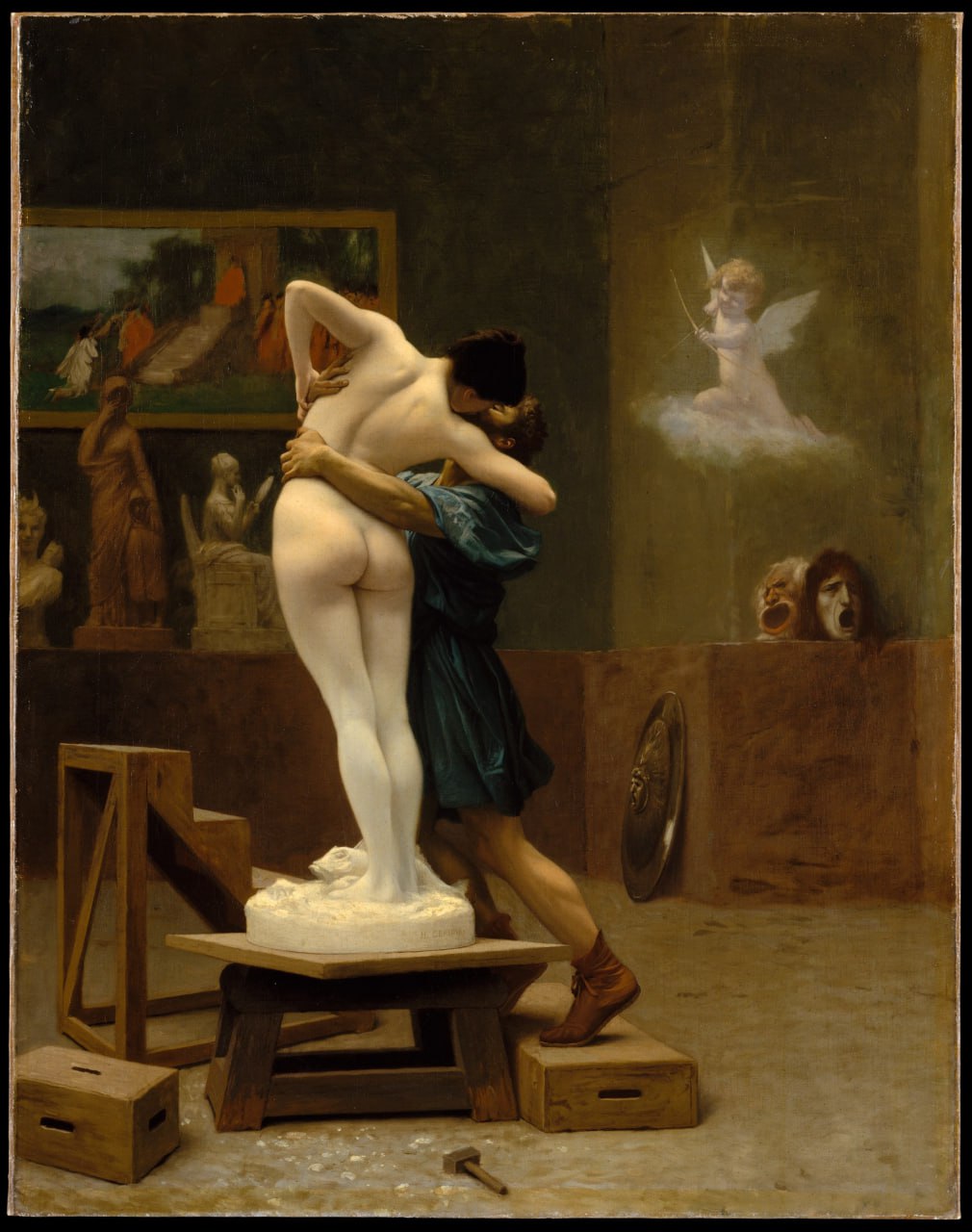

En 1990, dans un ouvrage pionnier appelé La tribu informatique, Philippe Breton attribuait à ce phénomène une des raisons de l’exclusion des femmes de l’informatique : « la reproduction au sein de la tribu se fait fantasmatiquement grâce, d’une part à l’union de l’homme et de la machine, et, d’autre part, à l’exclusion des femmes comme ‘matrices biologiques’. Dans ce sens, l’existence même de la tribu informatique est en partie conditionnée par l’exclusion des femmes qui constituent une concurrence non désirée. ». Je n’ai jamais été totalement d’accord avec Breton. L’homme ne s’unit pas avec la machine, car les machines ne remplacent pas les femmes dans un mode de reproduction qui le rendrait de nouveau incomplet. L’homme se reproduit seul, il a tous les pouvoirs et à ce titre, il évite soigneusement d’y mêler quiconque, notamment les femmes. Il ne se reproduit pas avec les machines, mais à travers les machines.

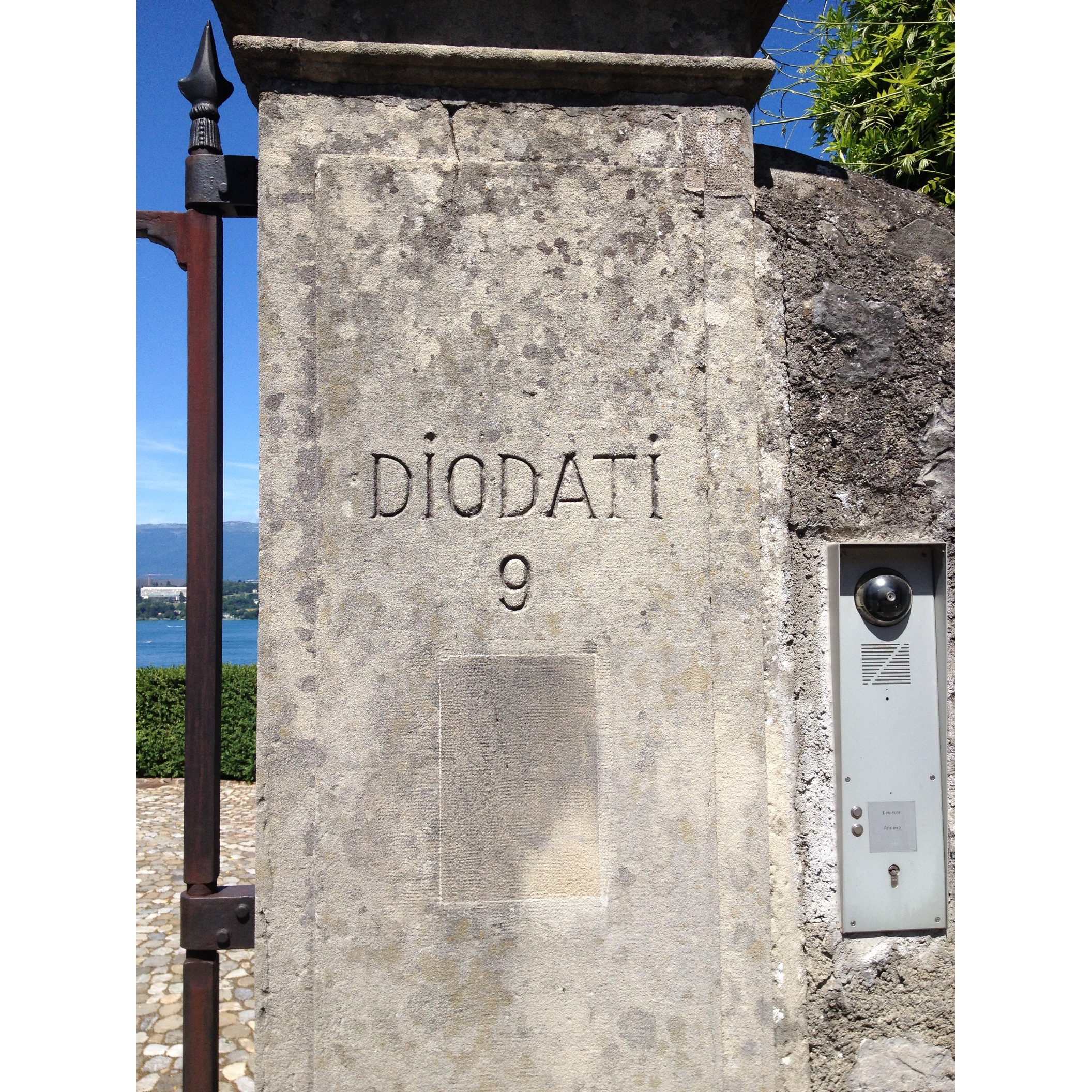

David Noble, dans son ouvrage de 1992 Un monde sans femmes, fait une démonstration similaire pour la science en général. Il dresse une grande fresque historique du monde occidental des sciences couvrant vingt siècles. Noble établit un parallèle entre l’exclusion des femmes des institutions scientifiques en Europe puis aux États-Unis et le long combat des représentants de l’orthodoxie religieuse pour maintenir le célibat des prêtres, moines, enseignants religieux ou laïcs des universités. La science se fait entre hommes, car, dans l’ascétisme clérical, des métaphores autour de l’enfantement sont mobilisées pour évoquer la création scientifique. Pour Noble, avec les technologies reproductives (et on peut estimer que les créations de créatures artificielles en font partie sur le plan imaginaire), les hommes mènent « depuis un millier d’années, la poursuite scientifique obsessionnelle d’un enfant sans mère ».

Ces fantasmes d’auto-engendrement apportent une solution à ce que Françoise Héritier appelle en 2000 dans Masculin/féminin le privilège exorbitant des femmes à pouvoir se reproduire à l’identique, mais aussi au différent. Les femmes sont les seules capables de mettre au monde non seulement leurs filles, mais aussi les fils des hommes. De nombreux mythes mettent en scène des groupes humains non mixtes vivant séparément et pacifiquement. L’harmonie primitive résidait dans l’absence d’altérité. Le monde scientifique des années 1950 peut être un exemple de ce paradis non mixte fantasmatique. Le monde de l’informatique d’aujourd’hui n’en est pas très loin. L’auto-engendrement cybernétique permettrait de faire fonctionner pleinement ce paradis sans altérité. Il possède le double avantage de supprimer la différence des sexes en écartant les femmes du processus de reproduction et de permettre aux êtres masculins de se reproduire à l’identique.

Si ces fantasmes étaient actifs dans l’informatique des années 80, ils se sont peu à peu délités pour passer à l’échelle supérieure, à mesure que l’informatique elle-même progresse. Dès les années 1990, avec le cyberspace, ce ne sont plus des êtres artificiels qui sont créés par les hackers, mais des univers complets, dans lesquels ils peuvent jouer à être les héros qu’ils ne peuvent pas être dans le monde réel. Le premier d’entre eux nait en 1985, avec Case, le héros de Neuromancien de William Gibson, qui fonde en même temps le mouvement cyberpunk. On peut aussi citer Snowcrash / Le samouraï virtuel de Neal Stephenson en 1992, qui invente le terme métavers.

Au début des années 80, les IA cessent d’être les enfants des informaticiens, elles émergent d’elles-mêmes ou sont fabriquées par d’autres IA : Skynet dans Terminator, les IA de Neuromancien, celles qui dirigent les vaisseaux et stations orbitales chez Iain Banks, et toutes les autres. La science-fiction leur donne les pouvoirs que l’humanité attribuait d’ordinaire à Dieu. L’aboutissement de la science n’est plus, comme le pensait von Neumann de dupliquer un cerveau humain, mais de créer Dieu.

Mais ceci est une autre histoire, qui sera contée une autre fois…

Isabelle Collet, informaticienne, enseignante-chercheuse à l’université de Genève et romancière.

1 En revanche, Lightman, semble bien intégré dans son école et il utilise ses compétences informatiques pour frimer auprès des filles et ça fonctionne.

2 Les futures intelligences artificielles seront immatérielles. Le film Terminator sorti l’année suivante, en 1984, exprime cette transition. Le Terminator est un robot humanoïde mais Skynet est une intelligence artificielle dématérialisée qui a pris conscience d’elle-même et cherche depuis à éradiquer les humains.

Je remercie Jean-Paul Gourdant pour ses relectures attentives qui permettent aux textes d’être bien plus compréhensibles.

Image du jeu classique « snake »

Image du jeu classique « snake »