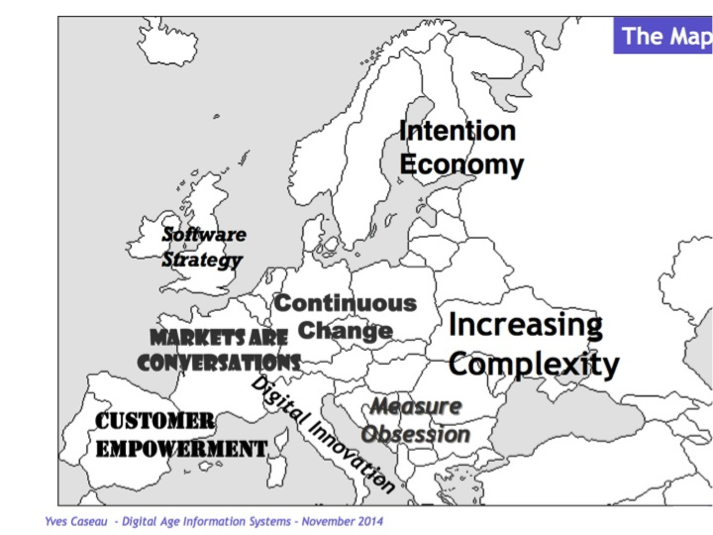

Dans le cadre des « Entretiens autour de l’informatique », Serge Abiteboul et Marie Jung ont rencontré Yves Caseau, responsable de l’Agence Digitale du Groupe Axa. Son objectif : moderniser les méthodes de travail des équipes chargées de concevoir les applications mobiles et les sites web. Nous nous sommes habitués à voir l’informatique construire un nouveau monde, le monde numérique. Yves Caseau raconte à Binaire comment, dans un retour de service éblouissant, ce monde numérique a véritablement transformé l’informatique.

Une autre manière de développer du logiciel

B : Quels sont les changements récents les plus importants dans le développement de logiciel ?

YC : Le premier élément de changement important, c’est la manière de coder. Avant pour un problème complexe, on se lançait dans une analyse poussée et le développement d’un logiciel monolithique. Les jeunes actuels commencent par chercher avec Google si un bout de programme existe déjà quelque part qui résout une partie du problème. Du coup, avant on essayait d’avoir les développeurs les plus compétents. Maintenant, on préfère avoir des profils capables de manipuler avec brio des bouts de codes, de les combiner, et de vérifier ce qu’ils font, sans nécessairement comprendre leurs mécanismes intimes. C’est le rêve de l’approche composant où on réutilise sans arrêt des fragments.

Des rythmes de développement effrénés

B : Du coup, cela raccourci les cycles de développement ?

YC. Oui, c’est le deuxième changement important. Les géants du web comme Google, Amazon ou Facebook sont des experts en la matière. Google modifie 50 % de ses modules tous les mois. Du code est fabriqué sans arrêt. Et la façon dont le code est fait importe autant que le résultat. Quand je travaillais chez Bouygues Telecom sur les « box », nous avions à faire face à des composants matériels instables et incomplets. Ce n’est pas une question de compétence, nous avions d’excellents fournisseurs, mais le rythme d’adaptation du silicium pour suivre les évolutions des protocoles tels que HDMI était infernal. La partie logicielle devait cacher les limites du matériel et s’adapter au rythme très rapide de mises à disposition du matériel. Pour réussir dans ce monde de l’électronique grand-public, il est vital de savoir reconstruire son logiciel tous les jours.

Avec les clients au centre des préoccupations

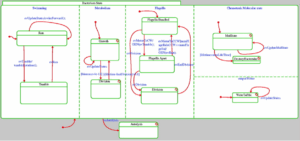

B : Pour raccourcir les cycles de développement, vous essayez de faire passer vos équipes au « lean startup ». Qu’est-ce que ce signifie ?

YC : C’est une manière de faire des applications en mode « centré client » et « incrémental ». Cela revient à sortir un produit minimal le plus vite possible, le mettre entre les mains des clients, regarder comment ils l’utilisent, et adapter le produit pour en proposer une nouvelle version rapidement. Ce type d’agilité n’est pas naturel pour des grands groupes. J’essaie de mettre cela en place dans les projets que je dirige. C’est une centaine de personnes qui travaillent ensemble avec des profils très différents : spécialistes du marketing, développeurs, designers. Nous essayons de mélanger tout ça.Le livre d’Octo Les géant du web m’a beaucoup inspiré. Avec l’informatique agile, le logiciel est vivant, il bouge sans arrêt tout en étant au cœur du processus de valeur de l’entreprise et en mettant le client au centre de ses préoccupations.

Redécouvrir l’amour du code

B : Cela sonne comme le début d’une nouvelle ère ?

YC : On se retrouve comme à la belle époque de l’informatique. Il faut aimer le code ! Au début de l’informatique, les développeurs vivaient dans leur code et ils aimaient ça. Puis on a changé de modèle. Quelqu’un écrivait des spécifications d’une application (N.D.L.R. une description détaillée de ce qu’il fallait réaliser), et des développeurs, peut-être à l’autre bout du monde, écrivaient les programmes. Ce modèle, très à la mode entre 1980 et 2000, est un modèle qui se meurt. En éloignant le concepteur de l’application du développeur, on avait perdu l’artisanat du développement de code. Aujourd’hui, avec le développement agile, on a retrouvé la proximité, le contact, l’amour du code.

On maitrise le code avec des pratiques qui reviennent à la mode comme le pair programming (N.D.L.R. le développement d’un programme en binôme sur le même ordinateur). Les développeurs ont besoin d’une unité de lieu, de contact constant. Cela dit, l’agence digitale d’Axa travaille avec des développeurs basés à Barcelone. Nous faisons de l’agile distribué, autrement dit nous travaillons comme si nous étions dans la même pièce. Les réunions quotidiennes se font via Skype, debout pour éviter qu’elles trainent en longueur. Faire de l’agile à distance est compliqué. Ce n’est bien sûr pas comparable à l’alchimie d’une équipe qui vit ensemble, mais c’est possible.

B : Qu’est-ce que ces changements impliquent pour les développeurs ?

YC : Le changement quotidien des applications revalorise le travail des développeurs. Ils sont invités à apporter plus d’eux-mêmes dans le produit, mais ce n’est pas toujours évident. Dans le fonctionnement de l’Agence Digitale, nous avons créé un budget « exploration » pour les développeurs, mais il faut faire attention à ne pas le voir absorber pas les besoins opérationnels courants.

B : Quel est le profil type du développeur que vous recherchez ?

YC : Le profil type du développeur dans les startups modernes, c’est celui de l’étudiant américain, moitié codeur, moitié généraliste. Je pense, qu’il y a eu un retournement dans les compétences recherchées. À la fin des années 90, la startup idéale de la Silicon Valley était très technique, avec par exemple des développeurs Russes ou Israéliens. À l’heure actuelle, les startups sont moins techniques car elles sont passées du B2B au B2C (N.D.L.R, de la vente vers d’autres entreprise à la vente au grand public), et font appel à un ensemble plus large de compétences. Leurs développeurs ont moins besoin d’être des informaticiens brillants. Il faut par contre qu’ils comprennent bien les aspects métiers de l’application, l’expérience client, qu’ils puissent imaginer ce qui plaira.

B : Vous devez quand même innover en permanence ; comment faites-vous ?

YC : Il est difficile de concurrencer les plus grands qui innovent sans arrêt. Pour innover en permanence dans un monde très concurrentiel, nous ne pouvons pas nous permettre de le faire seul. Nous sommes emmenés à faire de l’innovation ouverte (open innovation en anglais) au sens logiciel du terme, c’est-à-dire en nous appuyant sur une plateforme ouverte à nos partenaires et des API (*). Développer seul est épuisant, la seule façon d’y arriver est de participer à un écosystème, avec des sociétés qui ont choisi de développer des logiciels ensemble.

Le Big data s’installe au cœur de l’informatique

B : Vous n’avez pas mentionné le sujet à la mode, le Big Data ?

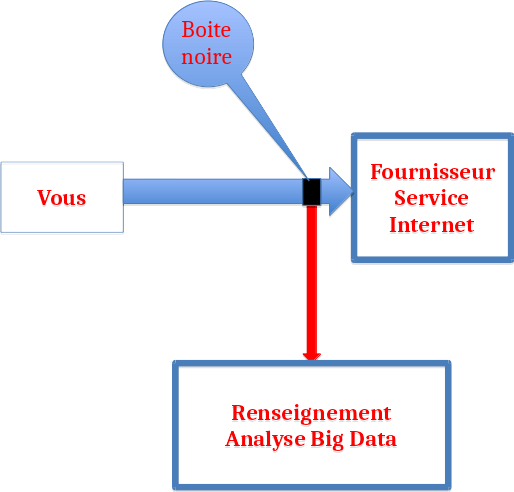

YC : Ce qui se passe autour de la donnée à l’heure actuelle est un changement que je pressens mais que je ne vis pas encore contrairement aux changements que j’ai déjà mentionnés. Coder et construire des algorithmes nécessitent maintenant de « penser données ». Pour résoudre des problèmes, avant, on cherchait des algorithmes très complexes sur peu de données. Aujourd’hui, on revisite certains problèmes en se focalisant sur des algorithmes simples, mais s’appuyant sur des données massives. On découvre de nouveaux problèmes sans arrêt, où la valeur est plus dans la donnée que dans l’algorithme. Quand Google achète une startup à l’heure actuelle, il s’intéresse surtout aux données qu’elle possède.

B : Quelles conséquences ce recentrage sur les données aura sur Axa ?

YC : Dans le futur, je vois Axa faire du machine learning à haute dose. La mission d’Axa est de protéger ses clients dans des domaines comme la santé ou la maison. Cela signifie donner des conseils personnalisés à nos assurés. Si vous avez 50 ans et que vous allez faire du ski, Axa pourra analyser les risques que vous courrez selon votre profil et partager l’information avec vous en allant jusqu’au coaching. Pour l’instant, notre application de coaching pour la santé est simple. Les conseils qu’elle propose sont limités, avec une personnalisation rudimentaire. Mais nous pensons qu’elle marchera nettement mieux avec un réseau social et un moteur de recommandations.

Les objets connectés

B : Vous croyez aussi aux objets connectés ?

YC : Je suis arrivé chez Axa au moment où tout le monde ne parlait que de ça, mais la plupart du temps le problème est envisagé à l’envers à partir des données sans se demander si le client a envie d’en générer et d’en partager. Pour le grand public, il n’y a qu’un petit nombre de cas où ces objets sont vraiment sympas, comme la balance Withings que j’adore. J’ai un cimetière d’objets connectés chez moi qui n’ont pas tenu leur promesse.

B : Pourquoi ne tiennent-ils pas leur promesse ?

YC : Les objets connectés ne deviennent vraiment intéressants que quand ils sont contextualisés, qu’ils fournissent la bonne information à la bonne personne au bon moment. Je suis fan du tracker Pulse de Whithings et j’en ai offert quelques uns autour de moi. Ma fille a adoré jouer avec pendant 15 jours, puis elle a trouvé l’objet limité. Par certain côté, son smartphone avait une meilleure connaissance d’elle rien qu’en étant connecté à son agenda.

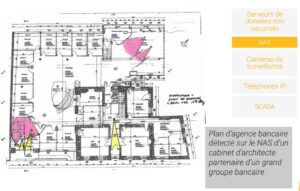

B : N’y a-t-il pas un risque avec l’utilisation de toutes ces données ? Dans le cadre d’une assurance par exemple, qui me garantit qu’elles ne seront pas utilisées contre moi, par exemple pour décider l’augmentation du prix de ma police d’assurance ?

YC : Je pense qu’il y aura à la fois des barrières légales et sociétales pour garantir que n’importe quelle donnée ne sera pas récupérée, utilisée à mauvais escient. Il est indispensable que de telles barrières soient établies.

B : Après des années dans la R&D autour de l’informatique, vous avez l’air d’aimer toujours autant ce que vous faites ? Qu’est-ce qui vous passionne vraiment aujourd’hui ?

YC : J’ai une mère qui vit seule dans sa maison à 80 ans. Comme beaucoup d’entre nous, je me sens donc très concerné par le devenir des personnes âgées. Nous sommes en train de développer un mini réseau social destiné aux séniors isolés et à leurs proches. Appelée « AreYouOk ? », cette application sortira d’abord au Japon. Je pense qu’il y a beaucoup de choses à faire pour les adultes dépendants. Notre application se servira des signaux d’objets connectés comme des téléphones portables avec ses senseurs comme l’accéléromètre, des montres. Il est assez simple de détecter un incident, une chute. Bientôt, nous pourrons aussi détecter une baisse de tonus, qui peut être le symptôme d’un problème de santé sérieux. Il suffit d’analyser les déplacements, leur vitesse… Dans les années qui viennent, nous allons pouvoir améliorer considérablement la manière de vivre des personnes âgées. C’est le genre de chose qui me donne vraiment envie chaque matin d’aller travailler…

Propos recueillis par Serge Abiteboul et Marie Jung

(*) API : Une interface de programmation, API pour Application Programming Interface, est une façade par laquelle un logiciel offre des services à d’autres logiciels. Elle consiste en une description détaillée qui explique comme des programmes consommateurs peuvent utiliser les fonctionnalités d’un programme fournisseur, par exemple un service Web ou une bibliothèque de programmes.