« Sex truly was the original sin »

Christos Papadimitriou

Ce que nous avons retenu de la sélection naturelle, c’est que les mieux adaptés, les plus forts, se reproduisent et finissent par l’emporter, et pour ce qui est de la génétique, c’est qu’on prend au hasard 50% des gènes de chacun des deux membres d’un couple pour obtenir un nouvel individu. Christos Papadimitriou, professeur à Berkeley, et ses collaborateurs étudient ces phénomènes. Christos est un des plus brillants chercheurs en informatique. Il s’est aussi intéressé, entre autre, à la finance, et la biologie. Nous allons essayer de vous présenter son point de vue, en le simplifiant à outrance tout en le prolongeant aussi. Si vous lisez l’anglais, et si le sujet vous intéresse, n’hésitez pas à aller lire un article plus technique [1].

Si par chance, on a obtenu un individu avec des gènes d’enfer, il se reproduit et ses enfants n’héritent que de la moitié de ses gènes. Cela se dilue à chaque génération. La reproduction sexuée détruit-elle ce qui marche bien ? Est-elle débile ? Et pourtant… La reproduction sexuée est la norme dans la nature, la reproduction asexuée rare. Pourquoi ? Les chercheurs ne sont pas d’accord sur les explications. Christos et ses collègues proposent une théorie passionnante. En fait, ils montrent que c’est à cause de l’effet de dilution que la reproduction sexuée « gagne ».

Une analogie est celle de l’investissement boursier. On pourrait imaginer qu’une bonne stratégie consiste à acheter quelques rares titres super performants. Mais en fait un bon investisseur va varier son portefeuille, achetant aussi des titres qui réussissent moins bien, pour pouvoir s’adapter à des changements de l’environnement bancaire. La reproduction asexuée serait parfaite dans une nature figée. Mais la nature change sans cesse, et la reproduction est bien plus à même de suivre ses transformations. C’est cette intuition qui conduit les investisseurs à panacher leurs portefeuilles.

Christos et ses collègues ont démontré cette thèse dans des simulations informatiques que nous allons vous expliquer. Pour cela considérons deux algorithmes très utilisés en informatique. Dans les deux cas, on part d’une population de candidats possibles pour résoudre un problème particulier et on essaie d’aller vers des candidats de plus en plus performants pour résoudre ce problème. Très grossièrement :

- Les algorithmes de recuit simulé et la reproduction asexuée. On laisse chaque individu se reproduire en se modifiant aléatoirement. Pour choisir au hasard qui se reproduit, on privilège ceux qui sont le plus performants.

- Les algorithmes génétiques et la reproduction sexuée. On choisit au hasard deux individus et on les combine pour obtenir un nouvel individu. Là aussi, on biaise le processus en laissant les « meilleurs » se reproduire plus que les autres.

Si on donne un problème fixe aux algorithmes génétiques, qui semblent pourtant imiter la solution majoritaire dans la nature, ils marchent moins bien que les algorithmes de recuit simulé. Mais si on laisse le problème muter sans arrêt, c’est le contraire qui se passe. La reproduction sexuée est mieux adaptée dans un monde en changement perpétuel.

Une remarque essentielle est que la reproduction sexuée favorise les systèmes dont on peut combiner efficacement deux individus. Dans la nature, cela conduit donc à des systèmes biologiques se reproduisant de manière sexuée. En informatique, on est confronté à une difficulté, celle de combiner deux individus. Que convient-il de recombiner pour retrouver dans les algorithmes sexués, l’efficacité constatée dans la nature ? Un petit détour par la fiction s’impose.

Isaac Asimov a imaginé, dans la nouvelle « What is this thing called love » [2], une race extraterrestre ne connaissant que la reproduction asexuée (un parent donne naissance, tout seul, à un enfant qui lui ressemble beaucoup), et ayant appris que sur la planète Terre une race se reproduisait de manière sexuée (deux parents mélangeant leurs gènes pour donner un enfant). Pour eux, si c’est le cas, il leur faut absolument détruire cette race sans tarder, car un tel processus permettra fatalement aux humains de donner naissance un jour à une race supérieure qui dominera l’univers, du fait des possibilités infinies d’amélioration de leurs capacités, et ce de manière beaucoup plus rapide que les autres races. L’anecdote de l’histoire est qu’ils enlèvent un couple de terriens, et leur demandent naïvement de leur faire une démonstration de reproduction sexuée. La femme et l’homme, dignes représentants de la morale puritaine qu’Asimov caricature ici, refusent d’une manière telle que les extraterrestres repartent, convaincu que toutes ces histoires de reproduction sexuée ne sont qu’élucubrations de leurs savants, et qu’ils peuvent laisser cette planète tranquille. Bien entendu, quelques minutes plus tard, le couple passe à l’action, finalement…

Isaac Asimov a imaginé, dans la nouvelle « What is this thing called love » [2], une race extraterrestre ne connaissant que la reproduction asexuée (un parent donne naissance, tout seul, à un enfant qui lui ressemble beaucoup), et ayant appris que sur la planète Terre une race se reproduisait de manière sexuée (deux parents mélangeant leurs gènes pour donner un enfant). Pour eux, si c’est le cas, il leur faut absolument détruire cette race sans tarder, car un tel processus permettra fatalement aux humains de donner naissance un jour à une race supérieure qui dominera l’univers, du fait des possibilités infinies d’amélioration de leurs capacités, et ce de manière beaucoup plus rapide que les autres races. L’anecdote de l’histoire est qu’ils enlèvent un couple de terriens, et leur demandent naïvement de leur faire une démonstration de reproduction sexuée. La femme et l’homme, dignes représentants de la morale puritaine qu’Asimov caricature ici, refusent d’une manière telle que les extraterrestres repartent, convaincu que toutes ces histoires de reproduction sexuée ne sont qu’élucubrations de leurs savants, et qu’ils peuvent laisser cette planète tranquille. Bien entendu, quelques minutes plus tard, le couple passe à l’action, finalement…

Mais imaginons que ces extraterrestres, au lieu d’être horrifiés à l’idée de cette race se reproduisant de manière sexuée, se soient au contraire mis en tête de tenter de l’imiter avec une compréhension du phénomène, et des expertises en biologie, très superficielles. Ils auraient par exemple tenté d’échanger des organes entre différents individus, genre « je prend le corps d’une personne pour y mettre le cerveau exceptionnel d’une autre ». Il est clair que le résultat aurait été en deçà de leurs espérances, à supposer qu’ils aient même réussi à garder les personnes en vie. Car la reproduction sexuée se déroule dans la nature au niveau des chromosomes, et qu’un chromosome n’est pas une partie de la solution (l’organisme), mais une partie de la machinerie qui construit l’organisme via le phénomène éminemment complexe de la morphogénèse. Pour que la reproduction sexuée donne les résultats escomptés, il faut donc qu’elle s’effectue à un niveau suffisant de complexité pour que la substantifique moelle de ce qui rend un individu supérieur aux autres (dans un concours de beauté, ou en mathématiques) soit effectivement recombinée.

Mais imaginons que ces extraterrestres, au lieu d’être horrifiés à l’idée de cette race se reproduisant de manière sexuée, se soient au contraire mis en tête de tenter de l’imiter avec une compréhension du phénomène, et des expertises en biologie, très superficielles. Ils auraient par exemple tenté d’échanger des organes entre différents individus, genre « je prend le corps d’une personne pour y mettre le cerveau exceptionnel d’une autre ». Il est clair que le résultat aurait été en deçà de leurs espérances, à supposer qu’ils aient même réussi à garder les personnes en vie. Car la reproduction sexuée se déroule dans la nature au niveau des chromosomes, et qu’un chromosome n’est pas une partie de la solution (l’organisme), mais une partie de la machinerie qui construit l’organisme via le phénomène éminemment complexe de la morphogénèse. Pour que la reproduction sexuée donne les résultats escomptés, il faut donc qu’elle s’effectue à un niveau suffisant de complexité pour que la substantifique moelle de ce qui rend un individu supérieur aux autres (dans un concours de beauté, ou en mathématiques) soit effectivement recombinée.

Revenons aux algorithmes, et à l’autre face de l’informatique, lorsque celle-ci résout des problèmes hors de portée du mathématicien, en s’inspirant éventuellement de la nature, mais sans aucune obligation de réalisme. Ici également, ce qui rend une solution meilleure que les autres n’est pas forcément directement l’un des composants utilisés pour la représenter. Et un croisement qui se contentera d’échanger des « bouts de solutions » comme par exemple dans le modèle qu’utilise Christos, ne tirera effectivement pas partie de la puissance potentielle de la reproduction sexuée.

Prenons un exemple que les informaticiens adorent, par sa complexité malgré la simplicité de son énoncé, la résolution du problème dit « du voyageur de commerce » : un VRP doit visiter un certain nombre de villes en faisant le minimum de kilomètres. Une solution est donc décrite par la liste des villes dans l’ordre de parcours. Il est clair qu’ici, la méthode consistant à croiser deux listes en les coupant en deux au hasard et en raboutant le début de l’une avec la fin de l’autre ne permet même pas d’obtenir des nouvelles liste valides : il manquera quasiment inévitablement des villes dans les deux nouvelles listes. C’est d’ailleurs l’exemple qu’utilise Christos pour illustrer précisément la difficulté de concevoir un croisement par recombinaison basique de parties de solution. Mais un chercheur japonais a récemment proposé [3] un processus de croisement de deux listes, plutôt complexe, qui réussit l’exploit de mélanger deux listes en extrayant de chacune ce qui fait qu’elle est peut-être un début de bonne solution au problème, tout en contenant suffisamment de hasard pour créer cette race destinée inévitablement à dominer l’univers, c’est-à-dire ici trouver la meilleure solution possible pour notre VRP. Son algorithme génétique détient aujourd’hui plusieurs records du monde … sur des problèmes de VRP classiques, c’est-à-dire statiques.

Au fond, il existe plusieurs manières de pratiquer la sexualité, pour les algorithmes comme dans la vie, et toutes ne sont pas aussi performantes. Nous n’en sommes certainement qu’au début de cette direction de recherche mais elle est prometteuse.

Vous aviez peut-être l’impression que le sexe domine le monde. Vous aviez raison, mais peut-être pas pour les bonnes raisons…

Serge Abiteboul, Inria & ENS Cachan, and Marc Schoenauer, Inria & Université Paris Saclay

Pour aller plus loin :

[1] Algorithms, games, and evolution, Erick Chastaina, Adi Livnatb, Christos Papadimitriouc,1, and Umesh Vaziranic

[2] Isaac Asimov. What Is This Thing Called Love? (short story). Voir l’article Wikipedia avec ce titre (en anglais, la page française correspondante étant à peu près vide).

[3] A powerful genetic algorithm using edge assembly crossover for the traveling salesman problem. Yuichi Nagata and Shigenobu Kobayashi. INFORMS Journal on Computing, 25(2):346-363, 2013.

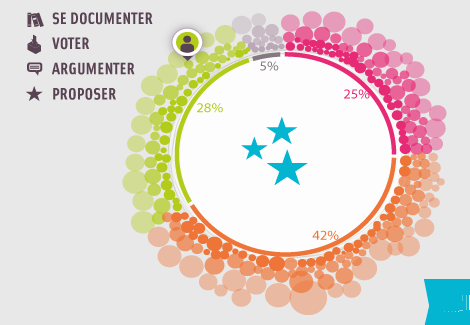

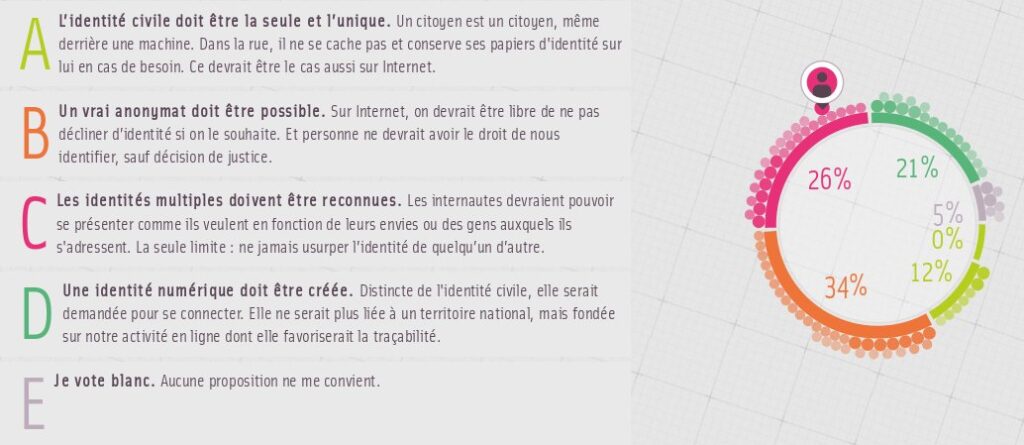

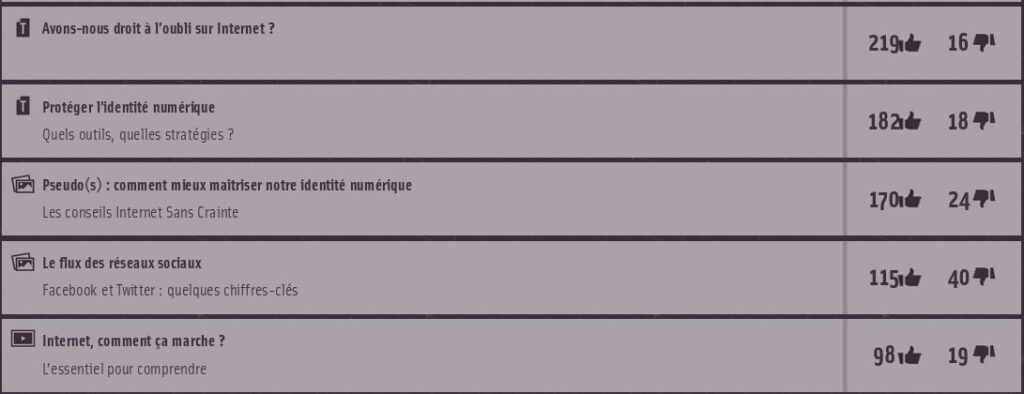

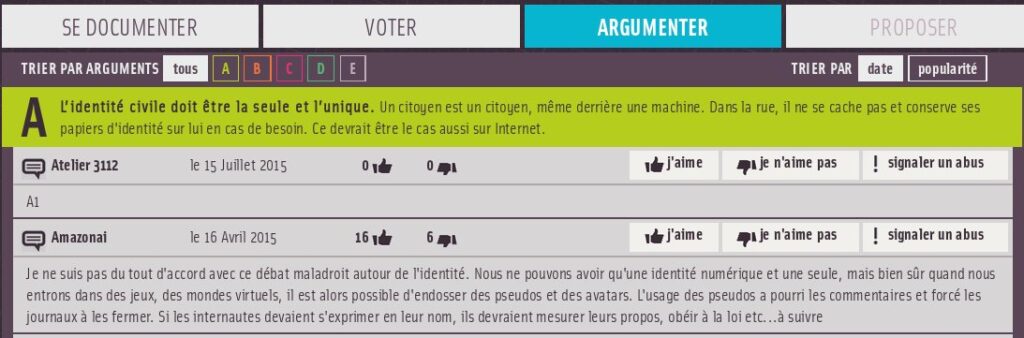

L’Isoloir se présente sous la forme d’une machine à voter qui permet « d’exprimer une opinion », puis de se documenter afin « d’approfondir des choix » et « de formuler des propositions » de lois éclairées. L’isoloir propose aussi un

L’Isoloir se présente sous la forme d’une machine à voter qui permet « d’exprimer une opinion », puis de se documenter afin « d’approfondir des choix » et « de formuler des propositions » de lois éclairées. L’isoloir propose aussi un

Et là quelqu’un (un mec, sûrement) va dire «mais pourquoi devraient-« elles´´ avoir un traitement particulier ?» … n’est ce pas l’aveu d’une dissymétrie ? Oui : une dissymétrie de la société [1]. Et dès qu’on se donne les moyens de ne pas créer cette dissymétrie, comme dans le cadre du concours

Et là quelqu’un (un mec, sûrement) va dire «mais pourquoi devraient-« elles´´ avoir un traitement particulier ?» … n’est ce pas l’aveu d’une dissymétrie ? Oui : une dissymétrie de la société [1]. Et dès qu’on se donne les moyens de ne pas créer cette dissymétrie, comme dans le cadre du concours