1. Bonjour Pierre-Emmanuel, pouvez-vous nous dire rapidement qui vous êtes, et quel est votre métier ?

Dessia Technologies est une jeune start-up fondée en 2017 par d’anciens ingénieurs de PSA Peugeot Citroën. Nous sommes basés en région parisienne et comptons aujourd’hui une quarantaine de collaborateurs. Notre mission est d’aider les grandes entreprises industrielles, notamment dans les secteurs automobile, aéronautique, ferroviaire et naval, à digitaliser leurs connaissances et à automatiser des tâches de conception grâce à l’intelligence artificielle. Nous travaillons avec des clients prestigieux comme Renault, Valeo, Safran, Airbus, Naval Group et Alstom. Nous utilisons par exemple des algorithmes d’IA pour automatiser le design des câblages électriques ou pour générer des architectures de batteries électriques. Forts de deux levées de fonds, nous sommes soutenus par quatre fonds d’investissement, dont celui d’Orano.

2. En quoi pensez-vous que l’IA a déjà transformé votre métier ?

L’intelligence artificielle a transformé en profondeur la manière dont les ingénieurs abordent la résolution de problèmes. Avant l’arrivée de ces technologies, les ingénieurs cherchaient principalement une ou deux solutions optimales pour répondre à un problème donné. Aujourd’hui, grâce à l’IA, ils explorent un éventail beaucoup plus large de solutions possibles. Les modèles génératifs, en particulier, permettent de proposer automatiquement de nombreuses alternatives et de hiérarchiser les options selon des critères précis. Cette évolution a modifié le rôle de ces ingénieurs, qui se concentrent désormais davantage sur l’analyse et la sélection des meilleures solutions pour leur entreprise.

3. À quels changements peut-on s’attendre dans le futur ? Quelles tâches pourraient être amenées à être automatisées ? À quel horizon ?

Dans le futur, l’interaction homme-machine sera profondément redéfinie grâce aux LLM (« Large Language Models » ou grands modèles de langage). Ces modèles remplaceront les interfaces graphiques traditionnelles par des interactions écrites ou orales, rendant les outils d’ingénierie plus intuitifs et accessibles. Les ingénieurs deviendront des gestionnaires de processus automatisés, orchestrant des agents autonomes pour exécuter des tâches techniques. La plupart des activités actuellement réalisées manuellement, comme la configuration de systèmes complexes ou la gestion de chaînes logistiques, seront automatisées d’ici 5 à 10 ans. Le rôle des ingénieurs évoluera donc vers un travail décisionnel, où ils valideront les choix proposés par les systèmes automatisés, favorisant une approche collaborative et stratégique.

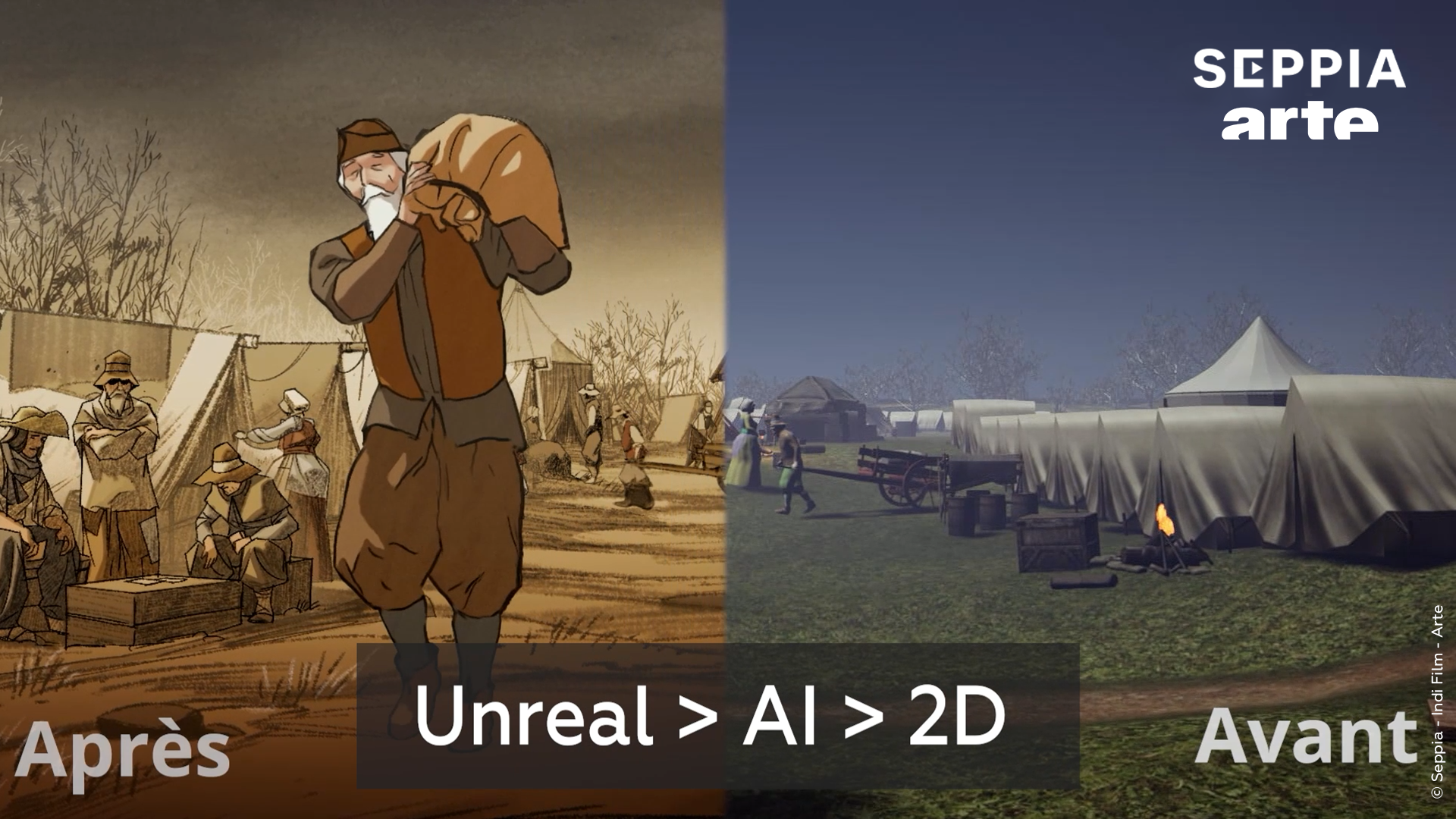

Ainsi, l’IA révolutionne particulièrement l’interaction et l’expérience de l’humain (UX) vis-à-vis des systèmes numériques. Les techniciens n’échangent plus via des pages HTML mais interagissent avec des éléments de savoir, grâce au langage naturel et via des messages communiquant leurs intentions de manière concise (prompt). L’IA générative permet donc de repenser les univers d’interaction traditionnels (via une « souris » et un écran) pour aller vers des univers d’interaction fluide en 3D et en langage naturel.

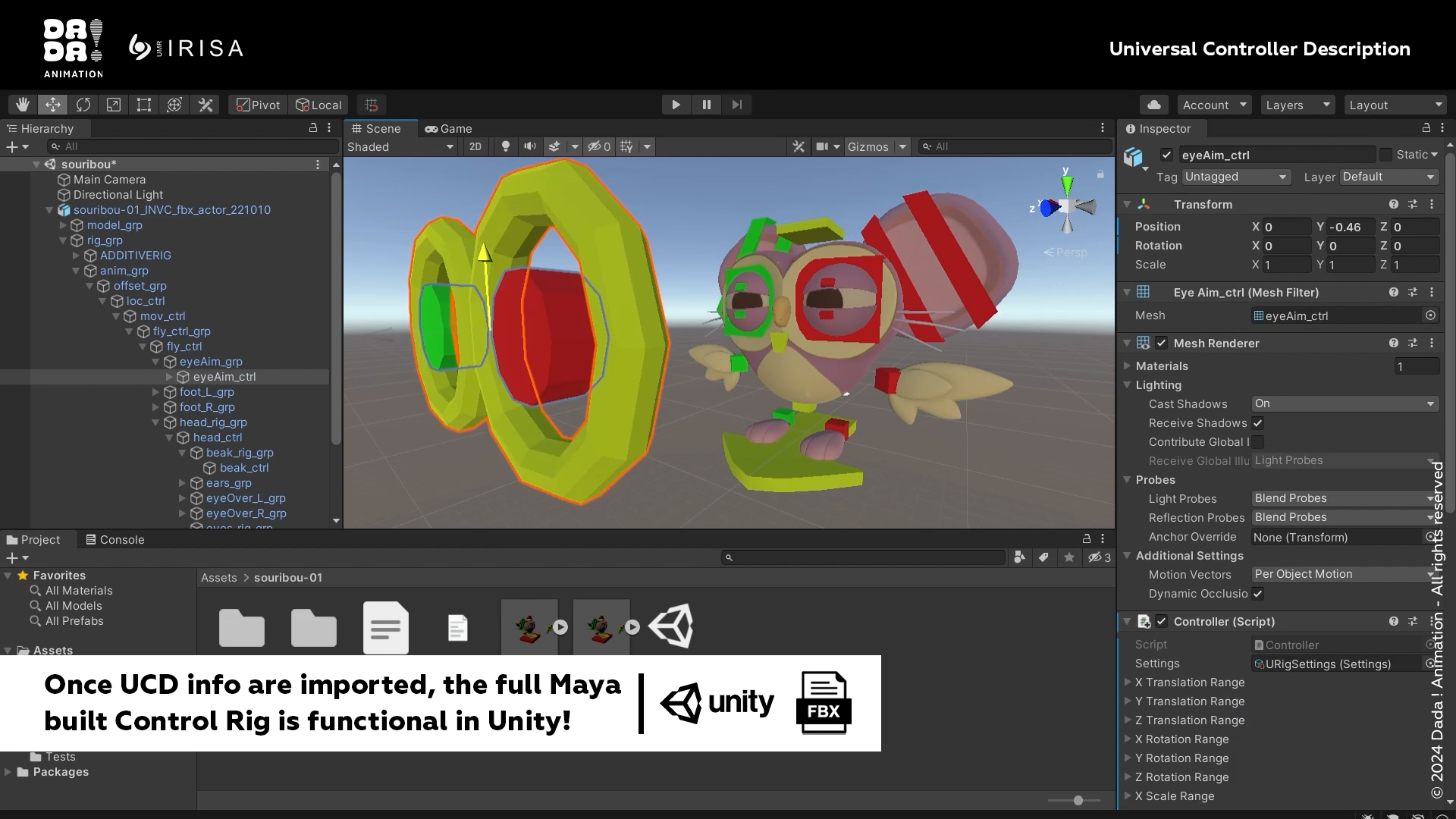

Demain, les interactions se feront via des agents : des automates réalisant des tâches pour le compte des ingénieurs. Les humains travailleront de concert avec des agents spécialisés, tels que les agents spécialistes de l’architecture électrique, avec ceux de l’architecture 3D et ceux des problèmes thermiques, qui se coordonneront entre eux. Ces agents permettront de résoudre des problèmes de conception en ingénierie qui sont actuellement insolubles, tels que concevoir une architecture de batterie ou un véhicule pour baisser l’empreinte carbone.

Une ou un ingénieur devra être capable de manipuler de nouvelles briques de savoir, par exemple pour s’assurer que la ligne d’assemblage d’une batterie ou d’un véhicule fonctionne bien, ou comment la faire évoluer, ainsi que le processus de conception. Il s’agit d’une mutation vers l’intégration et le développement continus (CI/CD) des produits manufacturés, réalisés en ingénierie concurrente.

On entre dans une ère dans laquelle se poseront des questions telles que celle de la sélection des tâches à automatiser et à déléguer à des agents, celle de la structuration du savoir de chaque ingénieur, de la manière de poser des questions, et de collecter des éléments de savoir.

Les ingénieurs devront aussi brainstormer, collaborer et travailler sur leur expertise pour prendre les décisions à partir des sorties des agents. La collaboration se fera au niveau décisionnel plutôt qu’au niveau opérationnel.

L’IA remet l’humain au centre. La numérisation a apporté un travail qui s’effectue de manière solitaire, seul derrière son écran. L’IA casse ce mode et pousse à développer un travail plus collaboratif ciblant les aspects stratégiques concernant la tâche à effectuer.

4. Si vous devez embaucher de nouveaux employés, quelles connaissances en informatique, en IA, attendez-vous d’eux suivant leurs postes ?

Nous recherchons des profils capables de s’adapter à l’écosystème technologique actuel et de tirer parti des outils modernes comme les LLM. Par exemple, dans les métiers marketing et vente, nous attendons une maîtrise des outils génératifs pour créer du contenu ou analyser des données de marché. Du côté des ingénieurs et data scientists, une bonne compréhension des algorithmes d’IA, des outils d’automatisation et des techniques de prototypage rapide est essentielle.

Ces remarques et les suivantes sur l’emploi des ingénieurs et autres collaborateurs concernent l’industrie en général et ne sont pas spécifiques à Dessia.

5. Pouvez-vous préciser quelles formations, à quel niveau ?

Les formations nécessaires dépendent des métiers, mais une tendance claire se dessine : la capacité d’adaptation et l’auto-apprentissage deviennent des compétences prioritaires. Pour les métiers techniques comme l’ingénierie et la data science, une spécialisation poussée reste essentielle, avec des profils de personnes ayant souvent obtenu un diplôme de doctorat ou ayant une expertise avancée en mathématiques et algorithmique. Pour d’autres postes, les recruteurs privilégient les candidats capables de se former rapidement sur des sujets émergents, au-delà de leur parcours académique, et de maîtriser les outils technologiques en constante évolution.

Les nouveaux employés devront ainsi s’adapter à de plus en plus d’exigences de la part des employeurs, ils devront avoir une expérience en IA, en pilotage de projets d’IA. Non seulement dans les domaines de l’ingénierie mais aussi des ventes. Il devront connaitre l’IA, utiliser les LLM, avoir de très bonnes qualités humaines et relationnelles.

6. Pour quelles personnes déjà en poste pensez-vous que des connaissances d’informatique et d’IA sont indispensables ?

Toutes les fonctions au sein d’une entreprise devront intégrer l’IA à leur activité, car cette technologie est en passe de devenir une nouvelle phase de digitalisation. Les entreprises qui ne suivent pas cette transformation risquent non seulement de perdre en compétitivité, mais aussi de rencontrer des difficultés à recruter des talents. L’IA deviendra un standard incontournable pour améliorer la productivité et attirer les jeunes générations, qui recherchent des environnements de travail modernes et connectés.

7. Ciblez-vous plutôt des informaticiens à qui vous faites apprendre votre métier, ou des spécialistes de votre métier aussi compétents en informatique ?

Nous ne faisons pas de distinction stricte. Chaque rôle dans l’entreprise doit intégrer l’IA, qu’il s’agisse de marketeurs utilisant des outils génératifs pour automatiser des campagnes ou d’ingénieurs chefs de projets s’appuyant sur l’IA pour optimiser la gestion de leurs plannings. Les développeurs travailleront en collaboration avec des agents IA pour accélérer leurs cycles de production, tandis que les CTO et managers utiliseront des outils intelligents pour piloter leurs indicateurs de performance. Cette polyvalence est au cœur de notre approche.

8. Pour les personnes déjà en poste, quelles formations continues vous paraissent indispensables ?

Nous privilégions des approches de transformation ciblées et pratiques plutôt que des formations classiques. Par exemple, un ou une ingénieure avec des compétences en VBA (note : Visual Basic for Applications) pourrait être accompagné pour se former à Python et à l’automatisation, augmentant ainsi sa valeur ajoutée dans l’entreprise. Un collègue secrétaire pourrait apprendre à utiliser des outils « no-code » ou des chatbots pour améliorer la gestion des intranets ou la création de contenus automatisés. Ces plans de transformation, accompagnés d’experts ou de consultants, permettront aux employés de devenir les acteurs de leur propre évolution.

9. Un message à passer, ou une requête particulière aux concepteurs de modèles d’IA ?

Nous appelons à une plus grande ouverture dans l’écosystème de l’intelligence artificielle, en particulier à travers l’open source. Cela permettrait de garantir une compétitivité équilibrée et d’éviter une concentration excessive de pouvoir entre les mains de quelques grands acteurs. Les modèles d’IA devraient être facilement personnalisables et utilisables en local pour protéger les données sensibles des entreprises. Cette approche favoriserait un écosystème plus collaboratif et innovant, permettant à un plus grand nombre d’entreprises de bénéficier des avancées technologiques.

Pierre-Emmanuel Dumouchel, fondateur et Directeur Général de la start-up Dessia Technologies, interviewé, par Pascale Vicat-Blanc, avec l’aide Erwan Le Merrer, avec le concours de la SIF.

Michel LEDUC a participé à la création d’une des premiers ordinateurs personnels en France. En plus des foyers, cet ordinateur a aussi pénétré les écoles ce qui fait que ce petit TO7 est un peu connu. Michel nous narre cette histoire à l’occasion de la sortie d’un livre sur cette aventure. Pierre Paradinas et Benjamin Ninassi.

Michel LEDUC a participé à la création d’une des premiers ordinateurs personnels en France. En plus des foyers, cet ordinateur a aussi pénétré les écoles ce qui fait que ce petit TO7 est un peu connu. Michel nous narre cette histoire à l’occasion de la sortie d’un livre sur cette aventure. Pierre Paradinas et Benjamin Ninassi.

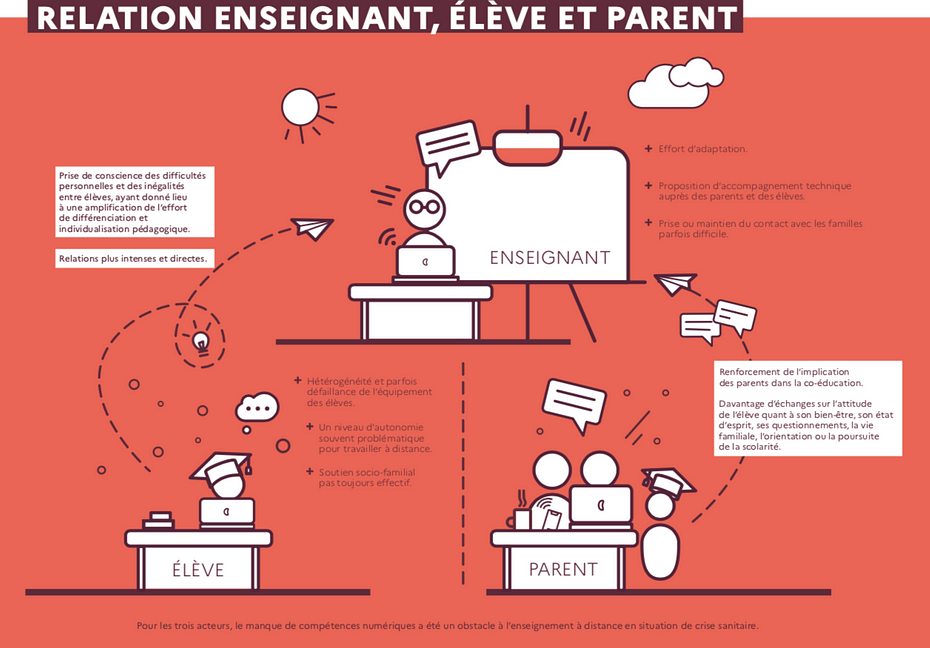

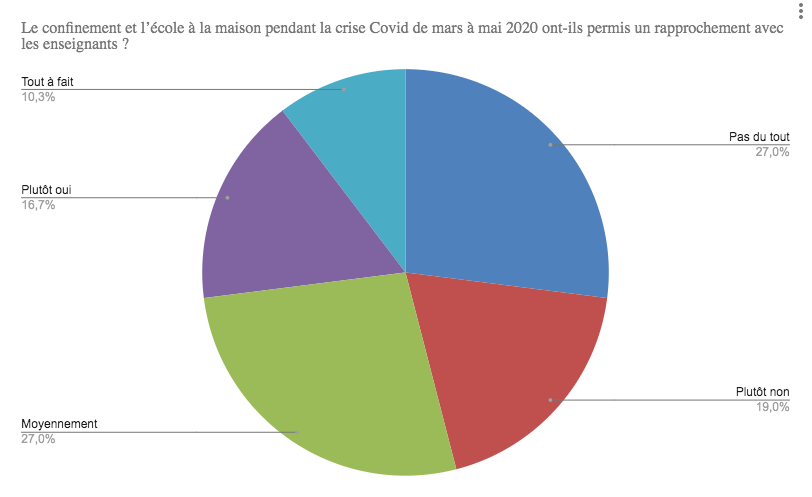

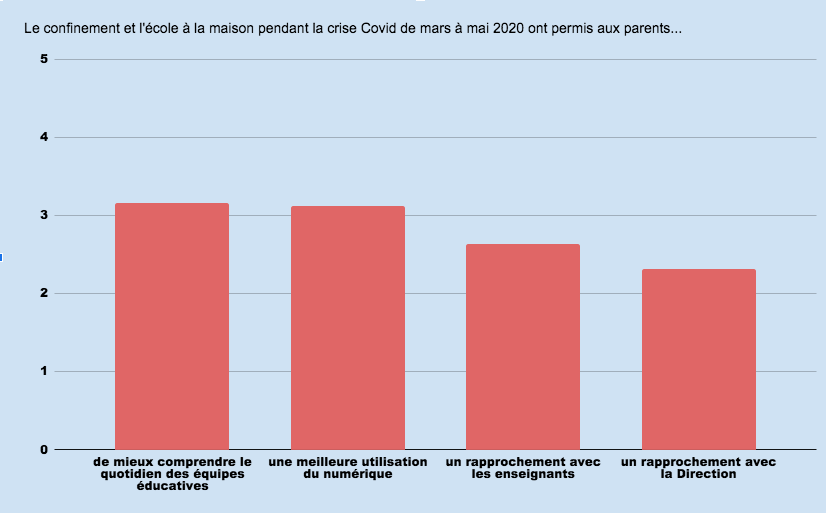

Quand on parle de numérique et d’éducation, on oublie souvent que le premier lieu éducatif ainsi que d’usage du numérique est … dans la famille. Avec la crise sanitaire, l’expansion des usages du numérique entre la maison et l’école nécessite encore plus de prendre le temps de la réflexion. C’est ce que nous invite à faire, dans une série de trois articles,

Quand on parle de numérique et d’éducation, on oublie souvent que le premier lieu éducatif ainsi que d’usage du numérique est … dans la famille. Avec la crise sanitaire, l’expansion des usages du numérique entre la maison et l’école nécessite encore plus de prendre le temps de la réflexion. C’est ce que nous invite à faire, dans une série de trois articles,