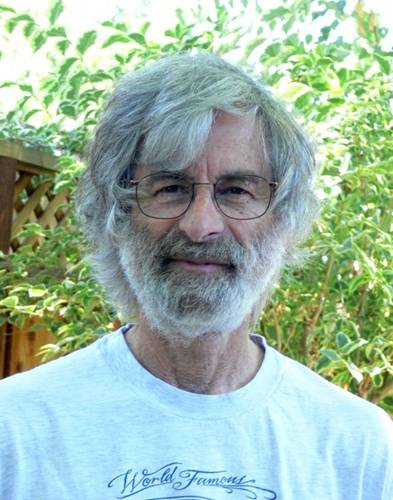

Françoise Combes, astronome à l’Observatoire de Paris et membre de l’Académie des Sciences (lien Wikipédia), a un petit bureau avec un tout petit tableau blanc, des étagères pleines de livres, un sol en moquette, et deux grandes colonnes de tiroirs étiquetées de sigles mystérieux. Au mur, des photos de ciels étoilés. Elle parle avec passion de son domaine de recherche, et met en exergue le rôle fondamental qu’y joue l’informatique.

Entretien réalisé par Serge Abiteboul et Claire Mathieu

La naissance des galaxies…

B : Peux-tu nous parler de tes sujets de recherche ? Vu de l’extérieur, c’est extrêmement poétique : « Naissance des galaxies », « Dynamique de la matière noire » …

FC : La question de base, c’est la composition de l’univers. On sait maintenant que 95% est fait de matière noire, d’énergie noire, et très peu de matière ordinaire, qui ne forme que les 5% qui restent. Mais on ignore presque tout de cette matière et de cette énergie noire. Les grands accélérateurs, contrairement à ce qu’on espérait, n’ont pas encore trouvé les particules qui forment la matière noire. On a appris vers l’an 2000 grâce aux supernovae que l’expansion de l’univers était accélérée. Mais la composition de l’univers que l’on connaissait alors ne permettait pas cette accélération ! Il fallait un composant pouvant fournir une force répulsive, et c’est l’énergie noire qui n’a pas de masse, mais une pression négative qui explique l’accélération de l’expansion de l’univers. On cherche également maintenant de plus en plus en direction d’autres modèles cosmologiques qui n’auraient pas besoin de matière noire, des modèles de « gravité modifiée ».

B : Cette partie de ton travail est surtout théorique ?

FC : Non, pas seulement, il y a une grande part d’observation, indirecte évidemment, observation des traces des composants invisibles sur la matière ordinaire. On observe les trous noirs grâce à la matière qu’il y a autour. Les quasars, qui sont des trous noirs, sont les objets les plus brillants de l’univers. Ils sont au centre de chaque galaxie, mais la lumière piégée par le trou noir n’en sort pas ; c’est la matière dans le voisinage immédiat, qui tourne autour, et progressivement tombe vers le trou noir en spiralant, qui rayonne énormément. Ce qui est noir et invisible peut quand même être détecté et étudié par sa « signature » sur la matière ordinaire associée.

Pour mieux étudier la matière noire et l’énergie noire, plusieurs télescopes en construction observeront pratiquement tout le ciel à partir des années 2018-2020, comme le satellite européen Euclid, ou le LSST (Large Synoptic Survey Telescope) et le SKA (Square Kilometer Array). Le LSST par exemple permettra d’observer l’univers sur un très grand champ (10 degrés carrés), avec des poses courtes de 15 secondes pendant 10 ans. Chaque portion du ciel sera vue environ 1000 fois. Même dans une nuit, les poses reviendront au même endroit toutes les 30 minutes, pour détecter les objets variables : c’est une révolution, car avec cet outil, on va avoir une vue non pas statique mais dynamique des astres. Cet instrument fantastique va détecter des milliers d’objets variables par jour, comme les supernovae, sursauts gamma, astéroides, etc. Il va regarder tout le ciel en 3 jours, puis recommencer, on pourra sommer tous les temps de pose pour avoir beaucoup plus de sensibilité.

Chaque nuit il y aura 2 millions d’alertes d’objets variables, c’est énorme ! Ce n’est plus à taille humaine. Il faudra trier ces alertes, et le faire très rapidement, pour que d’autres télescopes dans le monde soient alertés dans la minute pour vérifier s’il s’agit d’une supernova ou d’autre chose. Il y aura environ 30 « téraoctets » de données par nuit ! Des supernovae, il y en aura environ 300 par nuit sur les 2 millions d’alertes. Pour traiter ces alertes, on utilisera des techniques d’apprentissage (« machine learning »).

B : Qui subventionne ce matériel ?

FC : Un consortium international dont la France fait partie et où les USA sont moteur, mais il y a aussi des sponsors privés. Le consortium est en train de construire des pipelines de traitement de données, toute une infrastructure matérielle et logicielle.

La place de l’informatique

B : La part du « matériel informatique » dans ce télescope est très importante ?

FC : Le télescope lui-même, de 8m de diamètre, est assez ordinaire. L’innovation est dans l’optique et les instruments pour avoir un grand champ, qui sont une partie importante du coût ; les images seront prises simultanément avec six filtres de couleur. Le traitement des données nécessite des super ordinateurs qui forment une grande partie du coût.

B : Alors, aujourd’hui, une équipe d’astronomes, c’est pluridisciplinaire ?

FC : Oui, mais c’est aussi très mutualisé. Il y a des grands centres (Térapix à l’Institut d’Astrophysique de Paris par exemple) pour gérer les pipelines de données et les analyser avec des algorithmes. Ainsi, on se prépare actuellement à dépouiller les données d’Euclid, le satellite européen qui sera lancé en 2020, dont le but est de tracer la matière noire et l’énergie noire, notamment avec des lentilles gravitationnelles. Les images des millions de galaxies observées seront légèrement déformées, car leur lumière est déviée par les composants invisibles sur la ligne de visée; il faudra reconstituer la matière noire grâce cette déformation statistique.

B : Quels sont les outils scientifiques de base ? Des mathématiques appliquées ?

FC : Oui. La physique est simple. Les simulations numériques de formation des galaxies dans un contexte cosmologique sont gigantesques : il s’agit de problèmes à N-corps avec 300 milliards de corps qui interagissent entre eux ! Le problème est résolu par des algorithmes basés soit sur les transformées de Fourier soit sur un code en arbre, et à chaque fois le CPU croît en N log N. On fait des approximations, des développements en multi-pôles. En physique classique, ou gravité de Newton, cela va vite. Mais pour des simulations en gravité modifiée, là, c’est plus compliqué, il y a des équations qui font plusieurs pages. Il y a aussi beaucoup de variantes de ces modèles, et il faut éviter de perdre son temps dans un modèle qui va se révéler irréaliste, ou qui va être éliminé par des observations nouvelles. Il y a donc des paris à faire.

B : Tu avais dit que vous n’étiez pas uniquement utilisateurs d’informatique, qu’il y a des sujets de recherche, spécifiquement en informatique, qui découlent de vos besoins ?

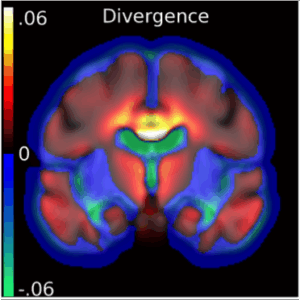

FC : Je pensais surtout à des algorithmes spécifiques pour résoudre nos problèmes particuliers. Par exemple, sur l’époque de ré-ionisation de l’univers. Au départ l’univers est homogène et très chaud, comme une soupe de particules chargées, qui se recombinent en atomes d’hydrogène neutre, dès que la température descend en dessous de 3000 degrés K par expansion, 400 000 ans après le Big Bang. Suit une période sombre et neutre, où le gaz s’effondre dans les galaxies de matière noire, puis les premières étoiles se forment et ré-ionisent l’univers. Ce qu’on va essayer de détecter, (mais ce n’est pas encore possible actuellement) c’est les signaux en émission et absorption de l’hydrogène neutre, pendant cette période où l’univers est constitué de poches neutres et ionisées, comme une vinaigrette avec des bulles de vinaigre entourées d’huile. C’est pour cela que les astronomes sont en train de construire le « square kilometer array » (SKA). Avec ce télescope en ondes radio, on va détecter l’hydrogène atomique qui vient du début de l’univers, tout près du Big bang ! Moins d’un milliard d’années après le Big bang, son rayonnement est tellement décalé vers le rouge (par l’expansion) qu’au lieu de 21cm, il a 2m de longueur d’onde ! Les signaux qui nous arrivent vont tous à la vitesse de la lumière, et cela met 14 milliards d’années à nous parvenir – c’est l’âge de l’univers.

Le téléscope SKA est assez grand et sensible pour détecter ces signaux lointains en onde métrique, mais la grande difficulté vient de la confusion avec les multiples sources d’avant-plan : le signal qu’on veut détecter est environ 10000 fois inférieur aux rayonnements d’avant-plan. Il est facile d’éliminer les bruits des téléphones portables et de la ionosphère, mais il y a aussi tout le rayonnement de l’univers lui-même, celui de la Voie lactée, des galaxies et amas de galaxies. Comment pourra-t-on pêcher le signal dans tout ce bruit? Avec des algorithmes. On pense que le signal sera beaucoup plus structuré en fréquence que tous les avant-plans. On verra non pas une galaxie en formation mais un mélange qui, on l’espère, aura un comportement beaucoup plus chahuté que les avant-plans, qui eux sont relativement lisses en fréquence. Faire un filtre en fréquence pourrait a priori être une solution simple, sauf que l’observation elle-même avec l’interféromètre SKA produit des interférences qui font un mixage de mode spatial-fréquentiel qui crée de la structure sur les avant-plans. Du coup, même les avant-plans auront de la structure en fréquence. Alors, on doit concevoir des algorithmes qui n’ont jamais été développés, proches de la physique. C’est un peu comme détecter une aiguille dans une botte de foin. Il faut à la fois des informaticiens et des astronomes.

Il faut un super computer, rien que pour savoir dans quelle direction du ciel on regarde.

Le couple de galaxies en interaction Arp 87,

Le couple de galaxies en interaction Arp 87,

image du Hubble Space Telescope (HST), Credit NASA-ESA

B : Cela veut-il dire qu’il faut des astronomes qui connaissent l’informatique ?

FC : Les astronomes, de toute façon, connaissent beaucoup d’informatique. C’est indispensable aujourd’hui. Rien que pour faire les observations par télescope, on a besoin d’informatique. Par exemple le télescope SKA (et son précurseur LOFAR déjà opérationnel aujourd’hui à Nançay) est composé de « tuiles » qui ont un grand champ et les tuiles interfèrent entre elles. Le délai d’arrivée des signaux provenant de l’astre observé sur les différentes tuiles est proportionnel à l’angle que fait l’astre avec le zénith. Ce délai, on le gère de façon numérique. Ainsi, on peut regarder dans plusieurs directions à la fois, avec plusieurs détecteurs. Il faut un super computer, rien que pour savoir dans quelle direction du ciel on regarde.

Un astronome va de moins en moins observer les étoiles et les galaxies directement sur place, là où sont les télescopes. Souvent les observations se font à distance, en temps réel. L’astronome contrôle la position du télescope à partir de son bureau, et envoie les ordres d’observation par internet. Les résultats, images ou spectres arrivent immédiatement, et permettent de modifier les ordres suivants d’observation. C’est avec les télescopes dans l’espace qu’on a démarré cette façon de fonctionner, et cela s’étend maintenant aux télescopes au sol.

Ce mode d’observation à distance en temps réel nécessite de réserver le télescope pendant une journée ou plus pour un projet donné, ce qui n’optimise pas le temps de télescope. Il vaut mieux avoir quelqu’un sur place qui décide, en fonction de la météo et d’autres facteurs, de donner priorité à tel ou tel utilisateur. Du coup on fait plutôt l’observation en différé, avec des opérateurs sur place, par « queue scheduling ». Les utilisateurs prévoient toutes les lignes du programme (direction, spectre, etc.) qui sera envoyé au robot, comme pour le temps réel, mais ce sera en fait en différé. L’opérateur envoie le fichier au moment optimum et vérifie qu’il passe bien.

Selon la complexité des données, la calibration des données brutes peut être faite dans des grands centres avec des super computers. Ensuite, l’astronome reçoit par internet les données déjà calibrées. Pour les réduire et en tirer des résultats scientifiques, il suffit alors de petits clusters d’ordinateurs locaux. Par contre, les super computers sont requis pour les simulations numériques de l’univers, qui peuvent prendre des mois de calcul.

Que ce soit pour les observations ou les simulations, il faut énormément d’algorithmes. Leur conception se fait en parallèle de la construction des instruments. Les algorithmes sont censés être prêts lorsque les instruments voient le jour. Ainsi, lorsqu’un nouveau télescope arrive, il faut qu’il y ait déjà par exemple tous les pipelines de calibrations. Cette préparation est un projet de recherche à part entière. Tant qu’on n’a pas les algorithmes, l’instrument ne sert à rien: on ne peut pas dépouiller les données. Les progrès matériels doivent être synchronisés avec les progrès des algorithmes.

B : Est-ce que ce sont les mêmes personnes qui font la simulation de l’univers et qui font l’analyse des images ?

FC : Non, en général ce sont des personnes différentes. Pour la simulation de l’univers, on est encore très loin du but. Les simulations cosmologiques utilisent quelques points par galaxie, alors qu’il y a des centaines de milliards d’étoiles dans chaque galaxie. Des « recettes » avec des paramètres réalistes sont inventées pour suppléer ce manque de physique à petite-échelle, sous la grille de résolution. Si on change quelques paramètres libres, cela change toute la simulation. Pour aller plus loin, il nous faut aussi faire des progrès dans la physique des galaxies. Même dans 50 ans, nous n’aurons pas encore la résolution optimale.

B : Comment évalue-t-on la qualité d’une simulation ?

FC : Il y a plusieurs équipes qui ont des méthodes complètement différentes (Eulérienne ou « Adaptive Mesh Refinement » sur grille, ou Lagrangienne, code en arbre avec particules par exemple), et on compare leurs méthodes. On part des mêmes conditions initiales, on utilise à peu près les mêmes recettes de la physique, on utilise plusieurs méthodes. On les compare entre elles ainsi qu’avec les observations.

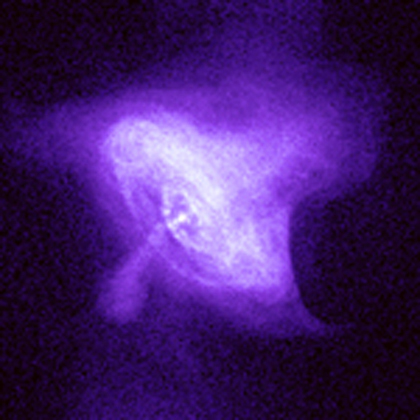

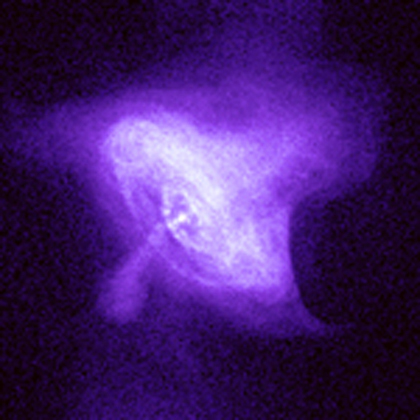

Image en rayons X du pulsar du Crabe, obtenue

Image en rayons X du pulsar du Crabe, obtenue

avec le satellite CHANDRA, credit NASA

B : Y a-t-il autre chose que tu souhaiterais dire sur l’informatique en astronomie ?

FC : J’aimerais illustrer l’utilisation du machine learning pour les pulsars. Un pulsar, c’est une étoile à neutron en rotation, la fin de vie d’une étoile massive. Par exemple, le pulsar du crabe est le résidu d’une supernova qui a explosé en l’an 1000. On a déjà détecté environ 2000 pulsars dans la Voie lactée, mais SKA pourra en détecter 20000 ! Il faut un ordinateur pour détecter un tel objet, car il émet des pulses, avec une période de 1 milliseconde à 1 seconde. Un seul pulse est trop faible pour être détecté, il faut sommer de nombreux pulses, en les synchronisant. Pour trouver sa période, il faut traiter le signal sur des millions de points, et analyser la transformée de Fourier temporelle. L’utilité de ces horloges très précises que sont les pulsars pour notre compréhension de l’univers est énorme. En effet, personne n’a encore détecté d’onde gravitationnelle, mais on sait qu’elles existent. L’espace va vibrer et on le verra dans le 15e chiffre significatif de la période des pulsars. Pour cela on a besoin de détecter un grand nombre de pulsars qui puissent échantillonner toutes les directions de l’univers. On a 2 millions de sources (des étoiles) qui sont candidates. C’est un autre exemple où il nous faut des algorithmes efficaces, des algorithmes de machine learning.

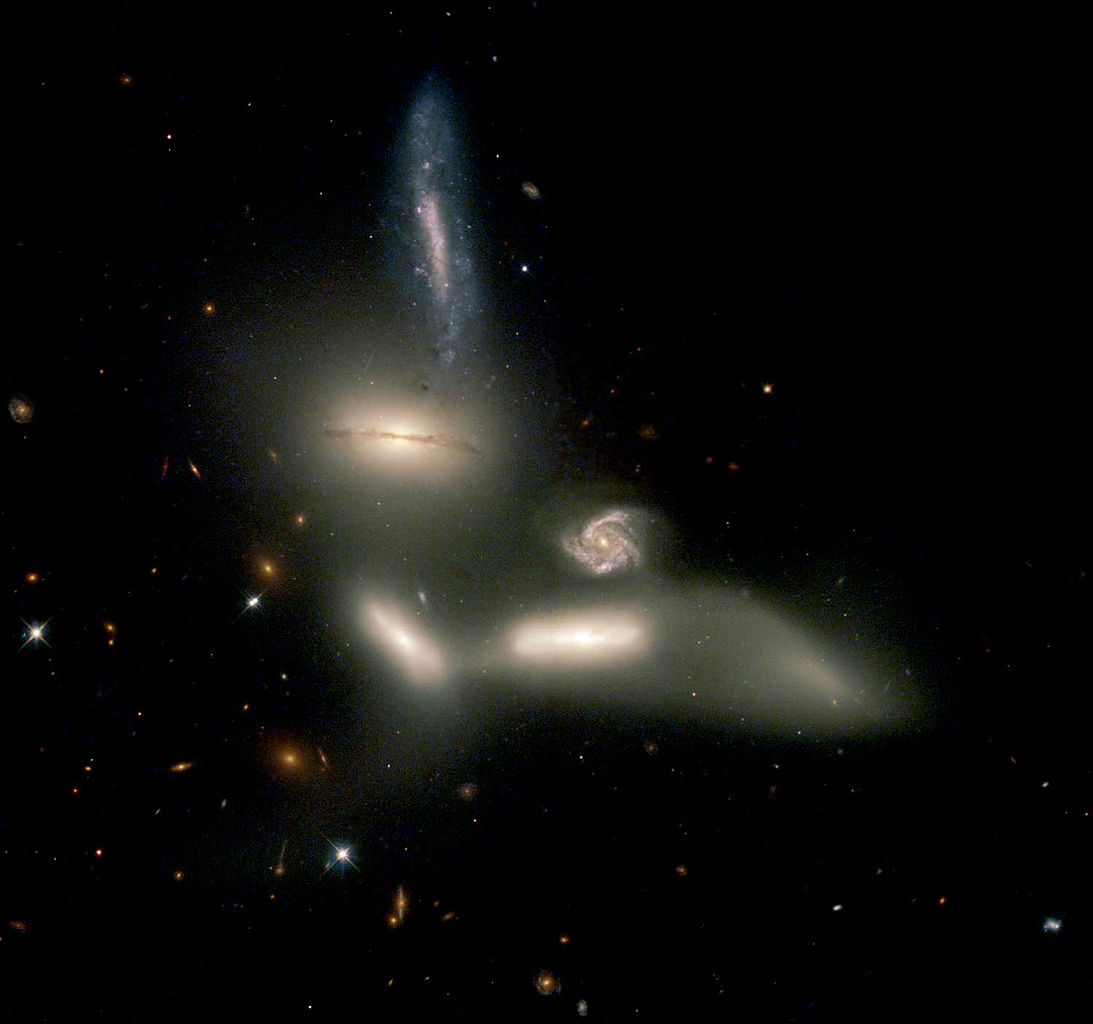

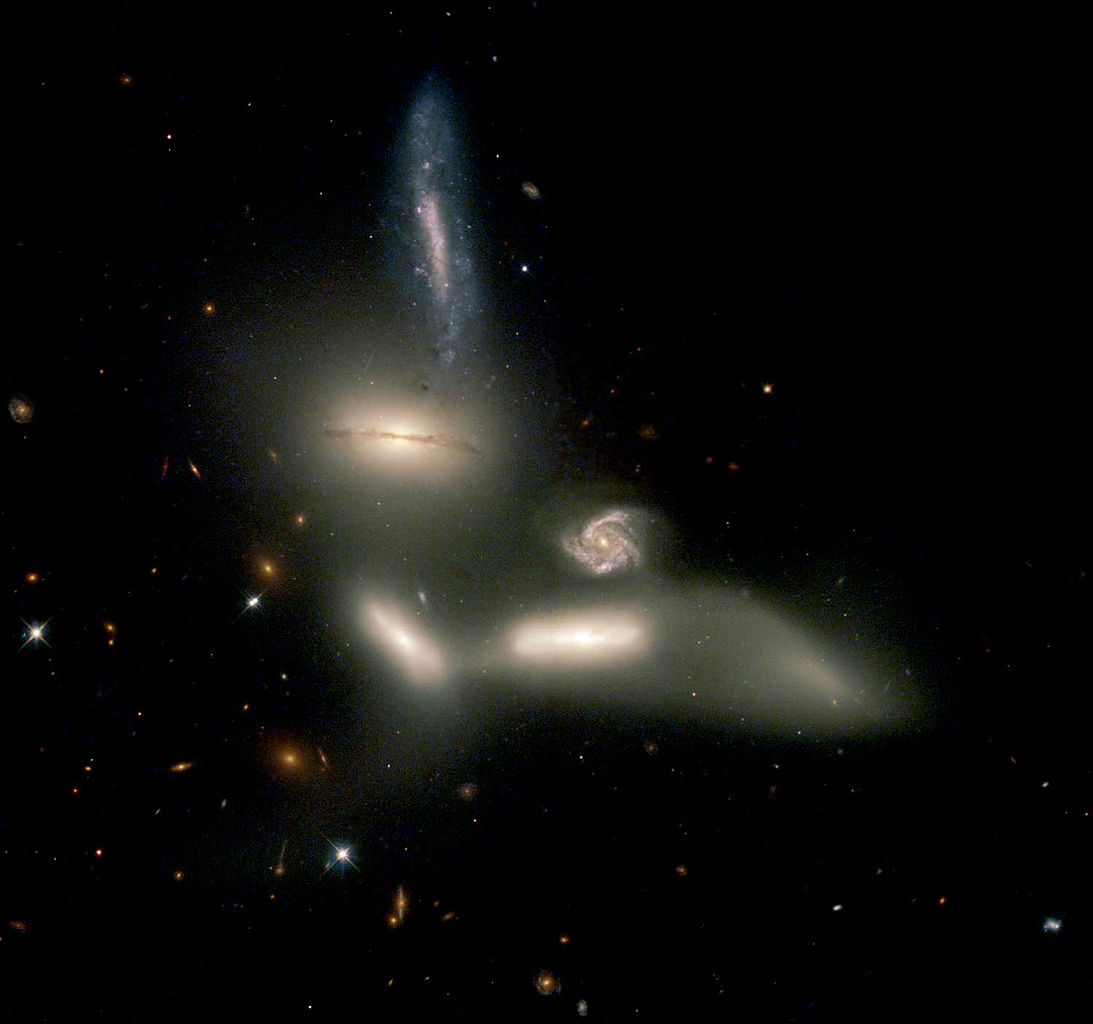

Le groupe compact de galaxies, appelé le Sextet

Le groupe compact de galaxies, appelé le Sextet

de Seyfert, image du Hubble Space Telescope (HST), Credit NASA-ESA

Hier et demain

B : L’astronomie a-t-elle beaucoup changé pendant ta carrière ?

FC : Énormément. Au début, nous utilisions déjà l’informatique mais c’était l’époque des cartes perforées.

B : L’informatique tenait déjà une place ?

FC : Ah oui. Quand j’ai commencé ma thèse en 1976 il y avait déjà des programmes pour réduire les données. Après les lectrices de cartes perforées, il y a eu les PC. Au début il n’y avait même pas de traitement de texte ! Dans les années qui suivirent, cela n’a plus trop changé du point de vue du contact avec les écrans, mais côté puissance de calcul, les progrès ont été énormes. L’astrophysique a énormément évolué en parallèle. Par exemple pour l’astrométrie et la précision des positions : il y a 20ans, le satellite Hipparcos donnait la position des étoiles à la milliseconde d’arc mais seulement dans la banlieue du soleil. Maintenant, avec le satellite GAIA lancé en 2013, on va avoir toute la Voie lactée. Qualitativement aussi, les progrès sont venus de la découverte des variations des astres dans le temps. Avant tout était fixé, statique, maintenant tout bouge. On remonte le temps aujourd’hui jusqu’à l’horizon de l’univers, lorsque celui-ci n’avait que 3% de son âge. Toutefois, près du Big bang on ne voit encore que les objets les plus brillants. Reste à voir tous les petits. Il y a énormément de progrès à faire.

B : Peut-on attendre des avancées majeures dans un futur proche ?

FC : C’est difficile à prévoir. Étant donné le peu que l’on sait sur la matière noire et l’énergie noire, est-ce que ces composants noirs ont la même origine ? On pourrait le savoir par l’observation ou par la simulation. La croissance des galaxies va être différente si la gravité est vraiment modifiée. C’est un grand défi. Un autre défi concerne les planètes extrasolaires. Actuellement il y en a environ 1000 détectées indirectement. On espère « imager » ces planètes. Beaucoup sont dans des zones théoriquement habitables – où l’eau est liquide, ni trop près ni trop loin de l’étoile. On peut concevoir des algorithmes d’optique (sur les longueurs d’onde) pour trouver une planète très près de l’étoile. Des instruments vont être construits, et les astronomes préparent les pipelines de traitement de données.

Le public

B : Il y a beaucoup de femmes en astrophysique?

FC : 30% en France mais ce pourcentage décroît malheureusement. Après la thèse, il faut maintenant faire 3 à 6 années de post doctorat en divers instituts à l’étranger avant d’avoir un poste, et cette mobilité forcée freine encore plus les femmes.

B : Tu as écrit récemment un livre sur la Voie lactée?

FC : Oui, c’est pour les étudiants et astronomes amateurs. Il y a énormément d’astronomes amateurs – 60000 inscrits dans des clubs d’astronomie en France. Quand je fais des conférences grand public, je suis toujours très étonnée de voir combien les auditeurs connaissent l’astrophysique. C’est de la semi-vulgarisation. Ils ont déjà beaucoup lu par exemple sur Wikipédia.

B : Peuvent-ils participer à la recherche, peut-être par des actions de type « crowd sourcing »?

FC : Tout à fait. Il y a par exemple le « Galaxy zoo ». Les astronomes ont mis à disposition du public des images de galaxies. La personne qui se connecte doit, avec l’aide d’un système expert, observer une image, reconnaître si c’est une galaxie, et définir sa forme. Quand quelqu’un trouve quelque chose d’intéressant, un chercheur se penche dessus. Cela peut même conduire à un article dans une revue scientifique. L’interaction avec le public m’intéresse beaucoup. C’est le public qui finance notre travail ; le public est cultivé, et le public doit être tenu au courant de toutes les merveilles que nous découvrons.

Le groupe compact de galaxies, appelé le Quintet

Le groupe compact de galaxies, appelé le Quintet

de Stepĥan, image du Hubble Space Telescope (HST), Credit NASA-ESA

Page personnelle

Page personnelle