Voilà quarante ans que nous célébrons les femmes le 8 mars, depuis 1975, année internationale de la femme, pour accuser réception de la lutte historique concernant l’amélioration des conditions de vie des femmes. Vaste programme, comme dirait l’autre. Toujours cet arrière goût d’inachevé… Pour l’occasion, Anne-Marie Kermarrec nous parle de grandes pionnières de l’informatique, aujourd’hui Ada Lovelace. Le premier programmeur de l’histoire était une programmeure ! Serge Abiteboul.

1967 : autant de bachelières que de bacheliers, pour la première fois. 2015 : à peine 10% de femmes dans les cursus d’ingénieurs. L’informatique continue de se sinistrer doucement mais surement. Au cours du congrès annuel de la SIF (Société informatique de France), consacré cette année à « Femmes et Informatique », nous n’avons pu que constater les statistiques en berne, qu’il s’agisse d’étudiantes, de chercheuses et enseignantes-chercheuses. Plus encore, à mesure que les grades augmentent, les femmes se raréfient. Same old story. D’aucun pourrait se réjouir du reste et conclure que l’informatique prend du galon, arguant du fait qu’une discipline qui se féminise est clairement en perte de prestige et de vitesse… Nous avons débattu deux jours sur les raisons de cet état de fait. Qui de l’image, des clichés, etc. …. et cette impuissance, prégnante, à inverser la tendance. Oui quelques idées flottent bien, comme de convaincre les filles qu’elles aiment aussi la technique, de revamper les cours d’informatique ou encore d’enseigner l’informatique dès le primaire. On attend toujours le déclic sociétal…

2014, si elle était le quarantième anniversaire de la légalisation de l’IVG, était aussi celle du centenaire d’Alan Turing, le père de l’informatique. Turing, malheureusement encore trop peu connu du grand public quand il devrait mériter au moins autant d’égards qu’Einstein. Tout le monde connaît l’espiègle moustachu qui tire la langue, quand bien même la théorie de la relativité échappe à la majorité des gens, ou encore Freud, dont on sait qu’il interprète les rêves. Turing, lui les aura réalisés. Pourtant, personne ne le connaît, quand la moitié de la planète tweete à longueur de journée, sur ses traces…

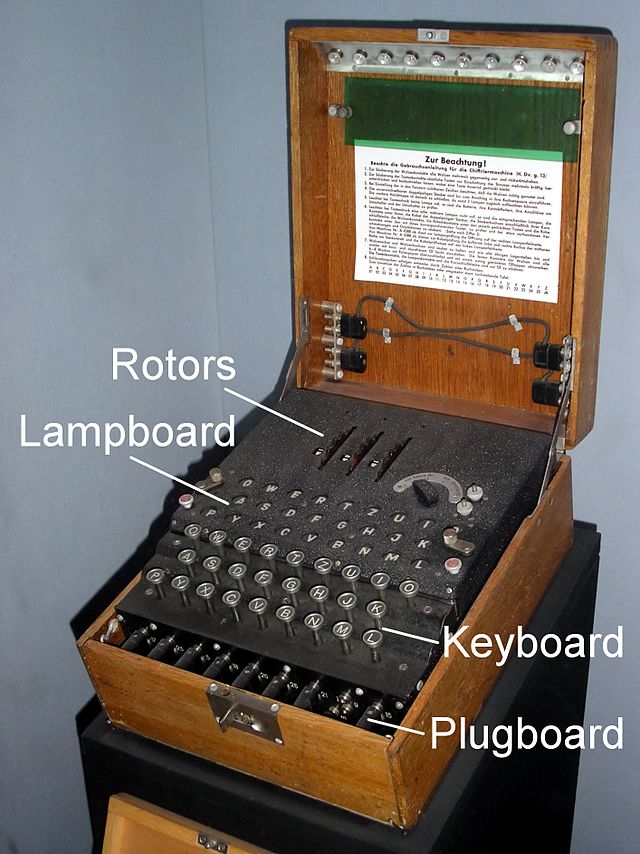

2015 commence bien. Hollywood s’en mêle. Deux films consacrés à des scientifiques de renom : Alan Turing (Imitation game) justement et Stephen Hawkings (The theory of everything). Imitation Game retrace les activités de Turing pendant la seconde guerre mondiale pour craquer Enigma, au creux de Bletchey Park, où mille délicates oreilles féminines interceptent les messages pendant que quelques cerveaux masculins s’évertuent à les décoder. Pourtant, déchainement de critiques : impossible de comprendre précisément comment Enigma a été craquée, le concept de la machine de Turing est à peine évoqué, pas plus que le test éponyme permettant de différencier intelligence artificielle et intelligence humaine, qui pourtant donne son titre au film, Turing a l’air d’un autiste, l’homosexualité est trop timidement affichée, etc. Soyons sérieux, quel scénariste, aussi talentueux soit-il, serait capable d’expliquer clairement la crypto au grand public dans un film hollywoodien ? Réjouissons nous plutôt que ce film ait du succès et permettent de mettre en lumière le père de l’informatique. Quand à The theory of everything, peut-être que le fait que Hawkings, lui même, ait rendu un verdict positif, suffira à faire taire les puristes des trous noirs.

Mais revenons à nos moutons, en cette veille de journée de la femme 2015, c’est une pionnière de l’informatique, que j’aimerais mettre sous le feu des projecteurs.

Ada Lovelace, Wikipedia

Ada Lovelace, Wikipedia

La visionnaire Ada Lovelace (1815-1852)

Ada Lovelace est le fruit des amours tumultueuses de Lord Byron, poète romantique dont le talent n’a d’égal que le goût pour les frasques amoureuses, père qu’elle ne connaitra jamais d’ailleurs, et de Anabella Milanke, mathématicienne, que Byron aimait à appeler sa « Princess of parallelograms »… De l’importance du niveau d’instruction des mères pour celle des jeunes filles. Poussée par sa mère, elle étudie les mathématiques. Elle rencontre à 17 ans, Charles Babbage, mathématicien, professeur à l’Université de Cambridge. Fascinée par les machines qu’il conçoit, Ada y consacrera une grande partie de sa courte vie.

Babbage, dont les travaux couvrent un spectre aussi large qu’hétéroclite, du pare-buffle pour locomotive à l’analyse des troncs pour y déceler l’âge des arbres, de l’invention du timbre poste unique aux premiers ordinateurs, conçoit sa machine à différence, sur les traces de la Pascaline de Pascal, initialement pour pallier les erreurs humaines et fournir ainsi des tables nautiques, astronomiques et mathématiques exactes, y incorporant des cartes perforées du métier Jacquard. Ce métier, inventé par Jacquard afin d’éviter aux enfants les travaux pénibles, permettait de reproduire un motif grâce à des cartes perforées qui n’actionnaient que les crochets nécessaires à effectuer le motif choisi sur un métier à tisser. La légende dit que Jacquard s’en est toujours voulu de l’invention de cette machine qui, outre d’être à l’origine de la révolte des canuts, a certes détourné les enfants des métiers à tisser, mais ne leur a pas épargné des travaux pénibles dans d’autres secteurs et parfois dans des conditions encore plus difficiles.

Le premier programmeur de l’histoire est une femme

Babbage se concentre bientôt sur la conception d’une machine plus puissante, la machine analytique dont le design a déjà tout d’un ordinateur moderne. Si Babbage avait en tête de pouvoir effectuer grâce à sa machine de nombreux calculs algébriques, celle qui l’a réellement programmée pour la première fois est Ada Lovelace. En 1842, à la faveur d’un séminaire de Babbage à l’Université de Turin, Louis Menebrea, publie en français un mémoire décrivant la machine analytique de Babbage. Babbage, impressionné par les qualités intellectuelles et mathématiques d’Ada, et dont la compréhension fine de sa machine ne lui aura pas échappé, décide de lui confier la traduction de cet article. Elle s’attellera à cette tâche avec une grande application et à la faveur de cet exercice, augmentera l’article de nombreuses notes, qui triplent sa taille. Ces notes, dont la publication l’a rendue « célèbre », démontrent que si elle appréhende le fonctionnement de la machine aussi bien que Babbage, elle en voit beaucoup plus clairement l’énorme potentiel.

Ceci valut à Ada d’être considérée comme le premier programmeur de l’histoire. Elle a, la première, clairement identifié des notions essentielles en informatique que sont les entrées (les cartes perforées contenant données et instructions), les sorties (cartes perforées contenant les résultats), l’unité centrale (le moulin) et la mémoire (le magasin permettant de stocker les résultats intermédiaires). À la faveur de la conception de l’algorithme permettant le calcul des nombres de Bernoulli, elle a introduit la notion de branchements, mais également expose comment une répétition d’instructions peut être utilisée pour un traitement, introduisant ainsi le concept de la boucle que l’on connaît bien en programmation.

Cent ans d’avance. Dans ses notes, Ada décrit en particulier comment la machine peut être utilisée pour manipuler pas uniquement des nombres mais aussi des lettres et des symboles. Ada est une visionnaire, elle est celle qui, la première, entrevoit l’universalité potentielle d’une telle machine, bien au delà de ce que ses contemporains pouvaient appréhender. Ada avait eut cette vision du calculateur universel bien avant l’heure, vision qu’Alan Turing formalisera quelque cent ans plus tard. En particulier elle fut, tellement en avance, en mesure d’imaginer la composition musicale effectuée par un ordinateur. Dans sa fameuse note G, la note finale, elle décrit un programme, comme nous l’appellerions aujourd’hui, qui permettrait à la machine analytique de faire des calculs sans avoir les réponses que les humains auraient pu calculer d’abord. Virage radical par rapport à ce que l’on attendait initialement de la machine analytique.

Ada Lovelace était une femme, non conventionnelle, athée quand sa mère et son mari étaient de fervents catholiques. Sur la fin de sa vie, Ada avait pour seul objectif de financer la machine de Babbage, elle croit avoir découvert une méthode mathématique lui permettant de gagner aux courses, qui la laissera dans une situation financière délicate. Elle meurt à 36 ans d’un cancer de l’utérus.

Une femme trop peu célébrée. Même si un langage de programmation porte son nom, Ada est restée assez discrète dans la discipline. Étudiante en informatique, j’ai entendu parler de Turing, de von Neuman ou de Babbage. Jamais d’Ada Lovelace. C’est Babbage qui fut récompensé par la médaille d’or de la Royal Astronomical Society en 1824. La vision d’Ada prendra son sens quelque cent ans plus tard dans les travaux de Turing. Alors même qu’il apparaît clairement que les notes d’Ada jetaient les premières bases de la machine de Turing, aucune des nombreuses biographies consacrées à Turing ne la mentionne. Il semblerait pourtant qu’il ait lu la traduction de Lovelace et ses notes quand il travaillait à Bletchey Park. Pire encore, certains historiens lui en retirent même la maternité comme l’historien Bruce Collier [1]. Si cette interprétation est largement contestée, cela en dit long sur la crédibilité qu’on accorde parfois aux esprits féminins.

À suivre…

Anne-Marie Kermarrec, Inria Bretagne

Et pour aller plus loin

- Bruce Collier. The Little Engine That Could’ve. 1990

- Suw Charman-Anderson. Ada Lovelace: Victorian computing visionary, chapitre de Women in STEM anthology, A passion for Science : Tales of Discovery and Invention.

Afin de faire découvrir aux jeunes l’informatique et les sciences du numérique, et après le grand succès de la troisième édition 2013 (plus de 170 000 élèves dont 48% de filles et près de 1200 collèges ou lycées français ont participé), une nouvelle édition commence aujourd’hui : les épreuves 2014 se déroulent du 12 au 19 novembre 2014.

Afin de faire découvrir aux jeunes l’informatique et les sciences du numérique, et après le grand succès de la troisième édition 2013 (plus de 170 000 élèves dont 48% de filles et près de 1200 collèges ou lycées français ont participé), une nouvelle édition commence aujourd’hui : les épreuves 2014 se déroulent du 12 au 19 novembre 2014.