Couverture de The Economist, Décembre 2009.

Couverture de The Economist, Décembre 2009.

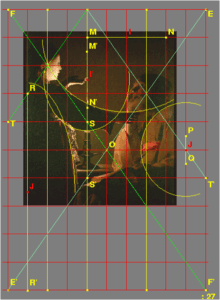

Lucas Cranach, Adam and Eve, 1526,

Courtauld Institute of Art Gallery.

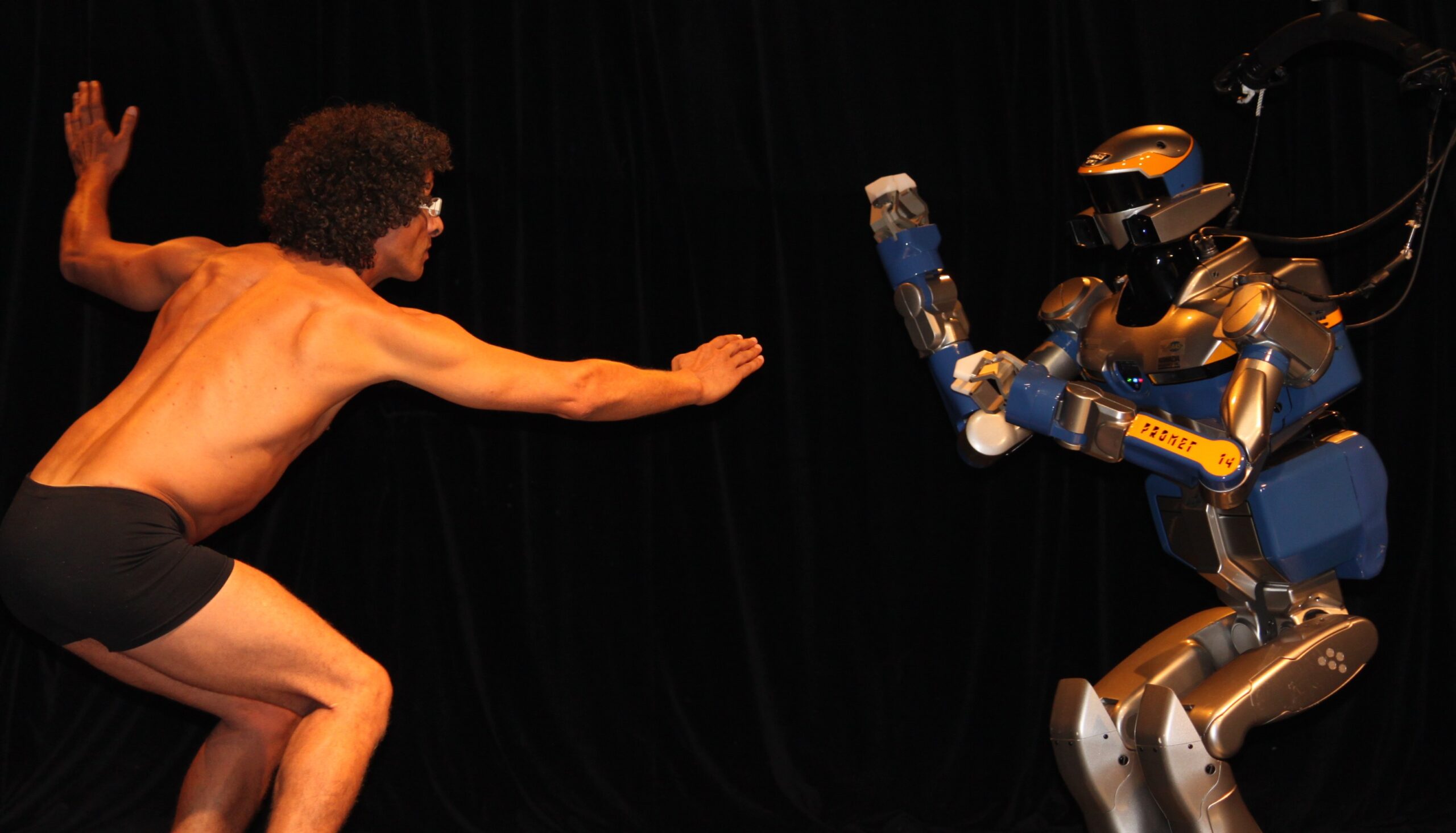

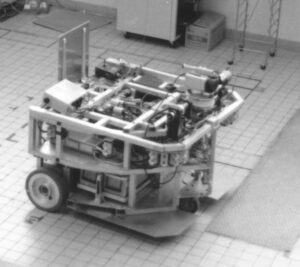

Que deviendra la notion de vie privée dans notre société numérique ? L’hyper-mnésie et l’hyper-connectivité du net sont-elles des facteurs d’asservissement ou de libération de l’homme ? Quelle sera notre responsabilité vis-à-vis de robots commandés par la pensée, quelle sera notre cohabitation avec les robots ? Construire des robots ressemblant à l’homme est-il tabou ? Faut-il souhaiter ou redouter le transhumain, cet hypothétique homme augmenté de capacités intellectuelles et physiques jusqu’à prendre notre relai dans l’évolution ? Peut-on sans précautions utiliser des données personnelles, génétiques ou comportementales, à des fins de recherches ?

Cet échantillon d’interrogations – dont certaines relèvent encore de la fiction – illustre l’ampleur et la diversité des questions éthiques que pose l’explosion du numérique.

Il serait présomptueux de vouloir traiter ici ces questions, d’autant que l’on ne peut pas en débattre entre informaticiens seulement; le propos est plutôt d’esquisser comment le monde scientifique les aborde actuellement. L’accent est mis sur la nécessaire approche décloisonnée des questions éthiques, et la nécessaire inscription de celles-ci dans l’espace public au delà des seuls spécialistes.

Ethique et déontologie

En gros l’éthique – qu’elle soit générale ou appliquée à un domaine – relève d’abord de la philosophie et l’humain est en son centre. L’éthique se définit classiquement comme la science de la morale.

La déontologie, qui n’est pas notre sujet ici, définit de manière plus opérationnelle les pratiques d’une profession, en accord avec l’éthique et le droit. La plus connue est la déontologie médicale. En informatique, le CIGREF (grandes entreprises utilisatrices) et le Syntec (SSI) ont défini leur code de déontologie. La déontologie engage comme le serment d’Hippocrate. L’ANR, agence nationale de projets scientifiques, affiche pour sa part une charte qui énumère les éléments suivants : Développer une recherche sérieuse et fiable ; Honnêteté dans la communication ; Objectivité ; Impartialité et indépendance ; Ouverture et accessibilité ; Devoir de précaution ; Equité dans la fourniture de références et de crédits ; Responsabilité vis-à-vis des scientifiques et des chercheurs à venir. Dans le monde anglo-saxon, on parle plus volontiers d’intégrité (integrity) qui met l’accent sur la responsabilité individuelle de comportement. Le comité d’éthique du CNRS (Comets) vient dans cet esprit d’éditer un guide pour promouvoir une recherche intégre et responsable.

Une approche scientifique nécessairement ouverte

Partout les réflexions éthiques mobilisent le regard croisé des philosophes, historiens, sociologues, juristes voire économistes. On peut même dire qu’ « élargir ses horizons » est inhérent à la démarche éthique, car on ne peut en général pas isoler les réflexions sur une science ou une technologie. Par exemple, en informatique, les considérations sur le Big Data ou sur l’anonymat ne peuvent être considérées que dans le contexte sociétal.

Des sujets incontournables

Dans le but louable de financer équitablement les cultes, les Pays-Bas avaient mis en cartes perforées IBM les données confessionnelles de leur population dès les années trente, ce qui servit en 1940 les funestes desseins des envahisseurs nazis. Notons que ce pays intègre maintenant tout particulièrement la préoccupation éthique dans ses programmes scientifiques.Certes, on ne peut pas incriminer les seules technologies, la délation par la peur et l’oppression est arrivée ailleurs au même résultat avec du papier et des crayons seulement. Il reste qu’au-delà des controverses, on voit que l’on peut difficilement se laver les mains de tels sujets : in fine, il s’agit des rapports entre la démocratie et les totalitarismes, et de l’avenir de notre monde.

Depuis le procès des médecins de Nuremberg, et maintenant avec les possibilités ouvertes par la biologie et la médécine, la bioéthique occupe le devant de la scène en éthique appliquée. Cependant les débats éthiques s’élargissent, et la sécurité alimentaire, l’environnement et le numérique suscitent à leur tour des questionnements. Ainsi au niveau européen le réputé appel à projets individuels de l’European Research Council (ERC) compte 105 occurrences de “ethic(s)”! De plus, les candidats doivent remplir un questionnaire éthique de 26 items, dont une douzaine est susceptible de concerner le numérique, notamment à travers l’usage de données personnelles (dont génétiques ou biométriques), les neurosciences, les technologies pour la santé, l’usage militaire ou encore la vie privée (la surveillance et maintenant la sousveillance, qui consiste en la possibilité pour chacun de mettre instantanément sur le net tout ce qu’il perçoit ou que son smartphone capte des personnes qu’il croise).

Des perceptions variables de par le monde

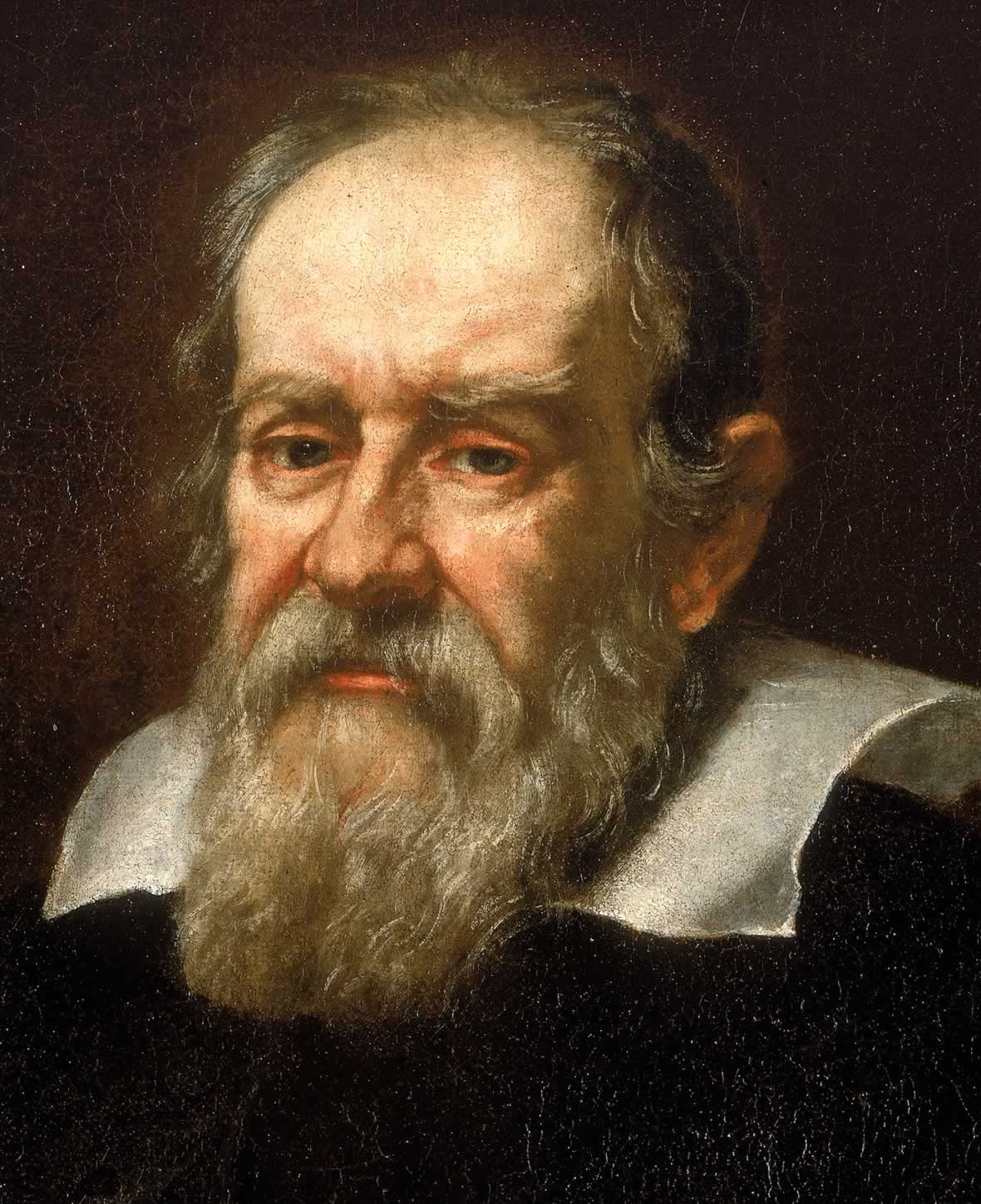

Une vision de l’homme inspirée des religions révélées, celles des fils d’Abraham, peut percevoir le transhumanisme comme une transgression. Un asiatique influencé par le shintoïsme peut par contre concevoir l’homme comme participant à un tout dans un continuum entre la vie, la nature et l’artéfact, et ne manifester de ce fait aucune appréhension à l’égard des humanoïdes. Dans nos sociétés, la confiance en la science comme vecteur de progrès s’effrite parfois face à l’ambivalence des technologies qui envahissent notre quotidien. Ainsi on peut voir dans les technologies numériques un facilitateur d’épanouissement et de démocratie, ou à l’opposé un instrument mu par le profit qui accroit les inégalités entre les hommes. Les compromis entre respect de la vie privée et sécurité sont perçus différemment selon les continents ou les aspirations politiques… Plus généralement, une étude norvégienne de 2010 (ROSE the Relevance Of Science Education) portant sur 34 pays représentatifs de la diversité de la planète met en évidence de grandes diversités de perception des sciences et des technologies selon les continents, les cultures, la richesse par habitant ou encore le genre. Un maillage sans frontières des réflexions est donc nécessaire afin d’avoir pleinement conscience de la relativité des préconisations que l’on peut formuler à l’attention d’une nation ou d’une communauté – ainsi en Californie les journaux parlent le plus souvent de l’informatique pour souligner de nouveaux systèmes, des réussites, alors qu’en France on va insister sur les risques de pédophilies.

Un enjeu de démocratie

Les débats d’éthique ne doivent pas être confisqués par les scientifiques, sous peine d’un divorce entre les « savants » et la société – comme le dit joliment Jean-Claude Ameisen, président du Comité Consultatif National d’Ethique pour les sciences de la vie et de la santé (CCNE), les chercheurs ne doivent pas se percevoir comme des bergers conduisant un troupeau, mais comme des moutons parmi les autres. Imaginons par exemple que les seuls informaticiens se piquent de dire ce qui est éthique ou ne l’est pas dans le Big Data, ils seraient soupçonnés de vouloir s’ériger en « grands prêtres » du traitement de l’information.

Si la pensée d’Hannah Arendt est abondamment revisitée actuellement, c’est qu’elle fournit un socle étonnamment d’actualité pour aborder ces questions. Très sommairement, l’idée est que les technosciences – omniprésentes dans notre quotidien, et au cœur desquelles figure le numérique – peuvent devenir outils d’un totalitarisme confisquant l’avenir des hommes, si ceux-ci ne développent pas à leur égard une pensée critique organisée à travers des espaces publics. Autrement dit, si les peuples acceptent que les technologies soient des outils que la propagande leur dit bienfaiteurs mais qu’ils ne questionnent pas, ces technologies peuvent menacer la démocratie. Un exemple souvent cité de cette propagande est le rapport NSF de 2006 au titre évocateur « Converging Technologies for Improving Human Performance : Nanotechnology, Biotechnology, Information Technology and Cognitive Science », popularisé sous le nom de convergence NBIC. Il est donc du devoir des démocraties d’organiser les espaces publics de débats sur ces sujets, et du devoir des citoyens d’y apporter une attention conjointe soutenue. En France, à titre d’exemples, la fondation Sciences Citoyennes, ou en informatique la Fondation Internet Nouvelle Génération (la FING) y œuvrent.

Un paysage en construction

Face à ces enjeux les initiatives se multiplient, principalement sous l’impulsion des Etats-Unis d’une part et de l’Europe d’autre part. Sur le plan scientifique, la bioéthique naturellement, mais aussi l’environnement et la sécurité alimentaire provoquent des débats de société, davantage encore que le numérique, car ces secteurs sont perçus comme conditionnant de manière intrusive le devenir biologique de notre espèce.

Les comités d’éthique scientifique

Ce sont généralement des instances consultatives, indépendantes, que l’on peut saisir ou qui s’autosaisissent de sujets éthiques, et qui fournissent des préconisations. Ils ont un rôle de réflexion et sensibilisation amont.

En Europe, l’European Group of Ethics (EGE) joue ce rôle sur tout le spectre scientifique. La Commission Européenne est certes prolixe en tous domaines, mais on soulignera quand même l’abondance de la documentation sur l’éthique en général, et sur le numérique en particulier. Cette abondance semble viser davantage la sensibilisation des chercheurs que la construction d’une vision proprement européenne.

En France, le plus ancien et le plus en vue est le CCNE déjà évoqué, créé en 1983 à l’initiative de François Mitterrand. Ce comité est placé auprès du Premier ministre, et sa composition garantit la représentation des grands courants philosophiques et religieux. Le CNRS dispose pour sa part depuis 1994 du COMETS. L’INRA et le CIRAD ont fusionné leurs comités.

Concernant l’informatique, la CERNA (Commission de réflexion sur l’Ethique de la Recherche en sciences et technologies du Numérique d’Allistene) a été créée fin 2012 sous l’impulsion d’Inria et du CNRS par Allistene, l’alliance des sciences et technologies du numérique qui réunit le CEA, la CGE, le CNRS, la CPU, Inria et l’Institut Mines-Télécom. Le point de vue y est celui de la recherche et non des usages.

Il s’ajoute bien entendu au paysage des groupes de travail qui émergent à l’initiative d’établissements ou de groupes d’établissements, comme par exemple le groupe Prométhos en éthique de l’innovation sur le plateau de Saclay.

Les comités opérationnels d’établissement

Ils traitent les questions engageant leur responsabilité à travers des projets ou la déontologie des personnels.

Les instances de validation et certification (respect de normes éthiques)

De plus en plus d’institutions demandent une certification de conformité éthique des projets de

recherche attestée par un Institutional Review Board (IRB), notamment pour les recherches impliquant l’homme.

Les espaces de débat public

La France dispose depuis 1995 d’une Commission nationale du débat public (CNDP), créée dans le cadre de la loi relative au renforcement de la protection de l’environnement, dite loi Barnier. Cette commission, aux consultations fort diverses, a notamment (mal)traité des nanotechnologies en 2010.

A un niveau intermédiaire entre le débat public et le cénacle de spécialistes, on peut citer les espaces éthiques régionaux qui se mettent en place à l’initiative du CCNE. Centrés sur la pratique hospitalière, ils associent des représentants des usagers.

Notons aussi que face au trouble suscité par la biologie de synthèse, le ministère de l’enseignement supérieur et de la recherche a confié en 2012 au CNAM la création d’un observatoire de la biologie de synthèse, chargé d’informer le grand public et d’échanger avec lui.

Les conférences et symposiums scientifiques

Il est naturel que des manifestations scientifiques accompagnent la montée des préoccupations éthiques, dans le numérique comme ailleurs. Ainsi l’IEEE, maintenant association internationale des professionnels du secteur numérique et dont les racines remontent à 1884 et l’avènement de la fée électricité, lance l’année prochaine un symposium sur l’éthique appelé à devenir annuel.

Deux conférences internationales de recherche sont consacrées depuis une vingtaine d’années aux différents aspects éthiques liés à l’informatique, CEPE et ETHICOMP. A l’initiative de la CERNA, elles se tiendront cette année conjointement et pour la première fois en France.

D’une manière générale, les Français sont peu présents dans ce genre de manifestation. Ainsi, lors de la 3rd World Conference on Research Integrity (WCRI) qui s’est tenue en 2013 à Montreal, il n’y avait que 4 français sur 500 participants. Ce manque d’appétence de notre monde académique est peut-être dû à la faible reconnaissance dans notre pays des investissements dans les questions éthiques et plus généralement les questions interdisciplinaires. Peut-être aussi que, le regard fixé dans le rétroviseur sur notre rôle phare du temps des Lumières, nous percevons avec circonspections les nouveaux espaces éthiques qu’ouvrent les technosciences. Nuançant ce dernier propos, de nouveaux lieux de réflexions émergent dans notre pays, notamment au sein d’associations comme la FING (Fondation Internet Nouvelle Génération), Renaissance numérique, la Quadrature du net. Par ailleurs, l’AFIA (Association Française d’Intelligence Artificielle) a consacré un récent bulletin à un « Dossier Ethique et IA », et la SIF a reproduit une première version du présent propos dès le numéro deux de son bulletin intitulé 1024.

___________________________

En conclusion, il importe que les scientifiques contribuent aux débats sur l’éthique des nouvelles technologies, et du numérique en particulier, faute de quoi les espaces laissés en friches pourraient être investis par des obscurantistes ou des aventuriers. Nous devons aussi veiller dans notre pays à dépasser nos vieilles habitudes de « s’affronter d’abord, débattre ensuite », car aborder les sujets éthiques en termes de pro- versus anti-technologies nous ferait passer tragiquement à côté du sujet. Et pour cela sensibilisons, informons, formons à commencer par la jeunesse.

Max Dauchet, Conseil scientifique de la SIF

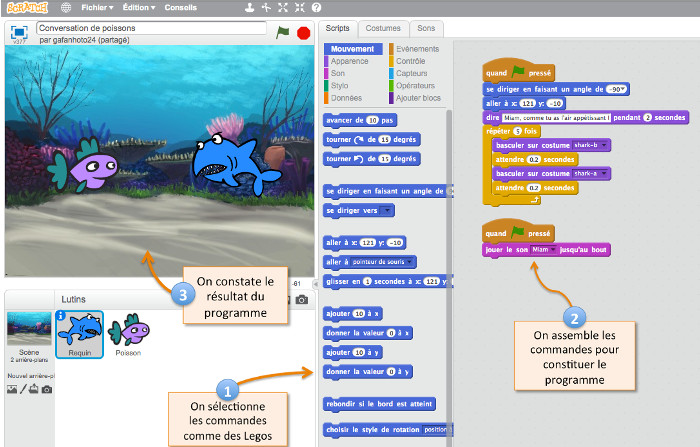

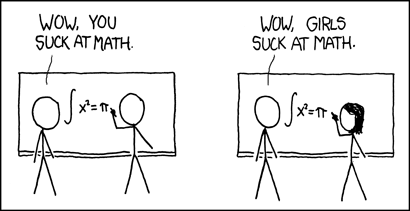

notre professeure qui n’est pas seulement prof mais aussi parent, commence à apprendre la

notre professeure qui n’est pas seulement prof mais aussi parent, commence à apprendre la

(original)

(original) (résultat)

(résultat)

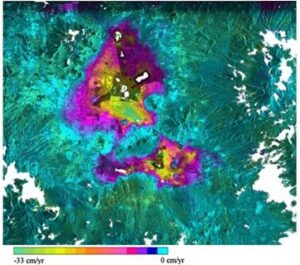

Copyright Wikipedia

Copyright Wikipedia Copyright Wikipedia

Copyright Wikipedia