Un nouvel entretien autour de l’informatique.

Pascale Senellart est physicienne, directrice de recherche au Laboratoire de photonique et nanostructures du CNRS de l’Université Paris-Saclay, professeure chargée de cours à l’École polytechnique. Ses travaux se concentrent sur les interactions lumière-matière avec des boîtes quantiques semi-conductrices dans des cavités optiques. Elle a reçu la médaille d’argent du CNRS (en 2014) parmi de nombreuses distinctions scientifiques.

En 2017, Pascale a cofondé avec Valérian Giesz et Niccolo Somaschi la startup Quandela, d’abord pour commercialiser une source de photons uniques s’appuyant sur ses travaux de recherche au C2N, puis pour développer un ordinateur quantique à base de photons.

Jean Senellart est informaticien, pionnier de la traduction automatique. Il a longtemps dirigé la R&D de Systran. Sous son impulsion, Systran a construit un des premiers moteurs de traduction basés sur un réseau de neurones et le framework opensource OpenNMT. Il a rejoint Quandela pour contribuer à son logiciel quantique.

Binaire : Pouvez-vous nous raconter votre parcours ?

Pascale Senellart : je suis directrice de recherche au CNRS, au centre de nanosciences et de nanotechnologies depuis 2002. Physicienne des semi-conducteurs, mon objectif était de reproduire dans ces matériaux des expériences fondamentales de la physique théorique. Cela avait été fait par Serge Haroche et d’autres avec des atomes, et je voulais le faire avec des outils de microélectronique. Il s’agit de développements technologiques basés sur l’étude des même matériaux que ceux étudiés pour réaliser de nombreux composants comme les pointeurs lasers. Mon équipe a ainsi développé de petits composants semi-conducteurs similaires à des LED, mais qui sont des composants émettant des photons un par un.

Vers 2013, j’ai commencé à être contactée par des personnes souhaitant construire des ordinateurs quantiques. La technologie de mon équipe, bien qu’imparfaite, était dix fois plus efficace que ce dont ils disposaient. Idéalement, pour obtenir un photon, il devrait suffire d’appuyer sur un bouton ; l’efficacité de leurs outils était de 1 photon pour 100 essais ; nous en sommes maintenant à 60 photons pour 100.

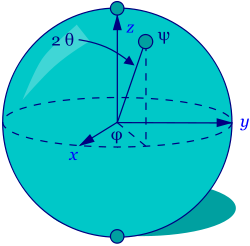

Pour coder de l’information, on peut utiliser la polarisation du photon (suivant le sens de son champ électrique) ou sa couleur (par exemple bleue ou rouge) ou sa direction (suivant qu’il aille à droite ou à gauche). C’est donc un bit d’information. Mais on peut faire mieux en utilisant le fait qu’une particule peut être en deux endroits en même temps. Par exemple, le photon peut aller à la fois à droite et à gauche. C’est à la base du bit d’information quantique, appelé qubit.

Vers 2016, nous disposions de composants qui intéressaient énormément, en particulier, les laboratoires universitaires. En 2017, nous avons créé une startup, Quandela, pour les commercialiser. Au début, nos clients appartenaient au monde académique ; puis avec le boom international sur le quantique, nous avons eu comme clients des startups. Un spécialiste de l’algorithmique quantique, Shane Mansfield a rejoint l’aventure en 2020 pour porter aussi l’effort dans la direction de l’ordinateur quantique. Il y avait un gouffre entre le monde des algorithmes quantiques, des composants semiconducteurs et celui de l’informatique traditionnelle. L’arrivée de Jean en 2022 a permis de faire un pont entre ces trois mondes.

Jean Senellart : J’ai fait une thèse en informatique linguistique avec Maurice Gross au LADL (Laboratoire d’Automatique Documentaire et Linguistique). Je travaillais sur les aspects formels, puis j’ai fait de la traduction automatique et du développement logiciel industriel. Chez Systran, nous avons utilisé l’intelligence artificielle pour le traitement de la langue naturelle, et développé les premiers traducteurs automatiques basés sur des réseaux de neurones. Ensuite, nous avons même mis des transformers (une architecture d’apprentissage profond introduite par Google) en open source. Le domaine de la traduction automatique a beaucoup progressé, et il est aujourd’hui plutôt dans une phase de perfectionnement. C’est ce qui m’a poussé à chercher de nouveaux défis. L’informatique quantique m’est apparue comme un domaine prometteur où mes compétences en algorithmique et en traitement de données complexes pouvaient être valorisées d’une nouvelle manière. C’est ainsi que j’ai décidé de rejoindre le projet de Quandela de construire et de contrôler un ordinateur quantique.

Binaire : Qu’est-ce qu’un ordinateur quantique ? Qu’est-ce que ça pourrait changer ?

PS : L’ordinateur classique repose notamment sur des composants comme des transistors, qui exploitent déjà des propriétés de la physique quantique. Mais l’ordinateur quantique utilise un concept beaucoup plus puissant et fragile, à savoir, la « superposition quantique » : un photon peut être à droite et à gauche en même temps. Mais, dès que je fais une mesure, le photon est soit à droite soit à gauche, de manière aléatoire, avec la même probabilité alors qu’il était, avant la mesure, aux deux endroits en superposition. Et puis, un autre phénomène est essentiel : « l’intrication ». Si on lance deux pièces de monnaie en l’air, elles tombent chacune sur pile ou face ; en quantique, on peut créer un état intriqué des deux pièces ; elles tomberont toujours de manière aléatoire, mais toutes les deux sur pile, ou toutes les deux sur face et même toutes les deux sur la tranche mais exactement de la même façon. Deux photons, peut-être distants l’un de l’autre, peuvent ainsi être intriqués.

Grâce à la superposition et l’intrication, la physique quantique permet ainsi d’explorer plusieurs possibilités en même temps. Supposons que l’on cherche la sortie d’un labyrinthe. Quand on trouve un branchement, on peut explorer la branche de gauche puis l’autre. On pourrait trouver la sortie beaucoup plus vite si on explorait les deux en même temps. Du point de vue de l’information, on arrive à coder avec n particules une information qui correspondrait à un nombre exponentiel en n de bits.

Je travaille sur le hardware et la vraie difficulté à laquelle nous sommes confrontés est de garder les propriétés de superposition et d’intrication. Pour poursuivre avec l’analogie du labyrinthe, si je demande à l’explorateur du labyrinthe où il est, je perds la superposition et donc tout l’avantage apporté par le calcul quantique. Je fais donc en sorte de ne pas lui demander directement, mais si par exemple des cailloux se trouvent dans le labyrinthe et font trébucher l’explorateur, ces cailloux ont en quelque sorte « interrogé » l’explorateur et feront qu’il ne sera plus dans un état superposé mais uniquement à cet endroit du chemin. Ce phénomène illustre ce qu’on appelle la « décohérence » qui va être source d’erreur dans le calcul quantique. Cet exemple montre aussi que quand on veut programmer avec le quantique, on est conduit à penser différemment, à concevoir d’autres algorithmes – car on ne peut pas interroger le système en cours de calcul comme on le fait couramment avec un ordinateur classique. C’est un vrai défi.

Binaire : Comment programme-t-on un ordinateur quantique ?

JS : Il vaut mieux ne pas être physicien [rire]. Il faut voir l’ordinateur quantique comme un moyen nouveau d’accélérer les calculs. Sur le plan théorique, on dispose de qubits (avec la superposition et l’intrication) qu’on doit pouvoir initialiser (créer des superpositions) et faire des opérations logiques (fabriquer l’intrication) et mesurer. Di Vincenzo d’IBM a ainsi défini les calculateurs quantiques. La première difficulté est de programmer le système physique qui permet de réaliser tout cela au travers de différentes couches logicielles.

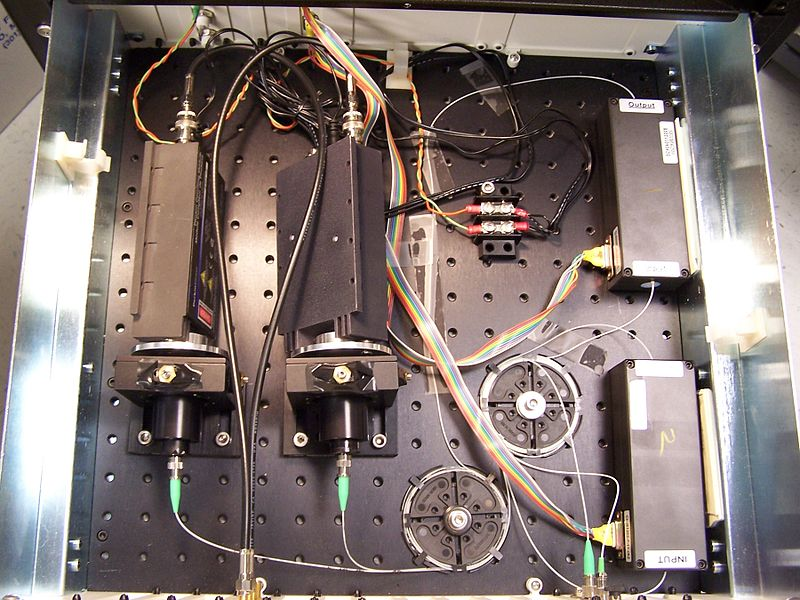

En utilisant le photon pour fabriquer un ordinateur quantique, on va pouvoir utiliser les outils de la photonique intégrée pour créer la superposition et l’intrication. On va par exemple utiliser des puces où des guides d’onde qui dirigent les photons dans différentes directions. En changeant localement la température, on peut modifier l’indice de propagation de la lumière dans le verre et programmer la superposition de la particule qui passe à cet endroit-là. En montant en niveau, on va faire en sorte que deux photons se croisent sur la puce à divers endroits pour créer l’intrication. À un niveau supérieur, on utilise cette intrication pour réaliser des analogues quantiques des portes logiques qu’on trouve dans les ordinateurs classiques. Au-dessus de ce niveau, on implémente des algorithmes comme l’algorithme de Shor qui permet, avec un ordinateur quantique très sophistiqué, de décomposer un nombre en facteurs premiers.

Nous avons mis en place un petit ordinateur sur le cloud, avec 10 qubits aujourd’hui. Si nous arrivions à une centaine de qubits, nous pourrions réaliser des calculs actuellement plus vite que les supercalculateurs. Il nous manque donc juste un ordre de grandeur. Mais il ne faut pas sous-estimer la difficulté de passer de 10 à une centaine. Il ne suffit pas d’ajouter des qubits comme on rajoute des processeurs, il faut aussi être capable de les intriquer et ne pas ajouter de la décohérence quand on ajoute des qubits.

Avec quelques qubits, nous avons déjà réalisé de l’apprentissage machine (machine learning) quantique, ou calculé le niveau d’énergie de l’hydrogène avec une précision chimique. Ainsi, nous avons également classifié des images d’iris avec seulement 3 qubits. Le fait qu’avec 3 qubits nous puissions réaliser l’équivalent de ce que nous ferions avec un petit réseau d’une centaine de neurones classiques montre la puissance du calcul quantique en termes de complexité.

Binaire : Le but est de réaliser des calculs encore hors de notre portée. Et, y a-t-il d’autres possibilités pour le calcul quantique ?

PS : Oui, l’objectif est de réaliser des calculs qui ne sont pas accessibles aux ordinateurs classiques actuels. Un autre apport de l’ordinateur quantique pourrait être une consommation d’énergie moindre. En effet, on atteint des limites des ordinateurs classiques non seulement du fait de la taille des transistors qu’on ne peut plus réduire, mais aussi par leur production de chaleur. La dissipation de cette chaleur est un obstacle majeur pour aller vers plus de puissance de calcul. D’un point de vue fondamental, ce n’est pas le cas pour le calcul quantique, qui ne génère pas de chaleur au niveau le plus bas. Alors, il est vrai qu’aujourd’hui, on ne connaît pas de technologie de calcul quantique qui effectue des calculs à température ambiante. Pour générer nos photons, nous travaillons à 4 Kelvin, et cela demande de l’énergie pour faire descendre à cette température notre machine. Mais cette énergie initiale est très faible par rapport à l’économie d’énergie que l’utilisation de la superposition et de l’intrication quantique permet.

Binaire : OVH vous a acheté une machine. Qu’en font-ils ?

PS : Ils génèrent des nombres aléatoires certifiés. Actuellement, les processus de génération de nombres aléatoires en informatique classique sont en fait pseudo-aléatoires (pas vraiment aléatoires), tandis qu’en informatique quantique, nous pouvons générer de véritables nombres aléatoires pour lesquels nous pouvons démontrer qu’il n’y a pas d’information cachée. On a par exemple besoin de vrais nombres aléatoires en cryptographie.

Binaire : Peut-on simuler les ordinateurs quantiques ?

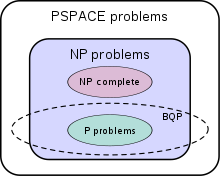

JS : Aujourd’hui, nous pouvons simuler jusqu’à environ 25 qubits photoniques avec des ordinateurs classiques. En utilisant les plus puissants supercalculateurs, il serait possible d’atteindre au maximum une centaine de qubits. Au-delà, comme la puissance de calcul quantique est exponentielle en nombre de qubits, les meilleurs supercalculateurs ne peuvent plus rien faire. Ces simulations sont cruciales pour le développement et la validation d’algorithmes quantiques, et leurs limitations souligne aussi l’importance de construire de véritables ordinateurs quantiques. En effet, dès que nous dépasserons la barre des 100-200 qubits avec des ordinateurs quantiques réels, nous entrerons dans un domaine où la simulation classique devient impossible, ouvrant la voie à de véritables avancées en calcul quantique.

Binaire : Peut-on s’attendre à une révolution avec l’informatique quantique ?

PS : De mon point de vue, nous sommes déjà au cœur d’une révolution technologique. Nous réalisons des avancées dans les laboratoires auxquelles nous n’aurions pas cru il y a 5 ans. Les progrès sont spectaculaires et rapides. Du point de vue des applications, nous en sommes encore aux prémices de l’histoire. Jusqu’à présent, cela restait essentiellement une affaire à des physiciens. Mais maintenant les informaticiens nous rejoignent.

C’est la construction de matériel qui prend du temps. Mais on y arrive. Le passage à l’informatique quantique est pour moi inévitable. Cela va se produire.

Binaire : Doit-on imaginer des machines qui seront uniquement quantiques ou un mélange ?

JS : Cela sera forcément un mélange des deux – tout comme on a ajouté des GPU aux ordinateurs actuels pour gagner en puissance de calcul sur certains problèmes. De la même façon, le quantique accélère certains types de problèmes, mais pas tous. Par exemple, la simulation de molécules complexes ou l’optimisation de grands systèmes sont des domaines où le quantique pourra apporter un avantage significatif. D’ailleurs, suivant les applications, certaines plateformes quantiques sont plus adaptées que d’autres selon les principes sur lesquels elles se fondent. Par exemple, les ordinateurs quantiques à base de qubits supraconducteurs ou de photons uniques ont chacun leurs forces pour différents types de calculs quantiques.

Binaire : Y a-t-il des besoins en matériaux spécifiques ?

PS : Dans les plateformes avec des qubits de silicium, il faut un silicium extrêmement pur, et très peu de pays dans le monde savent produire du silicium à ce degré de pureté. Dans les plateformes avec des photons, comme celle sur laquelle nous travaillons, pas tant que ça. C’est d’ailleurs le type de plateforme le mieux financé au niveau international. Les financements sont énormes aux États-Unis et en Chine, plus modestes en France et en Europe.

Les équipes chinoises du professeur Jan Wei Pan ont réalisé des démonstrations avec des plateformes à photons et ont effectué des calculs inaccessibles au monde classique.

Binaire : Que pouvez-vous dire à ceux qui ne croient pas en l’ordinateur quantique ?

PS : Certains scientifiques voient tous les défis technologiques qu’il faut résoudre pour obtenir un ordinateur quantique très puissant et sont dubitatifs. Pour moi, dire que ce n’est pas possible, ce n’est pas un point de vue scientifique. Regardons ce qui s’est passé sur la première révolution technologique du 20e siècle qui exploitait les concepts de base de la mécanique quantique. Qui aurait pu penser au début du transistor – quand celui-ci faisait la taille d’une ampoule – que ce composant permettrait de révolutionner notre quotidien ? Nous sommes dans une situation analogue – avec des composants permettant d’exploiter des concepts quantiques beaucoup plus puissants.

JS : Aujourd’hui, il est à la fois possible de démontrer théoriquement que certains algorithmes quantiques permettront de résoudre des problèmes que nous ne pouvons qu’approximer avec n’importe quel ordinateur actuel classique aussi puissant soit-il, et à la fois possible de démontrer pratiquement que ces algorithmes fonctionnent déjà à une petite échelle. Il n’est plus possible de ne plus croire au quantique, et ce n’est plus qu’une question de temps.

Binaire : Pascale, quand comptes-tu retourner à la recherche ?

PS : Je n’ai jamais autant fait de recherche. Je suis officiellement à 30% dans Quandela. Et même ma contribution à Quandela, c’est aussi de la recherche.

Binaire : Et toi Jean, les problèmes informatiques que tu rencontres sont-ils aussi intéressants que ceux que tu adressais avant, en apprentissage automatique ?

JS : L’algorithmique a toujours été ma passion. Tout comme ce qui s’est passé avec l’arrivée des réseaux de neurones à grande échelle, le quantique nous permet de revisiter des problèmes classiques avec un outil nouveau, et qui défie souvent l’intuition. Pour chaque problème considéré, trouver la manière de l’aborder avec des primitives quantiques est donc un défi chaque fois renouvelé : il faut être créatif en permanence. De plus, même si on a l’algorithme, la manière de l’exécuter sur un ordinateur quantique particulier est aussi souvent un problème ouvert à part entière, donc oui : les problèmes informatiques existants et à venir sont tout aussi passionnants et stimulants intellectuellement que ceux que j’ai pu rencontrer dans le monde de l’apprentissage automatique et du traitement de la langue.

Serge Abiteboul, Inria et ENS, Paris, Claire Mathieu, CNRS et Université Paris Cité

Pour aller plus loin

Quandela, quand le quantique rencontre le HPC…, Vie des entreprises, novembre 2022, P. Senellart et J. Senellart.

https://binaire.socinfo.fr/les-entretiens-de-la-sif/