Solove et Hartzog viennent de publier un excellent article sur le moissonnage massif des données sur le web (« web scraping » en anglais) pour l’entraînement des systèmes d’Intelligence Artificielle et les tensions que cela génère avec les principes de la protection des données personnelles1. Cet article nous permet de revisiter la problématique du moissonnage massif des données et de rappeler les travaux et consultations menés par la CNIL sur ce sujet depuis plusieurs mois2. Serge Abiteboul, Antoine Rousseau et Ikram Chraibi-Kaadoud

Solove et Hartzog viennent de publier un excellent article sur le moissonnage massif des données sur le web (« web scraping » en anglais) pour l’entraînement des systèmes d’Intelligence Artificielle et les tensions que cela génère avec les principes de la protection des données personnelles1. Cet article nous permet de revisiter la problématique du moissonnage massif des données et de rappeler les travaux et consultations menés par la CNIL sur ce sujet depuis plusieurs mois2. Serge Abiteboul, Antoine Rousseau et Ikram Chraibi-KaadoudL’IA, en particulier l’IA générative, nécessite de vastes quantités de données pour son entraînement. Certaines de ces données sont collectées directement auprès des individus, tandis que d’autres sont obtenues via une interface de programmation d’application (API) conçue pour une extraction et un partage consensuel des données. Toutefois, la majorité des données sont obtenues par moissonnage. Le moissonnage des données sur Internet consiste à utiliser des logiciels automatisés pour extraire des informations à partir de sites web ou de réseaux sociaux.

1 https://papers.ssrn.com/sol3/papers.cfm?abstract_id=4884485

2 https://www.cnil.fr/fr/technologies/intelligence-artificielle-ia

Moissonnage et Intelligence Artificielle

Le moissonnage de données est un outil essentiel pour les chercheurs et les journalistes qui leur permet d’accéder à des informations cruciales pour leurs projets. En collectant rapidement des données issues de multiples sources, il facilite des recherches et des études qui seraient autrement impossibles. Cette collecte massive des données semble également être essentielle pour le développement et l’amélioration des modèles d’IA, car elle fournit les vastes quantités de données nécessaires à l’entraînement des algorithmes. Par ailleurs, en diversifiant les sources de données à travers différentes régions et cultures, le moissonnage peut aussi aider à éviter les biais dans les modèles d’IA.

Il est par ailleurs souvent avancé que ce moissonnage permet aux petites entreprises de rivaliser avec les grandes plateformes en facilitant l’accès à des informations, ce qui stimule la concurrence, l’innovation et la diversité technologique. Comme le souligne l’autorité de la concurrence dans son rapport sur l’IA générative3, les données, qu’elles soient textuelles, visuelles ou vidéo, sont essentielles pour les modèles de langage et proviennent principalement de sources publiques comme les pages web ou les archives web telles que Common Crawl4.

3 https://www.autoritedelaconcurrence.fr/fr/communiques-de-presse/intelligence-artificielle-generative-lautorite-rend-son-avis-sur-le

4 https://foundation.mozilla.org/en/research/library/generative-ai-training-data/common-crawl/

Moissonnage et vie privée

Bien que le moissonnage offre des avantages importants, il pose de nombreuses questions : protection du secret des affaires, secret industriel, propriété intellectuelle, rétribution des ayants droits et vie privée.

En ce qui concerne la protection de la vie privée, qui nous intéresse ici, le vaste moissonnage des données personnelles soulève des questions inédites. Comme le rappelle la CNIL, “La généralisation des pratiques de moissonnage a ainsi opéré un changement de nature quant à l’utilisation d’internet, dans la mesure où toutes les données publiées en ligne par une personne sont désormais susceptibles d’être lues, collectées et réutilisées par des tiers, ce qui constitue un risque important et inédit pour les personnes5.”

En effet, l’ampleur de ce moissonnage est sans précédent – la quantité de données, notamment de données personnelles, collectées par chaque moissonneur est stupéfiante.

Par exemple, OpenAI a certainement moissonné une partie non négligeable du Web et utilisé ces données pour entraîner les modèles GPT qui sous-tendent notamment ChatGPT. Des entreprises comme ClearviewAI et PimEyes ont moissonné des milliards de photos pour alimenter des outils de reconnaissance faciale. De nouvelles entreprises d’IA apparaissent à un rythme effarant, chacune ayant un appétit vorace pour les données.

Il est important de rappeler que, dans la plupart des juridictions et notamment en Europe, les données personnelles « publiquement disponibles » sur internet sont soumises aux lois sur la protection des données et la vie privée, notamment le RGPD (règlement général sur la protection des données). Les individus et les entreprises qui moissonnent ces informations personnelles ont donc la responsabilité de s’assurer qu’ils respectent les réglementations applicables. Par ailleurs, les entreprises de médias sociaux et les opérateurs d’autres sites web qui hébergent des données personnelles accessibles au public ont également des obligations de protection des données en ce qui concerne le moissonnage par des tiers sur leurs sites.

5 https://www.cnil.fr/fr/focus-interet-legitime-collecte-par-moissonnage

La consultation de la CNIL

La CNIL a régulièrement souligné la nécessité de vigilance concernant les pratiques de moissonnage et a formulé des recommandations pour leur mise en œuvre6. Elle a également demandé à plusieurs reprises un cadre législatif spécifique pour ces pratiques qui permettrait de sécuriser les organismes utilisant ces pratiques, de les encadrer, et de protéger les données personnelles accessibles en ligne7. La CNIL a parfois jugé ces pratiques illégales en l’absence d’un cadre juridique, par exemple lorsque utilisées par des autorités pour détecter des infractions ou lorsque des données sensibles sont collectées8. Cependant, elles ont été acceptées dans certains cas, comme la recherche de fuites d’informations sur Internet, à condition de mettre en place des garanties solides9. En attendant un cadre juridique spécifique, la CNIL rappelle les obligations des responsables de traitement et les conditions à respecter pour le développement de systèmes d’IA.

6 https://www.cnil.fr/fr/focus-interet-legitime-collecte-par-moissonnage

7 https://www.legifrance.gouv.fr/jorf/id/JORFTEXT000047624863

8 https://www.cnil.fr/fr/reconnaissance-faciale-sanction-de-20-millions-deuros-lencontre-de-clearview-ai

9 https://www.cnil.fr/fr/la-recherche-sur-internet-de-fuites-dinformations-rifi

Alors que certains chercheurs, comme Solove et Hartzog, proposent de limiter le moissonnage uniquement aux projets d’intérêt public, le RGPD autorise, sous certaines

conditions, le moissonnage en cas d’intérêt légitime du moissonneur10. Le recours à cette base légale suppose que les intérêts (commerciaux, de sécurité des biens, etc.)

poursuivis par l’organisme traitant les données ne créent pas de déséquilibre au détriment des droits et intérêts des personnes dont les données sont traitées11. Le responsable du traitement doit notamment mettre en place des garanties supplémentaires pour protéger les droits et libertés des individus. La CNIL, dans sa fiche sur l’utilisation de l’intérêt légitime pour développer des systèmes d’IA, souligne que les mesures appropriées varient selon l’usage de l’IA et son impact sur les personnes concernées12. Elle recommande d’exclure la collecte de données à partir de sites sensibles ou s’opposant au moissonnage, et de créer une « liste repoussoir » permettant aux individus de s’opposer à la collecte de leurs données. La collecte doit se limiter aux données librement accessibles et rendues publiques intentionnellement.

De plus, il est conseillé d’anonymiser ou de pseudonymiser les données immédiatement après leur collecte, de diffuser largement les informations relatives à la collecte et aux droits des personnes, et de prévenir le recoupement des données en utilisant des pseudonymes aléatoires propres à chaque contenu.

10 D’autres bases légales, comme le consentement ou la mission d’intérêt public, sont aussi envisageables.

11 https://www.cnil.fr/fr/les-bases-legales/interet-legitime

12 https://www.cnil.fr/fr/focus-interet-legitime-collecte-par-moissonnage

Rendre le moissonnage techniquement plus difficile

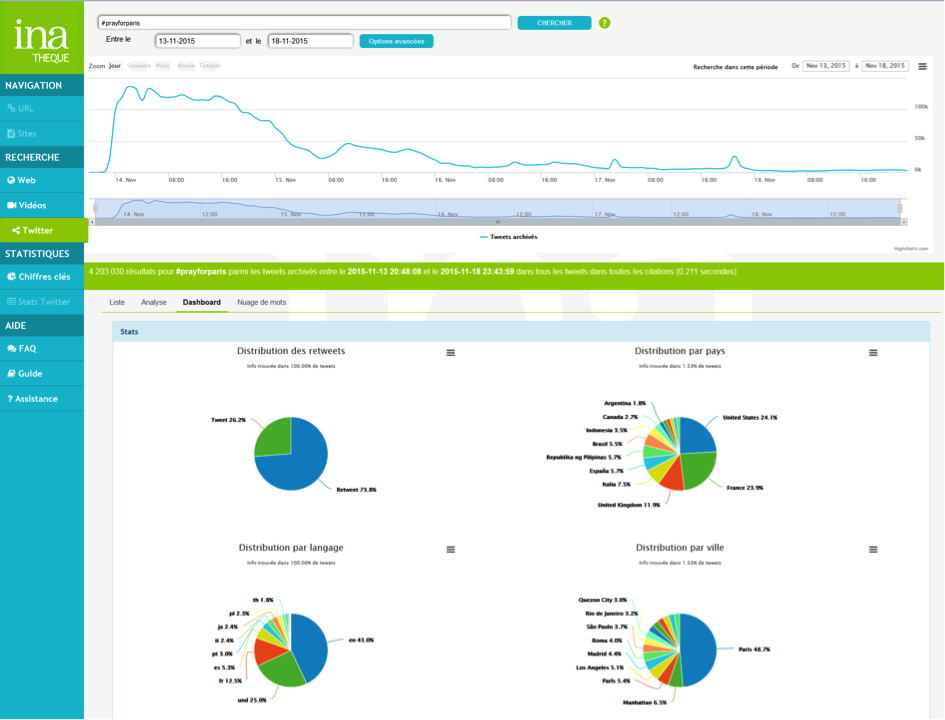

Comme mentionné précédemment, les hébergeurs de données personnelles accessibles au public ont également des obligations de protection des données en ce qui concerne le moissonnage. Par exemple, plusieurs autorités de protection des données (APD) du monde entier ont soutenu, dans une déclaration conjointe sur le moissonnage, que les entreprises devraient mettre en œuvre des contrôles techniques et procéduraux multicouches pour atténuer les risques associés à cette pratique13. Ces APD indiquent que les sites web devraient mettre en œuvre des contrôles techniques et procéduraux multicouches pour atténuer les risques. Une combinaison de ces contrôles devrait être utilisée en fonction de la sensibilité des informations. Certaines de ces mesures de protection seraient la limitation du nombre de visites par heure ou par jour pour un seul compte, la surveillance des activités inhabituelles pouvant indiquer un moissonnage frauduleux et la limitation de l’accès en cas de détection, la prise de mesures affirmatives pour détecter et limiter les bots, comme l’implémentation de CAPTCHAs et le blocage des adresses IP, ainsi que la menace ou la prise de mesures légales appropriées et la notification des individus concernés. Des recommandations similaires ont récemment été faites par la CNIL Italienne14. Bien entendu, les grandes plateformes telles que Facebook, X (anciennement Twitter), Reddit, LinkedIn, n’ont pas attendu ces recommandations pour mettre en place des mesures pour limiter le moissonnage. Par exemple, récemment X a constaté des « niveaux extrêmes de moissonnage de données » et a pris des mesures pour le limiter aux moissonneurs connectés15.

13 https://ico.org.uk/media/about-the-ico/documents/4026232/joint-statement-data-scraping-202308.pdf

14 https://www.garanteprivacy.it/home/docweb/-/docweb-display/docweb/10019984#english

15 https://www.socialmediatoday.com/news/twitter-implements-usage-limits-combat-data-scrapers/

Pour Conclure…

Le moissonnage de données est un sujet complexe qui suscite de nombreuses questions et débats. Dans ce contexte, la consultation de la CNIL est cruciale, et il est essentiel que chacun puisse s’exprimer sur ce sujet sensible. Comme le souligne cet article, il est difficile de tout interdire ou de tout autoriser sans discernement.

La clé réside dans un compromis basé sur la transparence et le respect des droits des individus. Il est indispensable que les utilisateurs soient clairement informés des campagnes de moissonnage, de leurs objectifs et de leur droit de s’y opposer. A cette fin, la CNIL propose, dans sa dernière consultation, l’idée de créer un registre sur son site où les organisations utilisant des données collectées par moissonnage pour le développement de systèmes d’IA pourraient s’inscrire. Par ailleurs, chacun a un rôle à jouer en contrôlant les informations qu’il publie en ligne, ce qui souligne le besoin d’une éducation et d’une sensibilisation accrues sur la gestion des données personnelles.

Pour reprendre les mots de Solove et Hartzog, le moissonnage de données devrait être perçu comme un « privilège » qui impose des responsabilités aux moissonneurs. Cela signifie qu’une attention particulière doit être portée au principe de la minimisation des données si cher au RGPD16, à la sécurité des données collectées et au respect des droits des utilisateurs. Une telle approche permettra de trouver un équilibre juste et équitable, garantissant à la fois la protection de la vie privée et le développement responsable de l’Intelligence Artificielle. Finalement, le développement de « l’IA frugale17 » qui consiste à développer des plus petits modèles, utilisant notamment moins de données d’entrainement mais de meilleure qualité, apporte des perspectives intéressantes en termes de protection de nos données.

Claude Castelluccia, Directeur de recherche chez Inria, au sein de l’équipe Privatics de Grenoble, et commissaire à la CNIL en charge de l’Intelligence Artificielle.

16 https://www.cnil.fr/fr/reglement-europeen-protection-donnees/chapitre2#Article5

17 https://www.univ-grenoble-alpes.fr/actualites/the-conversation/sciences/the-conversation-l-ia-peut-elle-vraiment-etre-frugale–1428627.kjsp