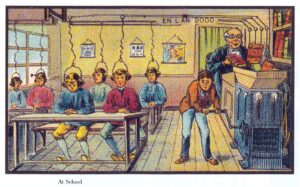

Former 300 000 éducateurs, animateurs, enseignants pour que ceux-ci puissent demain utiliser le code informatique dans leurs activités devant les enfants et les adolescents, c’est le défi fou de Class’Code. Faire aussi qu’apprendre à programmer ne soit pas une fin en soi mais un moyen de s’approprier vraiment le monde numérique : ils sont totalement fous ! A Binaire, nous sommes fans de Class’Code*. Nous croyons en ce projet d’une importance considérable pour la France. Nous vous tiendrons régulièrement informé de ses avancées. Serge Abiteboul.

L’introduction du numérique à l’école doit s’accompagner pour réussir de la formation des enseignants et d’éducateurs de qualité. Cette formation est l’objectif du projet Class’Code qui a été lancé le mardi 15 septembre. Le projet est piloté par Inria, et soutenu par le Programme d’Investissements d’Avenir.

Class’Code s’est donné comme défi de former, dans les 5 prochaines années, 300 000 éducateurs, animateurs et enseignants, celles et ceux qui vont avoir à éduquer au numérique les prochaines générations.

Pour y arriver, le projet a regroupé des compétences de tous types : sociétés professionnelles de l’informatique et du numérique, acteurs de l’éducation populaire et de la médiation numérique, entreprises spécialisées dans la formation des enfants ou dans la production de MOOCs, régions, organismes de recherche et de l’enseignement supérieur… Ce sont ainsi plus de 20 partenaires qui travaillent ensemble !

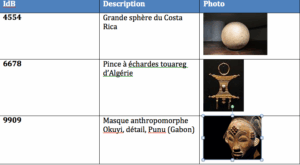

|

Valérie est également Madame la Maire de Villeneuve-les-Bois. Elle a été convaincue de l’intérêt d’enseigner l’informatique en périscolaire. Elle a demandé à deux employés municipaux qui gèrent des activités périscolaires dans la commune de suivre la formation Class’Code. Devant l’intérêt des parents (et surtout des enfants), elle a également recruté une animatrice supplémentaire : le fait que celle-ci ait suivi une formation reconnue la rassure. |

Pour former à une telle échelle, Class’Code va construire ce qui sera le plus important dispositif de formation hybride jamais mis en place :

- Un ensemble de formations en lignes dont le principal support est la vidéo, permettant à chacun de suivre gratuitement les cours.

- Un dispositif à l’échelle nationale permettant à chacun de s’intégrer dans un groupe local d’éducateurs qui vont se rencontrer régulièrement pour s’entraider, ajouter des activités de terrain à leur apprentissage en ligne, bénéficier de l’expérience supplémentaire de certains animateurs aguerris ou de professionnels de l’informatique (techniciens, ingénieurs, chercheurs, étudiants, enseignants), faire le lien entre les connaissances et les sujets de société dans lesquels le numérique joue un rôle primordial.

Kevin est employé par la Mairie de Villeneuve-les-Bois. Il intervient dans les écoles, sur le temps périscolaire. L’idée d’animer un atelier sur « le code » lui semblait intéressante, mais il ne savait pas par où commencer. Il a suivi Class’Code et réussit aujourd’hui à parler de création, de technologie, d’applications et de sciences informatiques à des enfants de 10 ans… qui adorent ça ! |

L’ambition de ce projet va reposer sur beaucoup de pragmatisme, énormément de volonté, et un certain nombre de principes essentiels :

- L’équité territoriale, un enjeu majeur et difficile. Pour éviter une possible fracture numérique demain, il convient aujourd’hui d’être attentif à ce qu’équipements et compétences atteignent toutes les banlieues, toutes les campagnes.

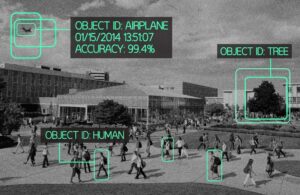

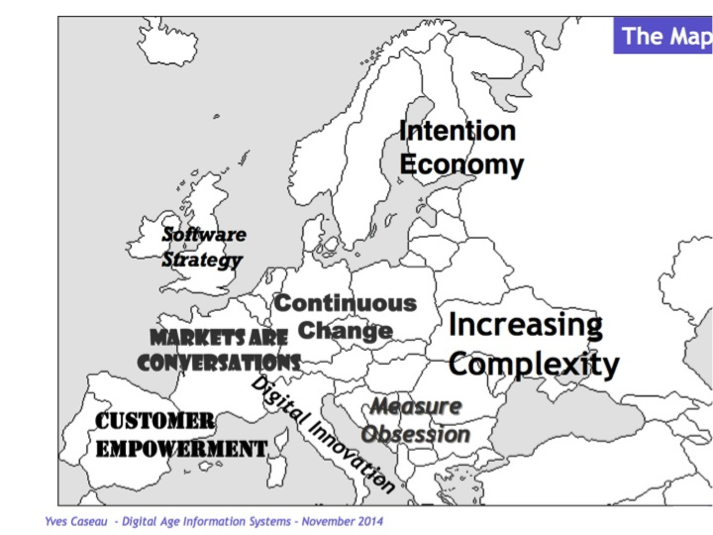

- Le code comme point de rencontre de la science informatique, la technique et la société. A Class’Code, nous pensons résolument que le numérique, pour être compris, et pour ne pas faire peur, doit être abordé à travers la science et la technologie et non seulement par l’étude de ses usages ou l’analyse de ses conséquences.

- L’informatique, comme support à une éducation ouverte. Proche des préconisations du Conseil National du Numérique, Class’Code va s’appuyer sur une pédagogie participative : le jeu, le partage, la découverte, la création… autant de leviers qui doivent trouver leur place dans la formation des éducateurs avant d’atteindre celle des enfants. Le code n’a aucune raison d’être rébarbatif. Ce n’est ni un gadget ni une fin en soi ; c’est un support privilégié pour acquérir les compétences en partageant le plaisir.

- Le soutien des informaticiens et des professionnels du numérique (étudiants, élèves, techniciens, ingénieurs). En France, énormément de personnes, d’entreprises exercent dans leur métier l’informatique ou l’étudient… Ils ont, depuis longtemps, exprimé leur envie de contribuer à la formation de la jeunesse. Leurs entreprises, les écoles, universités et laboratoires de recherche sont souvent membres de réseaux, de fédérations, de collectifs qui ont adhéré à Class’Code et sont prêts à soutenir son action.

Amine est animateur depuis 2 ans auprès d’un organisme d’éducation populaire. On lui a proposé la formation Class’Code pour devenir animateur en informatique. Il a dit oui, est vite devenue opérationnel et intervient déjà plusieurs fois par semaine auprès d’enfants de 7 à 10 ans. Il bénéficie de l’aide de Paule, ingénieure en informatique, qui lui explique les choses qui lui paraissaient trop compliquées et intervient parfois auprès de lui devant les enfants. |

- La création de ressources éducatives libres. Un enjeu majeur, mis en avant à la fois par l’UNESCO et l’OCDE est de rendre les objets du savoir librement accessibles. Le projet Class’code s’y est engagé : cela permettra, au-delà du projet, au-delà de la géographie, à d’autres initiatives de réutiliser, réadapter le matériel créé et de le partager.

- Une démarche prenant en compte les enjeux de genre. Aujourd’hui encore, l’un des deux genres a peu accès à l’informatique. Si l’on est de ce genre, il est beaucoup plus difficile de se voir proposer les enseignements qui permettent d’avoir accès aux métiers du numérique, qui sont pourtant parmi ceux qui permettent aujourd’hui, mais surtout demain, d’exercer des emplois bien rémunérés, modernes, passionnants. Les obstacles sont nombreux et il est évident que Class’Code ne les fera pas tomber tous. Mais nous nous engageons à être vigilants sur ces questions, à remettre en cause régulièrement nos actions.

Paule travaille dans une entreprise du numérique. Son entreprise a été convaincue de l’intérêt de l’opération et lui a libéré du temps pour qu’elle suive le MOOC de Class’Code. Elle est ainsi devenu facilitatrice : elle contribue à la formation des animateurs et enseignants en expliquant, mais aussi en ajoutant des éléments de fond dans les débats concernant l’impact du numérique. Au début, Paule pensait n’avoir rien à apprendre car elle était informaticienne… Mais elle a vite vu qu’expliquer cela aux enfants n’était pas si simple : maintenant, elle accompagne Amine quand son emploi du temps le lui permet dans les ateliers périscolaires qu’il gère. |

Les prochaines étapes

Grâce à un coup de pouce financier de la Région des Pays de la Loire et au soutien de la région PACA, le projet a pu se mettre en marche avant sa signature institutionnelle. Cela permet aux équipes de construire les premiers MOOCs, de mettre en place les premières infrastructures pour lancer des expérimentations dès le printemps 2016 et ouvrir les inscriptions pour la première formation à l’automne 2016.

Najat est Ministre de l’Éducation. Elle a compris que les ressources éducatives libres produites par Class’Code étaient susceptibles d’être réutilisées, réadaptées pour la formation des enseignants de l’Éducation Nationale. En suivant Class’Code, les enseignants peuvent non seulement se former au numérique en s’appuyant sur des connaissances scientifiques et technologiques, mais également suivre un MOOC et donc expérimenter cette nouvelle forme d’apprentissage ! |

L’équipe opérationnelle de Class’Code: Camila, Camille, Claude, Colin, Daniela, Florent, Guillaume, Martine, Romain, Sophie, Thierry, …

Pour aller plus loin

- Le projet Class’code. Il est possible, sur le site, de s’inscrire pour être informé(e), proposer de participer, d’aider à animer un territoire, une formation, etc.

- Les Flots ou MOOCs (massive open online course) en anglais.

- Les ressources éducatives libres et les positions de l’UNESCO et de l’OCDE.

- Les questions de genre dans le secteur du numérique

Les partenaires de Class’code. Autour de la Société informatique de France, se retrouvent unis avec Magic Makers, porté par Inria, associant OpenClassrooms, La Main à la pâte, Pasc@line, Simplon.co, Les Petits Débrouillards, la fédération des Pupilles de l’Enseignement Public, Atelier Canopé des Alpes-Maritimes, les régions des Pays de la Loire et PACA, les universités de Evry, Côte d’Azur, Nantes, et Franche-Comté, le CIGREF, l’AFDEL, en lien avec le CNAM, l’université d’Orléans, la médiathèque d’Antibes, l’initiative jecode.org, France-IOI, et ce n’est pas fini…

(*) Class’Code est soutenu -sous le nom de MAAISoN- au titre du Programme d’Investissements d’Avenir dont la Caisse des Dépôts est opérateur.

Class’Code est soutenu -sous le nom de MAAISoN- au titre du Programme d’Investissements d’Avenir dont la Caisse des Dépôts est opérateur.