Voici ce que je retiens d’un petit livre de deux grands chercheurs sur l’intelligence humaine et l’intelligence machine.

Voici ce que je retiens d’un petit livre de deux grands chercheurs sur l’intelligence humaine et l’intelligence machine.

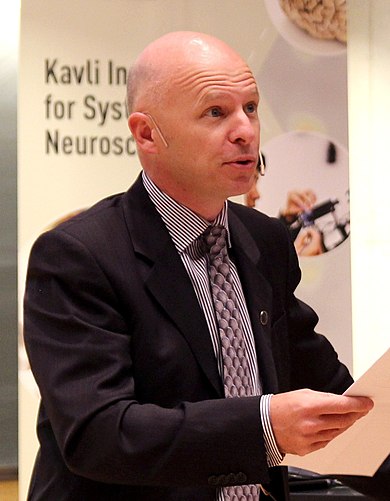

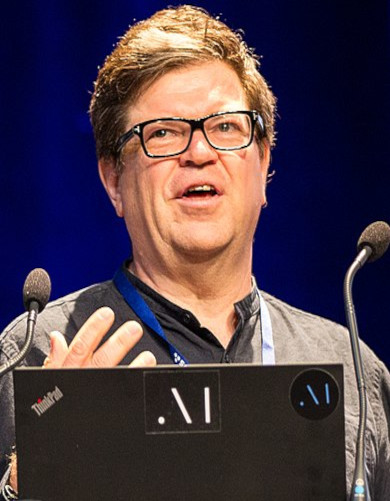

Le recueil, déjà ancien mais toujours actuel, est basé sur une interviewi de deux chercheurs français mondialement connus : Stanislas Dehaene, titulaire de la chaire de psychologie cognitive expérimentale au Collège de France, pour notre cerveau et notre intelligence, et Yann Le Cun, prix Turing, pour les machines bio-inspirées comme le deep learning et leur intelligence artificielle. Ce livre est passé sous les radars des media car il privilégie la science au détriment du buzz.

Il se lit d’un trait.

Voici ce que j’en retiens.

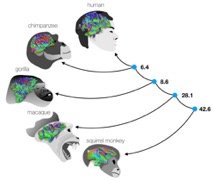

L’intelligence est présentée comme la capacité générale à s’adapter à une situation. Selon cette définition, l’intelligence émotionnelle est un aspect de l’intelligence, à laquelle contribuent aussi bien nos sens, nos mains que notre cortex, le tout constituant un système de saisie et de traitement d’informations qui accroît les chances de survie de l’espèce en fonction de son environnement, ainsi que celles de l’individu au sein de son espèce. Il s’agit d’une organisation qui n’est pas nécessairement basée sur des neurones, ainsi l’intelligence d’une moule consiste en son aptitude à filtrer l’eau pour en tirer des nutriments. Néanmoins, au fil du temps, les systèmes interconnectant les « petites cellules grises » ramifiées se sont avérés particulièrement performants. Quant à l’humain, il a bénéficié de circonstances ayant permis l’extension de la boite crânienne et son cortex.

Tout le développement de la vie peut ainsi être vu comme un apprentissage compétitif de perpétuation. Le cerveau et son cortex ne sont pas de simples réseaux de neurones interconnectés au hasard, ils sont dotés de zones organisées et spécialisées et de processus de contrôle des connexions synaptiques sophistiqués. Les structures cérébrales les plus favorables ont été sélectionnées et figées avec plus ou moins de souplesse selon les avantages procurés. Ces zones ont constitué au fil du temps la partie innée de notre cerveau, dont les «noyaux gris» tels le striatum évoqué par Bohlerii. Le fonctionnement hérité de ces structures est inconscient, qu’il s’agisse de la régulation vitale de notre organisme, du traitement de la vision ou de tout autre signal capté par nos sens. L’évolution a conjointement à la structuration cérébrale de l’espèce préservé une plasticité cérébrale qui assure un avantage adaptatif à court terme, voire une capacité à se reconfigurer en cas d’accident ou d’invalidité. Cette plasticité permet chez l’humain une large part d’acquis à deux échelles. A l’échelle individuelle, il s’agit de l’apprentissage par l’expérience, le groupe, l’école, la culture. Cet apprentissage se traduit en structurant les circuits neuronaux par des « réglages » des synapses, qui sont des millions de milliards de points de transmission d’informations électrochimiques entre les neurones. Les connaissances ainsi apprises par un individu durant sa vie disparaissent avec lui. Mais elles sont transmises à l’échelle collective par un processus qui sort du cadre de l’hérédité génétique et est spécifique aux hominidés: la civilisation, ses constructions, ses outils, ses objets, ses cultures, ses croyances, ses sciences et ses arts – et en dernier lieu l’écriture et la capacité à se construire une histoire. Au lieu de coévoluer avec sa savane, sa mer ou sa forêt, l’humain coévolue avec l’accumulation de ses créations. Pour illustrer la dualité inné-acquis, Dehaene prend l’exemple des langues et de la causalité. Si un bébé peut apprendre n’importe quelle langue, c’est parce que toutes les langues ont des principes communs, et qu’une zone du cerveau s’est spécialisée dans leur traitement. Pour la causalité, imaginons deux populations sur une île. L’une fait le lien entre une chute de pierre et un danger, entre un crocodile et un danger, entre un signe de congénère et son attitude envers lui, autant d’exemples de lien entre cause et effet. L’autre population ne fait pas le lien, celle-ci disparaîtra et à la longue l’espèce survivante héritera de structures ou zones du cerveau «câblées» pour la recherche de causalités. De même pour les corrélations.

Ces considérations donnent la tonalité du récit de l’évolution de l’intelligence proposé dans le livre et font consensus dans les milieux scientifiques actuels. Il faut néanmoins souligner qu’il ne s’agit que de récits, pas de modèles aussi éprouvés que l’électromagnétisme ou la relativité. Il s’agit d’une tentative de dresser le tableau d’ensemble d’un puzzle dont de nombreuses pièces sont manquantes. Il en est de même du récit darwinien en général. Néanmoins en neurosciences on peut monter des expériences pour conforter ou infirmer des hypothèses, et Dehaene en relate quelques-unes, alors qu’en paléontologie ou en anthropologie on est souvent réduit à fouiller à la recherche d’indices peut-être disparus.

Pour ce qui est des machines, Le Cun fait à juste titre remarquer que le terme «intelligence machine» serait plus adéquat que celui consacré d’«intelligence artificielle» car l’intelligence est un système évolutif et interactif, dont l’organisation importe plus que le support, biomoléculaire ou silicium. On pourrait même voir l’écologie et l’évolution de la planète comme une intelligence, sans pour autant verser le moins du monde dans le culte de Gaïa (un chapitre du livre s’intitule d’ailleurs «L’intelligence de la vie»). Remarquons au passage que cette idée évoque la mouvance nord américaine de l’Intelligence design, à ceci près – nuance qui n’est pas des moindres – que dans cette vision épurée du judéo-christianisme, l’intelligence évoquée est finaliste, elle est la main de Dieu. Alors que dans le darwinisme nul objectif, nulle réalisation de dessein ne sont assignés au cheminement de l’évolution. Ce qui fait envisager en fin d’interview le dépassement de l’intelligence humaine sur le temps long, le passage par un couplage humain-machine semblant aux auteurs une étape probable. A noter qu’il n’est heureusement pas pour autant question dans l’ouvrage de transhumanisme, ensemble de micro-mouvements pseudo scientifiques surfant entre crainte d’un grand remplacement (par des cyborgs) et sur la quête d’immortalité.

L’intelligence machine est survolée dans cet opuscule à travers sa comparaison à l’humain, et sous l’angle des machines bio-inspirées, comme l’est le deep learning dont Le Cun est un des pères. Le neuro et le data scientiste ne voient pas de limites a priori à l’intelligence machine, des progrès majeurs restant pour cela à accomplir dans la capacité de planification d’ensemble d’une stratégie, qui constitue encore un avantage majeur du cerveau humain. A noter que le mot «conscience» apparaît 22 fois sans être explicitement défini, car pour les interlocuteurs il est évacué de toute considération philosophique. Les activités innées sont inconscientes, celles apprises comme la conduite automobile le deviennent au fil de l’habitude. Les activités conscientes sont celles qui nécessitent de la réflexion.

Sur un plan technique, la rivalité historique entre l’approche symbolique (par le raisonnement) et l’approche connexionniste (par les réseaux neuronaux) de l’IA est brièvement rappelée. Le Cun y évoque ce que l’on a baptisé «l’hiver de l’IA», fait de discrédit et d’assèchement des financements, dans lequel les déconvenues du Perceptron avait plongé le connexionnisme. Il souligne un fait souvent passé inaperçu qui éclaire pourtant la triomphale résurgence des réseaux de neurones. Il s’agit des travaux activement menés durant cet «hiver» de deux décennies sous la modeste appellation de «traitement du signal et des images» pour ne pas agiter le chiffon rouge d’une intelligence artificielle bio-inspirées. Ces travaux ont notamment mené aux réseaux de convolution (CNN Convolution Neural Network) chers à Le Cun et qui sont à la base du succès du deep learning.

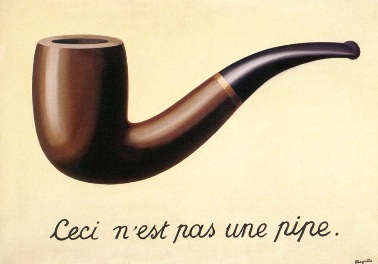

Enfin les auteurs pointent un principe essentiel, qui lui est largement connu mais qu’il est bon de marteler : «Apprendre, c’est éliminer» dit Dehaene en écho à une expression fétiche de son maître Jean-Pierre Changeux. Et l’on peut ajouter qu’apprentissage et créativité sont les deux faces d’une même pièce. Pas seulement au sens de la connaissance comme terreau du progrès, mais en un sens beaucoup plus fondamental relevant des lois du traitement de l’information au même titre que la chute de la pomme relève des lois physiques. En deux mots, apprendre par coeur ne sert à rien, si l’on apprend à reconnaître un visage en retenant par coeur chaque pixel d’un photo, on ne saura pas reconnaître la personne sur une autre photo, il faut approximer un visage par quelques caractéristiques, c’est à dire «éliminer» intelligemment les informations inutiles. Et il se crée ainsi des représentations internes du monde qui en sont des approximations utiles pour nous. Cependant, aucune pression évolutive n’a «verrouillé» l’usage de ces représentations en les limitant aux instances qui les avaient suscitées. Ainsi notre propension «câblée» à la causalité, déjà évoquée, sorte d’approximation de la logique usuelle du monde qui nous entoure, nous a fait imaginer des dieux comme causes des évènements naturels, et nourrit aussi peut-être le complotismeiii et sa recherche de causes cachées.

Max Dauchet, Professeur Émérite de l’Université de Lille.

En savoir plus : on ne peut que chaudement recommander au lecteur motivé les vidéos des cours donnés au Collège de France par Stanislas Dehaene en Psychologie cognitive expérimentale, Yann Le Cun en Informatique et Sciences du Numérique et aussi Benoit Sagot dans la même discipline, ainsi que ceux de Stéphane Mallat en Sciences des données, ces derniers portant sur les réseaux de neurones comme approximateurs au sens des lignes qui précédent.

Références :

i Stanislas Dehaene, Yann Le Cun, Jacques Girardon. La Plus Belle Histoire de l’intelligence. Des origines aux neurones artificiels : vers une nouvelle étape de l’évolution. Ed. Robert Laffont, collection La Plus Belle Histoire, 2018.

ii Sébastin Bohler, Le striatum, ed. bouquins, 2023.

iii Dans le livre seuls les dieux sont évoqués comme « inventions », le complotisme n’est pas cité.

Oui, binaire s’adresse aussi aux jeunes de tous âges, que les sciences informatiques laissent parfois perplexes. Avec « Petit binaire », osons ici expliquer de manière simple et accessible, comment modéliser informatiquement la… créativité. Marie-Agnès Enard, Pascal Guitton et Thierry Viéville.

Oui, binaire s’adresse aussi aux jeunes de tous âges, que les sciences informatiques laissent parfois perplexes. Avec « Petit binaire », osons ici expliquer de manière simple et accessible, comment modéliser informatiquement la… créativité. Marie-Agnès Enard, Pascal Guitton et Thierry Viéville.

Mieux comprendre comment s’opèrent les choix dans notre cerveau et son fonctionnement, c’est ce que propose d’expliquer le neurobiologiste bordelais

Mieux comprendre comment s’opèrent les choix dans notre cerveau et son fonctionnement, c’est ce que propose d’expliquer le neurobiologiste bordelais  Décider est souvent peser le pour et le contre, de manière non biaisée, c’est ce que l’on représente au niveau de l’allégorie de la justice avec le bandeau et la balance à fléau. ©

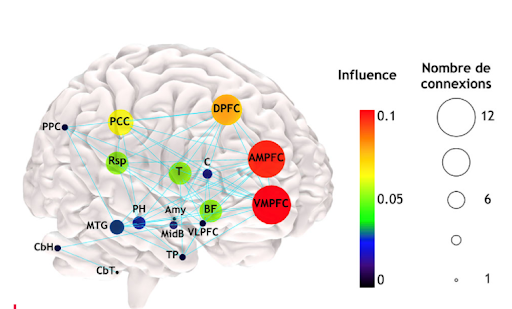

Décider est souvent peser le pour et le contre, de manière non biaisée, c’est ce que l’on représente au niveau de l’allégorie de la justice avec le bandeau et la balance à fléau. © L’équipe-projet Mnemosyne d’Inria commune avec le Labri et l’IMN à Bordeaux travaille sur la modélisation des fonctions cognitives du cerveau, de manière pluri-disciplinaire. (Crédit : Inria / Photo H.Raguet).

L’équipe-projet Mnemosyne d’Inria commune avec le Labri et l’IMN à Bordeaux travaille sur la modélisation des fonctions cognitives du cerveau, de manière pluri-disciplinaire. (Crédit : Inria / Photo H.Raguet).