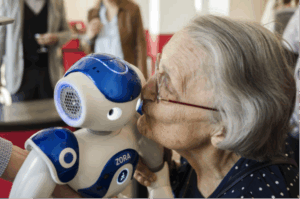

Laurence Devillers est Professeure à l’université Paris-Sorbonne et chercheuse au Laboratoire d’informatique pour la mécanique et les sciences de l’ingénieur du CNRS. Elle nous parle des dimensions affectives dans nos interactions avec les machines. Avec elle, nous pouvons imaginer ces robots à venir qui participeront au soin des personnes âgées, les aideront dans leurs tâches quotidiennes, leurs permettront de rester plus longtemps autonomes. Cela nous conduit évidemment à réfléchir à un autre sujet : il ne faudrait pas que de tels robots deviennent une excuse pour nous décharger sur eux du soin de personnes qui doivent aussi être entourées par des humains.

Laurence Devillers est membre de la CERNA, la commission de réflexion sur l’Ethique de la recherche en sciences et technologies du Numérique d’Allistène et a participé au rapport sur l’Ethique du chercheur en robotique. Elle participe également à une initiative mondiale IEEE sur l’éthique dans la conception de systèmes autonomes.

Dans le cadre des Entretiens autour de l’informatique.

B : Laurence, ta page web explique que ta recherche porte sur la « dimension affective et sociale dans les interactions parlées avec les robots ». Tu peux nous expliquer ?

LD : Lorsqu’on interagit avec quelqu’un, on fait passer par le langage verbal et non verbal, non seulement des informations sémantiques mais aussi des informations d’ordre affectif et social, liées à la connaissance qu’on a de l’autre, à l’intimité qu’on va avoir avec l’autre. Le langage non verbal, par exemple l’intonation de la voix, les gestes, les mimiques faciales, mais aussi l’attitude corporelle nous permet d’exprimer beaucoup d’informations émotionnelles. Nous essayons de faire des machines qui aient ce type de compétence, qui comprennent les humains, des machines « empathiques », capables d’exprimer une émotion particulière à un moment donné.

B : Comprendre ce que ressent une personne, pour mieux la servir, c’est facile de voir pourquoi c’est utile. Mais pourquoi une machine devrait-elle exprimer de l’empathie ?

LD : Cela peut servir à expliquer, à éduquer, à rassurer les personnes avec lesquelles la machine interagit. Par exemple, je pense à la stimulation cognitive des personnes âgées atteintes de maladies telles que la maladie d’Alzheimer. Un robot peut réagir comme un chat, avec des comportements pseudo-affectifs. Le malade va alors jouer avec le robot comme si c’était un animal de compagnie, ce qui le stimule du point de vue émotionnel et crée un lien social. De même, les robots peuvent aider des enfants autistes qui ont du mal à exprimer leurs émotions ou à comprendre les émotions des autres.

Mais il nous reste beaucoup de progrès à réaliser. Nous sommes seulement capables de créer des objets non contextualisés, qui ne savent pas vraiment interagir avec le monde réel. L’adaptation des robots aux personnes et au contexte est un défi, et ce défi passe par la modélisation des états affectifs.

B : La difficulté pour un robot est-elle de comprendre les sentiments des personnes ou est-ce de simuler des sentiments ?

LD : Les émotions sont en quelque sorte l’expression des sentiments, l’interface avec les autres. Les émotions vont de pair avec des sensations physiques et un passage à l’action, par exemple la fuite devant un serpent. L’expression des émotions est multimodale et combine des indices dans la voix, le visage et les gestes. Il est plus facile, d’un point de vue informatique pour un robot de simuler des émotions même si celles-ci sont dépourvues de sensations physiques que de les reconnaître. Pour créer une expression émotionnelle sur le visage, nous pouvons nous appuyer sur de nombreux travaux depuis Darwin, par exemple ceux de Paul Ekman, qui a créé des unités faciales que l’on peut composer sur le visage d’un robot afin d’exprimer une émotion donnée. Il y a aussi un grand nombre de travaux sur la génération des gestes et sur la synthèse émotionnelle de voix expressive.

Pour la reconnaissance des émotions, c’est beaucoup plus compliqué à cause de la très grande variabilité des expressions entre les individus suivant les contextes et les cultures. Les sentiments sont des représentations mentales conscientes et sont souvent cachés, particulièrement dans certaines cultures. Par exemple, il nous arrive d’exprimer une émotion positive et d’éprouver en réalité un sentiment de tristesse. Si le robot reconnaissait les expressions émotionnelles exprimées par une personne, il pourrait peut-être ensuite prédire le sentiment suivant le contexte. Pour la reconnaissance des émotions à partir de la voix, on s’appuie par exemple sur des indices comme le timbre, l’énergie, le rythme ou encore la qualité vocale de la voix d’une personne. On utilise des techniques d’ « apprentissage automatique » pour modéliser les émotions. C’est le machine learning dont on parle tant en ce moment.

B : Tu peux nous en dire un peu plus sur les algorithmes que vous utilisez ?

LD : Nous procédons en trois phases : codage, étiquetage, modèle. Prenons un exemple de reconnaissance des émotions à partir d’une bande son. Nous choisissons dans ce signal un certain nombre d’ « aspects », qui vont nous donner des centaines, voire des milliers de coordonnées physiques. Nous codons donc la bande son en une séquence de vecteurs de ces coordonnées. Le codage est la phase la plus compliquée. Il faut choisir les bons paramètres, et cela demande une compréhension poussée des expressions des émotions. Il faut arriver à une information plus compacte, mais qui ait gardé suffisamment d’information pour pouvoir encore y retrouver les émotions.

L’être humain intervient ensuite en étiquetant ces séquences de vecteurs (segments de son, de vidéo), avec des émotions, colère, joie, tristesse… L’algorithme d’apprentissage automatique essaie ensuite d’ « apprendre » un modèle à partir du signal et des étiquettes. C’est ce modèle que le robot va utiliser. Une personne va parler et un programme va utiliser alors le modèle pour prédire que le signal correspond vraisemblablement à telle ou telle émotion.

En quelque sorte, le programme essaie de trouver des ressemblances avec des signaux existants dans le corpus de données de départ. S’il trouve une ressemblance avec un signal étiqueté « colère », il en déduit que la personne est en colère.

B : Vous utilisez l’apprentissage profond, le deep learning ?

LD : Nous avons surtout utilisé une autre technologie, les « machines à vecteurs de support », pour la détection des émotions. Nous commençons à utiliser le deep learning, c’est à dire les « réseaux de neurones convolutionnels », mais il est nécessaire d’avoir de très grands corpus pour l’apprentissage. Le deep learning extrait directement les paramètres à partir du signal brut et les compose automatiquement. C’est une direction intéressante qui donne de bons résultats mais c’est une approche de type boite noire qui ne permet pas de savoir quels sont les critères utiles. L’approche manque de transparence.

B : On voit bien l’importance de la qualité des données du départ, et de leur étiquetage.

LD : C’est essentiel. La plupart des corpus disponibles sont artificiels. Ils sont obtenus par exemple avec des acteurs de théâtre à qui on demande de reproduire des émotions. Et c’est une limitation importante. Un axe majeur de recherche est de construire des corpus importants de données sur les sentiments, obtenus dans des contextes réels, étiquetés par les émotions effectivement présentes. Pour ma part, j’ai travaillé avec des corpus réels enregistrés au SAMU. Nous observons alors que la plupart des émotions ne sont pas aussi simples que cela. Elles sont souvent mélangées, par exemple vous pouvez ressentir de l’anxiété, ou de la peur et du soulagement en même temps parce que quelqu’un vient vous aider. Nous retrouvons cette complexité dans des conversations, que nous avons également étiquetées, de clients non satisfaits et qui contactaient le centre d’appels d’EDF.

De manière plus générale, nous analysons les informations linguistiques, les mots que les personnes prononcent, ainsi que les informations paralinguistiques, les intonations, le rythme, le timbre de la voix mais également certaines expressions du visage comme le sourire, etc. Nous essayons de corréler toutes ces informations pour comprendre le sentiment réel de la personne.

B : Quel est le critère de succès ?

LD : Il est très simple : c’est la réaction de l’individu devant le robot. Concrètement, si le robot dit « Tu as l’air en colère, Marie », et que Marie répond : « Oui ! Je suis très en colère », c’est gagné !

B : Mais nous n’exprimons pas tous nos sentiments de la même manière. Pouvez-vous personnaliser cette analyse en fonction de l’individu ?

LD : Nous normalisons la voix, puis nous construisons au fur et à mesure un profil expressif de la personne, par exemple ses dimensions d’extraversion, d’émotionalité et d’interaction : répond-elle quand nous lui posons une question ? Nous conservons cette information et nous pouvons en tenir compte pour analyser plus tard les sentiments de cette personne ou pour la prise de décision du robot et le changement de comportement en temps réel durant l’interaction. Il est aussi important d’adapter ces technologies en fonction des différentes cultures.

B : Les machines sont-elles capables de faire des choses que les psychologues ne peuvent pas faire ?

LD : Les robots peuvent avoir une meilleure qualité de perception. Ils peuvent chercher dans la voix des indices que l’oreille humaine n’entend peut-être pas. Par exemple, la personne peut faire passer ses émotions par des micro-tremblements, qu’un humain n’entendra pas forcément mais qu’une machine peut entendre. Les médecins sont preneurs de telles technologies surtout pour le suivi de malades.

Les robots peuvent aussi enregistrer et analyser des signaux 24 heures sur 24. Ils peuvent y détecter des signes et quand c’est nécessaire déclencher une alerte auprès d’un médecin. Par exemple, en ce qui concerne les débuts de démence ou de dépression, il peut y avoir des signes ponctuels pendant la journée, qui ne surgissent pas forcément au moment où le patient voit le médecin.

Enfin, les robots sont patients. Des humains en fin de vie ont un rythme très lent. Les humains accompagnants ne sont pas toujours prêts à répéter les mêmes phrases avec un rythme super lent, mais un robot, si. Le robot sait synchroniser ses mots dans un dialogue très lent. Il sait attendre que quelqu’un trouve ses mots.

B : L’humain n’aura-t-il pas l’impression qu’on rentre dans son intime, si la machine sait tout ce qu’il ressent ?

LD : Il faut des garde-fous. Personnellement, je trouverais insupportable un environnement dans lequel nous serions entourés de machines qui analyseraient nos émotions, sans raison, ou juste pour des motifs commerciaux, ou pour une surveillance policière. Mais si c’est pour l’accompagnement médical des personnes, pour leur bien-être, cela se justifie.

B : Ces liens d’émotion entre humains et robots ne peuvent-ils pas avoir quelque chose de déconcertant, voire d’inquiétant ?

LD : Dans les années 50, les psychologues Heider et Simmel ont fait l’expérience de projeter un film où un grand triangle poursuivait deux autres petites formes géométriques, un triangle et un rond. Les spectateurs, en voyant ces mouvements, leur prêtaient des intentions et imaginaient des scenarios rocambolesques sachant très bien qu’ils s’agissaient de formes géométriques. Dans le film, il y a bien une intention qui vient du réalisateur, mais le sentiment vient de l’interprétation que l’humain fait de ce qu’il voit. Est-ce qu’un robot a des sentiments ? Non, c’est l’humain qui lui prête des sentiments, une personnalité. On peut ainsi parler à son chien ou à son chat en étant parfaitement conscient qu’il ne comprend pas.

Les roboticiens cherchent à produire des robots avec lesquels une personne aura de l’empathie. Pour eux, les machines simulent, ce sont juste des coquilles vides qui n’ont pas d’intériorité, pas d’émotions. Ce sont les utilisateurs de ces machines qui vont interpréter leur comportement à travers un prisme anthropomorphique, leur prêter une humanité qu’elles ne possèdent pas. Les utilisateurs vont projeter leurs émotions sur ces machines. Mais est-ce que c’est gênant ? Où est le problème si les personnes préfèrent s’imaginer que les robots ont des émotions ? De mon point de vue, il n’y a pas de problème.

Je ne vois qu’un seul risque : que l’humain s’attache trop à un robot. Il faut maitriser cette empathie avec les machines pour éviter la confusion avec une empathie humaine. Ce risque est d’autant plus présent que la future génération de robot sera douée d’apprentissage en continu. Les robots apprendront au contact des humains ce qui risque de renforcer l’attachement à la machine, un peu comme un adulte apprend à son enfant. L’apprentissage en continu des machines est une importante rupture technologique et juridique. Il y pourrait y avoir une coresponsabilité en cas de problème avec un robot entre le concepteur et l’utilisateur.

B : Tu es passionnée par ton travail. Qu’est-ce qui te motive ?

LD : Le mystère des sentiments. Je cherche avant tout à comprendre. Quand j’étais enfant, je voulais travailler sur le cerveau. Je ne suis pas si loin ! Cela m’a conduite à interroger mon rapport aux machines et aux robots et à réfléchir sur l’éthique de ces robots affectifs artificiellement. J’aimerais construire des systèmes d’interaction entre robots et humains qui respectent les règles morales de la vie en société et puissent accompagner les personnes âgées notamment souffrant de la maladie d’Alzheimer. A titre personnel, j’aimerais avoir, chez moi dans trente ou quarante ans, un robot qui ait aussi le sens de l’humour ! C’est un sujet de recherche sur lequel nous travaillons.

Entretien recueilli par Serge Abiteboul et Claire Mathieu.

Pour aller plus loin : « Rire avec les robots pour mieux vivre avec », Journal du CNRS 2015.

Robot, tu seras humain et drôle:

Cet article est publié en collaboration avec The Conversation.