Peux-tu nous dire d’où tu viens et comment tu t’es retrouvé spécialiste du numérique ?

Peux-tu nous dire d’où tu viens et comment tu t’es retrouvé spécialiste du numérique ?

C’est accidentel et contraint. J’ai suivi une formation littéraire, Normale Sup et agrégation, parce que j’aime la littérature. Mais l’enseignement et la recherche, ce n’était pas trop pour moi. Je me suis retrouvé à France Culture à m’occuper de société, de littérature, d’art. Quand Bruno Patino est devenu directeur de la chaîne, il m’a demandé de prendre en charge “Place de la Toile”, une émission un peu pionnière sur les cultures numériques. Je lui ai dit que le numérique ne m’intéressait pas. Il m’a répondu : “tu n’as pas le choix”. Il voulait que l’émission soit moins technique, ne soit plus réservée aux spécialistes et du coup, je lui paraissais bien adapté.

Cet été-là, j’ai beaucoup lu, en grande partie sur les conseils de Dominique Cardon. J’ai découvert que c’était hyper passionnant. Pas les aspects purement techniques que je ne maîtrisais pas, mais le prisme que le numérique procurait pour regarder tous les aspects de la société. J’ai été scotché et depuis cette passion ne m’a jamais quitté.

La contrainte journalistique que j’avais sur France Culture, c’était de parler à des gens qui aiment réfléchir (ils écoutent France Culture) mais qui sont souvent d’un certain âge et réticents à l’innovation technologique. Et ça tombait bien. Je n’y comprends rien, et l’innovation ne m’intéresse pas pour elle-même. Ma paresse intellectuelle et les limites de mes curiosités m’ont sauvé. Je ne me suis jamais “geekisé”. Bien sûr, avec le temps, j’ai appris. Je n’ai pas de culture informatique et mathématique et je reste très naïf devant la technique. Il m’arrive souvent de ne pas comprendre, ce n’est pas juste une posture. C’est sans doute pour cela que cela marche auprès du public qui, du coup, ne se sent pas méprisé ou auprès des personnalités que j’interviewe à qui je pose des questions simples que, parfois, elles ne se posent plus.

Quels sont tes rapports personnels avec l’informatique ?

Mon père était informaticien. Il avait fait à Grenoble une des premières écoles d’ingénieurs informatiques, au début des années 1970. Je ne voulais pas faire comme lui. Pourtant, j’ai passé pas mal de temps sur l’ordinateur de la maison, et pas que pour des jeux, bien que ma sœur ait été beaucoup plus douée que moi. Et je fais partie de cette génération qui a eu la chance d’avoir des cours d’informatique au lycée.

En fait, je me suis rendu compte de tout ça quand j’ai commencé à animer “Place de la toile”, je me suis rendu compte que sans le savoir j’avais accumulé une culture informatique acquise sur le tas, mais acquise tout de même. Je pense que cette culture est indispensable aujourd’hui. Il faudrait inclure du numérique dans toutes les disciplines. Et il faut également enseigner l’informatique comme enseignement spécifique. Il faudrait que tout cela imprègne plus toute notre culture, et de manière réfléchie, historicisée, problématisée.

Es-tu un gros consommateur de numérique ?

Non. Je reste raisonnable même si je regarde beaucoup les nouveautés, par curiosité. Mais, comme beaucoup de gens, je subis. Je mets du temps à régler des problèmes tout bêtes comme une imprimante qui ne marche pas. J’essaie de comprendre et je perds beaucoup de temps. J’ai mis longtemps à passer au smartphone. Je ne voulais pas être collé à mon écran comme les autres. Ensuite, c’est devenu une forme de dandysme de ne pas en avoir. Il faut quand même dire que je ne suis pas très à l’aise avec tous ces outils. Je constate que ma copine, qui est d’une autre génération, les manipule avec beaucoup plus d’aisance. Je le vis comme quelque chose d’exogène. Mais je pense que si ça ne mène pas à une technophobie un peu débile, cette distance n’est pas une mauvaise chose pour essayer de comprendre ce qui se passe.

Et les réseaux sociaux ?

Je pense que chaque réseau social a des particularités qui font qu’on s’y sent plus ou moins bien, que ce qui s’y passe nous intéresse plus ou moins. Je n’ai jamais été trop intéressé par Facebook. C’est un gros mélange un peu archaïque. On a des gens qui se causent, et des gens qui causent au monde. Je déteste Instagram qui me met mal à l’aise. C’est bourré de gens qui ne parlent que d’eux-mêmes, qui se mettent en scène en racontant la vie qu’ils voudraient avoir. Je n’aime pas dire ça, mais j’ai l’impression qu’il y a quelque chose de néfaste dans Instagram. On a beau savoir que c’est une mise en scène, cela pousse à une constante comparaison entre notre vie et celle des autres. TikTok, c’est tout autre chose ; je trouve cela assez génial. Les gens ne racontent pas leur vie, ils performent. Mais de tous les réseaux, celui que je préfère, c’est Twitter. C’est celui qui me convient et qui continue de me fasciner malgré tous les défauts qu’on peut lui trouver par ailleurs. C’est informationnel, c’est de la pensée. On ne s’étale pas.

Est-ce que l’informatique transforme nos vies, notre société ?

Qu’est-ce qui change ou qui ne change pas ? C’est la question qui m’obsède, la question centrale à laquelle j’essaie depuis toujours de répondre.

En quoi la littérature est-elle transformée ? Ce n’est pas facile de faire rentrer un objet comme un téléphone ou un ordinateur dans un roman. Pourtant certains ont ouvert le chemin. Et puis la littérature change aussi parce qu’il y a Amazon, les écrans, les livres numériques, et plein de nouveaux trucs. Mais la littérature reste la littérature.

Est-ce que des domaines changent ? Est-ce que nous-même nous changeons ?

J’en suis arrivé à une conclusion pas très radicale : ça change mais en même temps ça ne change pas vraiment. J’ai une fille de quinze ans. Sa sociabilité est radicalement nouvelle par beaucoup d’aspects. Mais elle fait un peu la même chose que ce que les adolescentes font depuis longtemps. Elle passe par les mêmes phases. Nous sommes très différents des Grecs de l’époque classique. Pourtant, quand tu lis le début de la république de Platon, ça parle du bonheur ou d’être vieux, bref, ça parle de nous. Et les questionnements de Platon nous touchent toujours.

Bien sûr, tout cela ne peut pas être un argument pour dire que les choses ne changent pas. Ce serait juste débile. On doit chercher à comprendre ce qui est comme toujours et ce qui a changé. Les questionnements fondamentaux restent les mêmes finalement, quelles que soient les mutations.

Tu n’as pas dit si tu considérais ces changements comme positifs ou pas.

Les technologies, comme disait Bernard Stiegler, sont à la fois des poisons et des remèdes. En même temps, et c’est souvent comme cela avec les techniques. C’est une platitude de dire que certains aspects d’une technique peuvent être bons et d’autres néfastes. Bien sûr, certains réseaux sociaux sont plus toxiques que d’autres. Mais les réseaux sociaux en général n’ont pas que des aspects toxiques. Dire qu’en général les réseaux sociaux sont asociaux parce qu’ils ont été créés par des geeks. Non ! On ne peut pas dire cela. C’est juste simpliste. Les réseaux sociaux influencent notre sociabilité en bien et en mal, ils la transforment. Il faut apprendre à vivre avec eux pour bénéficier de leurs effets positifs sans accepter les négatifs.

Est-ce que ces technologies transforment l’espace public ? Est-ce que le numérique est devenu un sujet politique ?

On observe une vraie reconfiguration de l’espace public. La possibilité donnée à chacun d’intervenir dans l’espace public transforme cet espace, interroge. Le fait qu’internet permette à des gens qui ont des opinions minoritaires, radicales, de s’exprimer a des conséquences sur le fonctionnement même de la démocratie. Cela repose la question de la place des interventions des citoyens dans l’espace public, la question de savoir quelle démocratie est possible. Ce sont des vieilles questions mais pour bien comprendre ce qui se joue, il faut observer ce qui a changé.

En cela, le numérique est devenu un sujet politique au sens le plus noble de la politique, et à plein de niveaux. Il pose aussi des questions de politique publique, de diffusion du savoir, de prise de parole. Par exemple, un détail, un aspect qui change la donne de manière extraordinaire : le numérique inscrit les opinions. Avant on avait des discussions et s’il y avait bien des prises de notes c’était un peu à la marge. Le temps passait et on n’avait que le souvenir des discussions. Aujourd’hui, on discute par écrit et on laisse plein de traces. Même quand c’est à l’oral, la discussion peut être enregistrée. On a toutes les traces. On peut retrouver ce que tu as dit des années après.

Et puis le numérique soulève de nouvelles questions politiques comme la prise de décision par des algorithmes ou la cohabitation un jour avec des machines intelligentes. Est-ce qu’on peut donner un coup de pied à un robot ? C’est une question politique et philosophique, pas uniquement juridique.

Que penses-tu des communs numériques ?

Je me suis intéressé aux communs via le numérique. Des gens comme Philippe Aigrain, Valérie Peugeot ou Hervé Le Crosnier, m’ont sensibilisé au sujet. J’ai lu un peu l’histoire des communs, des enclosures. La notion est hyper belle, intéressante. On voit bien théoriquement comme cela pourrait résoudre de nombreux problèmes, et permettre de penser des questions très contemporaines. Pourtant, ça n’a pas énormément pris. Je ne peux pas expliquer pourquoi. La théorie est peut-être trop compliquée. Peut-être des concepts alternatifs voisins ont-ils occupé l’espace en se développant, comme la tiers économie, l’économie du partage. Mais je crois quand même qu’on pourrait développer cette notion de commun, en tirer beaucoup plus.

Est-ce qu’il y a une particularité française dans le numérique ?

Je n’ai pas vraiment réfléchi au sujet. Je vois un côté très français dans le rapport entre le monde intellectuel et le monde numérique. Cela tient peut-être à une forte dissociation en France entre sciences et technique d’un côté et le littéraire et les humanités de l’autre. Nos intellectuels aiment se vanter de ne pas être scientifiques. A l’Assemblée nationale, on adore citer des philosophes mais on affiche rarement une culture scientifique. La conséquence est une vision décalée du sujet numérique. On va demander à Alain Finkielkraut ce qu’il pense d’une question autour du numérique alors qu’il n’y connaît rien. On a mis du temps à vraiment prendre en compte une culture informatique. Dans les milieux académiques des humanités, s’il y a eu assez tôt des chercheurs qui se sont emparés du numérique dans de nombreuses disciplines, j’ai l’impression que l’enthousiasme est moindre aujourd’hui.

Quelles sont les technos informatiques que tu trouves prometteuses, qui t’intéressent ?

Évidemment, l’intelligence artificielle est fascinante. C’est une mine de questions passionnantes. Comment ça marche ? Qu’est-ce qu’on en attend ? Qu’est-ce qu’on est en droit d’en attendre ?

En revanche, j’ai du mal à m’intéresser au métavers. C’est un truc qui est totalement créé par les grandes marques. Je n’ai jamais rien vu, dans le numérique, d’investi aussi vite par les marques. Internet est né comme un commun. Le métavers est dès l’origine dans un délire capitaliste.

Est-ce que, dans ta carrière, certaines interviews t’ont particulièrement marqué ?

Je pourrais en citer plein mais je vais me contenter de trois.

Pour Bruno Latour, je m’étais bien préparé mais pas lui. Il a débarqué au dernier moment, cinq minutes avant le direct, et il ne s’attendait pas à parler de numérique. Il m’a dit qu’il n’avait rien à raconter là-dessus. J’ai commencé par raconter un article du Guardian, et Latour n’a cessé pendant toute l’émission de relier les questions que je lui posais à cet article. C’était passionnant, une vision intelligente de quelqu’un de brillant, qui commentait les questions numériques sans être un expert, d’un peu loin.

Stéphane Bortzmeyer était à l’autre bout du spectre, quelqu’un de très proche du sujet, de la technique. Je craignais un peu qu’on n’y comprenne rien. Je m’attendais au pire après le premier contact au téléphone où il était très très laconique. Et l’émission démarre, et le mec sait être hyper clair, je dirais même lumineux. Un passeur de science extraordinaire avec toute son histoire, notamment politique.

Et enfin, je voudrais citer Clarisse Herrenschmidt, une spécialiste des premières écritures qui venait d’écrire un livre “les trois âges de l’écriture” : l’écriture monétaire arithmétique, l’écriture des langues, et enfin l’écriture informatique. J’ai trouvé sa démarche intellectuelle hyper intéressante. J’ai pris énormément de plaisir à l’interviewer. Elle me faisait découvrir un domaine extraordinaire. Elle m’a mis en relation avec de nombreux chercheurs qui ont conduit à plusieurs de mes émissions. Depuis quinze ans, je me suis beaucoup “servi” de mes invités : souvent ils m’ont eux-mêmes indiqué d’autres personnes passionnantes qui sont en dessous des radars journalistiques. Comme le milieu informatique n’est pas mon milieu naturel, ça m’est très utile. Clarisse a été une des ces “sources”.

Serge Abiteboul, Marie-Agnès Enard

https://binaire.socinfo.fr/les-entretiens-de-la-sif/

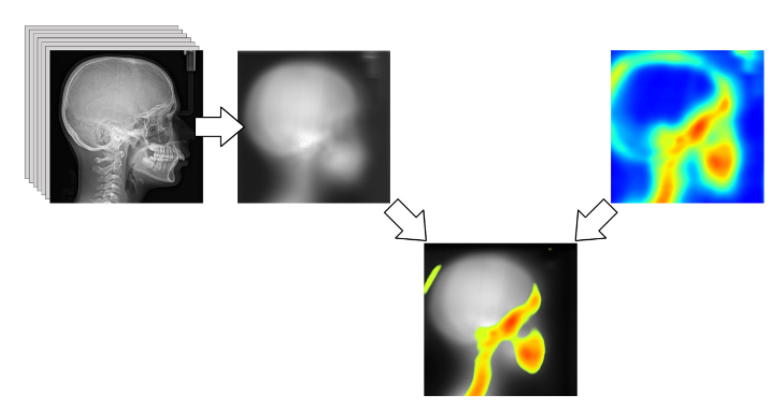

Scikit-learn est une bibliothèque libre Python destinée à l’apprentissage automatique. Elle offre des bibliothèques d’algorithmes en particulier pour les data scientists. Elle fait partie de tout un écosystème libre avec d’autres bibliothèques libres Python comme NumPy et SciPy. Pour les spécialistes, elle comprend notamment des fonctions de classification, régression et clustering. Elle fait un tabac dans le monde de l’apprentissage automatique. Nous avons rencontré

Scikit-learn est une bibliothèque libre Python destinée à l’apprentissage automatique. Elle offre des bibliothèques d’algorithmes en particulier pour les data scientists. Elle fait partie de tout un écosystème libre avec d’autres bibliothèques libres Python comme NumPy et SciPy. Pour les spécialistes, elle comprend notamment des fonctions de classification, régression et clustering. Elle fait un tabac dans le monde de l’apprentissage automatique. Nous avons rencontré

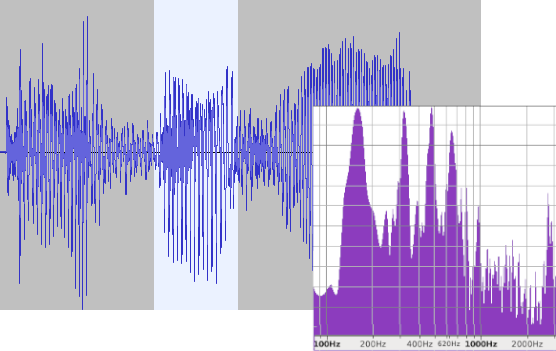

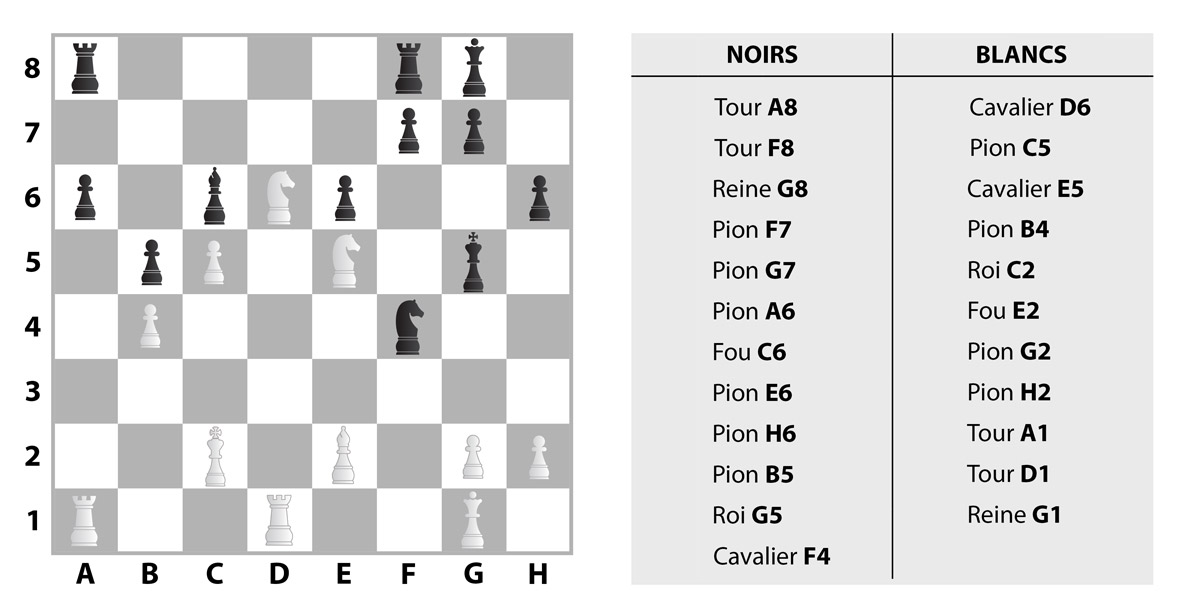

Oui, binaire s’adresse aussi aux jeunes de tous âges, que les sciences informatiques laissent parfois perplexes. Avec « Petit binaire », osons ici expliquer de manière simple et accessible, comment modéliser informatiquement la… créativité. Marie-Agnès Enard, Pascal Guitton et Thierry Viéville.

Oui, binaire s’adresse aussi aux jeunes de tous âges, que les sciences informatiques laissent parfois perplexes. Avec « Petit binaire », osons ici expliquer de manière simple et accessible, comment modéliser informatiquement la… créativité. Marie-Agnès Enard, Pascal Guitton et Thierry Viéville.