Parlons de la découverte de la robotique à l’école primaire, quand la recherche se met au service de l’éducation. Didier Roy est un professeur de mathématiques du XXIe siècle. Il enseigne les sciences du numérique. Accueilli comme chercheur en optimisation et personnalisation des apprentissages au sein d’une équipe de recherche en robotique d’Inria Bordeaux Sud-Ouest, Flowers, son travail* fait de la robotique un outil d’éveil scientifique.

Entrez avec nous dans la salle de classe.

Nous sommes un mardi. Il est 15h45. Cet après-midi de printemps est radieux. Il doit être génial de jouer dehors. Pourtant, Lola, Safina et Oscar n’ont pas l’intention de sortir tout de suite de la salle de classe.

Posé sur la table devant eux, un étrange objet** fait d’étranges choses. Il avance, tourne à gauche, à droite, recule, jette des éclairs de lumière verte, bleue ou rouge, émet des petits sons graves ou aigus, court ou longs.

« C’est n’importe quoi », pense Oscar. Quarante secondes plus tard, il se demande s’il n’y a pas quelque chose à comprendre là-dedans. D’accord, mais quoi ? Au bout de 10 minutes, la petite équipe perce une première épaisseur de mystère : en appuyant sur les boutons on peut changer ce que fait le machin sur la table, on peut choisir son comportement.

« C’est n’importe quoi », pense Oscar. Quarante secondes plus tard, il se demande s’il n’y a pas quelque chose à comprendre là-dedans. D’accord, mais quoi ? Au bout de 10 minutes, la petite équipe perce une première épaisseur de mystère : en appuyant sur les boutons on peut changer ce que fait le machin sur la table, on peut choisir son comportement.

Quand il émet une couleur verte, il a aussi tendance à suivre un objet qui est devant lui, à être « amical ». « D’accord pour amical. On pourrait même dire collant ! » remarque Safina.

Quand la couleur est rouge, impossible de l’approcher, il fuit sans arrêt. Ça doit être le mode « trouillard » dit Lola en rigolant.

Pour le comportement bleu, c’est plus compliqué. On a beau avoir 8 ans, on ne sait pas tout.

— Peut-être qu’il faut lui chanter quelque chose ? avance Safina.

— Ou lui dire un mot spécial, ou lui tirer la langue ! répond Oscar en faisant des gestes. Comment on peut savoir ?

— Ben, en réfléchissant et en essayant, à mon avis. Faisons une liste de ce qu’on pense, dit Lola.

Les voilà d’accord. Une liste des catégories de choses à tester est commencée. La méthode prend forme, ils commencent à tester des mots, puis des gestes, mais le champ des possibilités est tellement vaste… Ils cherchent d’autres pistes, si possible offrant moins d’aléatoire. Il leur semble avoir (presque) tout essayé quand Safina se rappelle qu’on leur a aussi donné des trucs en même temps que le machin. Des cubes, des petites quilles et une feuille avec une espèce de circuit tracé en noir. Elle pose le robot sur le circuit. Et là, devant leurs yeux écarquillés, le machin se met à suivre la ligne noire en se balançant tout au long, comme un chien qui suit une piste le museau collé au sol. « Trop fort, le machin ! »

Il faut maintenant franchir le deuxième cercle de mystère. Comment fonctionnent les comportements ? Par exemple, l’« amical ». Les enfants tombent d’accord en moins de deux minutes. Sur le devant du machin se trouvent comme de toutes petites fenêtres, qui détectent s’il y a un objet. S’il y en a un, il avance, s’il n’y a en a pas, il ne fait rien.

Ça marche avec toutes les fenêtres ou pas ? Avec des objets différents ? Afin d’en savoir plus, on discute et s’accorde sur une série de tests à faire, un seul doigt devant une seule fenêtre, deux doigts devant deux fenêtres… À l’issue de l’expérience, c’est clair : n’importe quel nombre de n’importe quels objets devant n’importe quel nombre de n’importe quelles fenêtres fait avancer le robot !

— Je le savais depuis le début, fanfaronne Oscar.

— Peut-être bien que t’es trop fort mais là au moins on en est sûr que ça marche comme ça, lui rétorque Safina, légèrement agacée.

Trois quarts d’heure plus tard, après avoir réalisé les autres activités données par l’animateur, Lola, Safina et Oscar rentrent chez eux avec des choses nouvelles à raconter à la maison. On leur a donné un machin dont ils ont essayé de comprendre le fonctionnement. Pour eux, c’est maintenant clair : dans le machin, il y a des capteurs qui permettent de détecter des choses, un petit ordinateur pour décider quoi en faire et des actionneurs pour faire ce qui a été décidé : rouler, tourner, faire de la lumière, faire du bruit.

Ah ! Le machin ? il s’appelle un « robot ». Et son petit nom est Thymio 2.

— Moi, quand je serai grande, je veux être roboticienne, c’est sûr ! lance Lola à ses parents, surpris de cet intérêt soudain pour les sciences.

Vivement mardi prochain : on va apprendre à faire des programmes pour le robot !

Quels sont les objectifs d’un tel enseignement de la robotique ?

La robotique propose un micro-monde d’apprentissage, intégré, coopératif, motivant, ludique et riche. On y aborde naturellement une démarche scientifique en identifiant et définissant des problèmes, en formulant des hypothèses, en expérimentant, en analysant, en argumentant.

La robotique s’inscrit dans le champ des sciences du numérique et de l’informatique, domaine essentiel pour des jeunes habiles avec les objets numériques qui leur sont familiers mais ayant également besoin de s’approprier des concepts qu’ils ne connaissent pas encore, afin de les dominer pour en tirer le meilleur.

Contribuer à la promotion et à la démocratisation de ces sciences est par ailleurs fondamental, pour plus tard, quand ils devront vivre dans un monde où l’innovation prend une importance croissante dans l’activité économique, et dans le développement humain.

On peut résumer ces objectifs dans cette table :

| Objectifs éducatifs |

Objectifs institutionnels |

|

|

L’évaluation de ces objectifs est un enjeu crucial, que nous ne développerons pas ici. Décrivons simplement les outils que nous utilisons, pour donner un aperçu de ce volet du travail qui prend aussi la forme d’un travail de recherche en didactique de l’informatique :

| Une évaluation des compétences des élèves |

|

| Une évaluation de l’enseignement |

|

Conclusion : un levier pour l’égalité des chances.

L’initiation à la robotique contribue à la lutte contre l’échec scolaire. Elle suscite une pédagogie de projet, change le cadre d’enseignement en le rendant plus souple, moins stigmatisant, particulièrement pour les élèves en difficulté. Sa démarche de recherche active, son ouverture au débat, sont autant d’atouts pour faciliter l’expression d’élèves en rupture d’un cadre scolaire traditionnel et qui leur est mal adapté.

La robotique n’est pas la seule à proposer un cadre facilitateur de progrès mais celui-ci y trouve là facilement sa place, par la nature même des activités proposées.

Nous observons une appétence de la part des jeunes filles pour la robotique. Une porte d’entrée supplémentaire vers les sciences, particulièrement du numérique, domaine où on les voit peu à peu prendre leur place (46 % des participants au concours Castor Informatique et plus de la moitié des lycéen-ne-s inscrit-e-s en spécialité Informatique et Sciences du Numérique (ISN) de Terminale S sont des filles). Une tendance à conforter.

À travers la robotique, il est légitime de travailler différentes disciplines, notamment le français et les maths, disciplines qui prennent tout leur sens pour exprimer ou comprendre. L’aspect tangible est également un atout pour amplifier ce sens. Et la composante ludique, facteur de plaisir d’apprendre, ne fait que renforcer une autre vision de l’apprentissage, moins rigide et davantage portée vers la valorisation des individus en situation de recherche.

Cet enseignement de la robotique, et plus largement de l’informatique, est devenu indispensable dans une société où le numérique est à la fois si présent et si peu compris, où la technologie sépare les humains en deux catégories ; celles et ceux qui l’utilisent en en connaissant les bénéfices mais également les pièges, qui saisissent les fondements essentiels de la pensée informatique. Et les autres. La première catégorie doit croître aussi rapidement qu’il est possible, pour assurer un usage maîtrisé et sécurisé des technologies du numérique, si l’on veut veiller à ce que personne ne soit mis de côté et encore moins esclave d’un monde qu’il ne comprendrait plus.

Didier Roy.

(*) Le module est en cours de finalisation (disponible sous forme open source à la mi-juin). Rendez-vous sur le site dédié à la médiation de la robotique, « Dessine-moi un robot ».

(**) Le thymio-2, créé par l’EPFL, est un formidable robot pour l’éducation (en savoir plus).

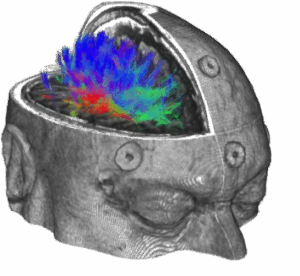

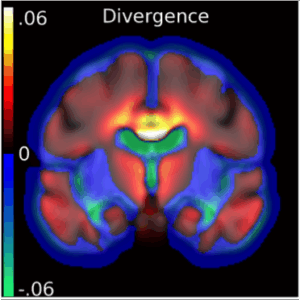

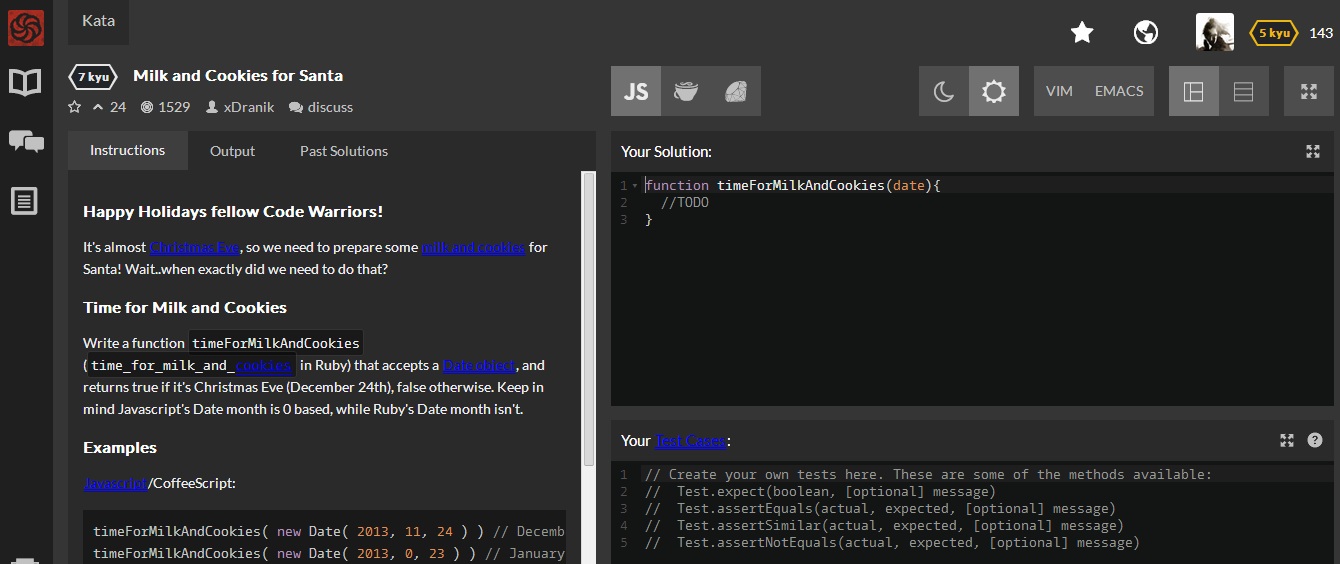

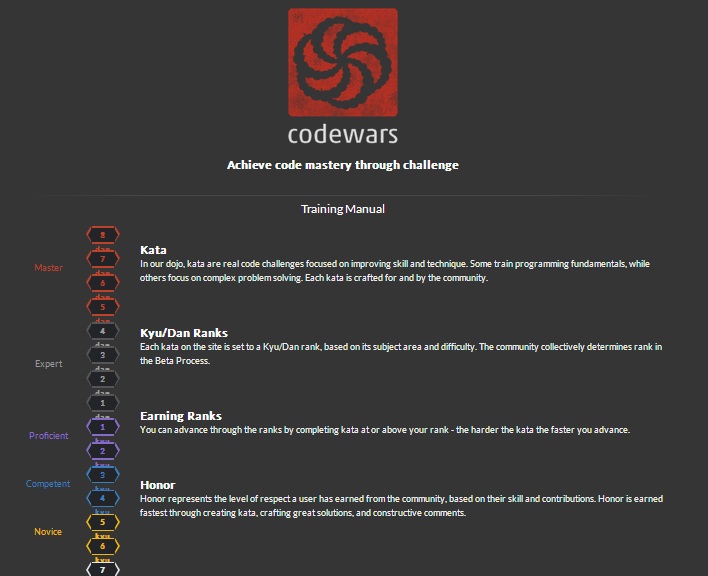

Pour célébrer la publication des ebooks « The Art of Computer Programming (TAOCP) » (L’Art de la programmation informatique),

Pour célébrer la publication des ebooks « The Art of Computer Programming (TAOCP) » (L’Art de la programmation informatique),

passionnés, curieuse de cultures numériques et de productions artistiques, je découvre l’annonce sur la Toile de DI2014. J’épluche consciencieusement le

passionnés, curieuse de cultures numériques et de productions artistiques, je découvre l’annonce sur la Toile de DI2014. J’épluche consciencieusement le