Binaire : peux-tu raconter aux lecteurs de binaire ton parcours ?

Sébastien Soriano : Je suis ingénieur des télécoms. J’ai travaillé dans des cabinets ministériels notamment sur la mise en place de la French Tech et du plan France Très Haut Débit. Et puis j’ai passé une partie de ma vie à travailler sur la concurrence, en particulier dans le domaine des télécoms comme Président de l’Arcep. Je me suis aussi investi sur l’Europe, comme président de l’agence européenne des télécoms, le BEREC. Enfin, j’ai écrit récemment un livre sur le service public[1], dont l’idée principale est assez simple : Il faut penser un « État augmenté ». Il faut sortir du débat dominant : faire comme avant mais avec plus de moyen pour l’État, ou de réduire le rôle de l’État en abandonnant certaines de ses responsabilités au privé. Je prône plutôt ce que j’ai appelé l’« État en réseau », un État qui construit des alliances avec des acteurs, collectivités locales, associations, collectifs citoyens, entreprises…, pour augmenter son impact et relever les nouveaux défis, en particulier écologiques.

Cette réflexion m’a conduit à approfondir la notion de commun. A l’Arcep, j’avais poussé l’idée de voir les réseaux comme « biens communs », au service de tous. Cela m’a pris un peu de temps de comprendre qu’ils devaient être plus que cela, véritablement devenir des « communs » au sens où ils devaient être codéployés par une galaxie d’acteurs plus large que quelques grandes entreprises privées. C’est apparu clairement avec la 5G. Il est devenu évident qu’une large partie de la société devait être impliquée dans son déploiement, qu’elle devait être associée à l’action au-delà d’un simple rôle de spectateur.

b : Quelle est la place de l’Open data à l’IGN ?

SSo : L’IGN, qui a une forte culture d’innovation, s’est bien informatisé avec l’arrivée des systèmes d’information géographiques. Si cette transformation avec l’informatique a été réussie, l’IGN a moins bien abordé sa transformation numérique. Quand vous avez vos données gratuites, vous augmentez vos capacités d’alliance. Le précédent modèle économique de l’IGN a fait de l’institut un « spectateur » de l’arrivée des modèles gratuits, de Google Maps, Google Earth, OpenStreetMap, etc.

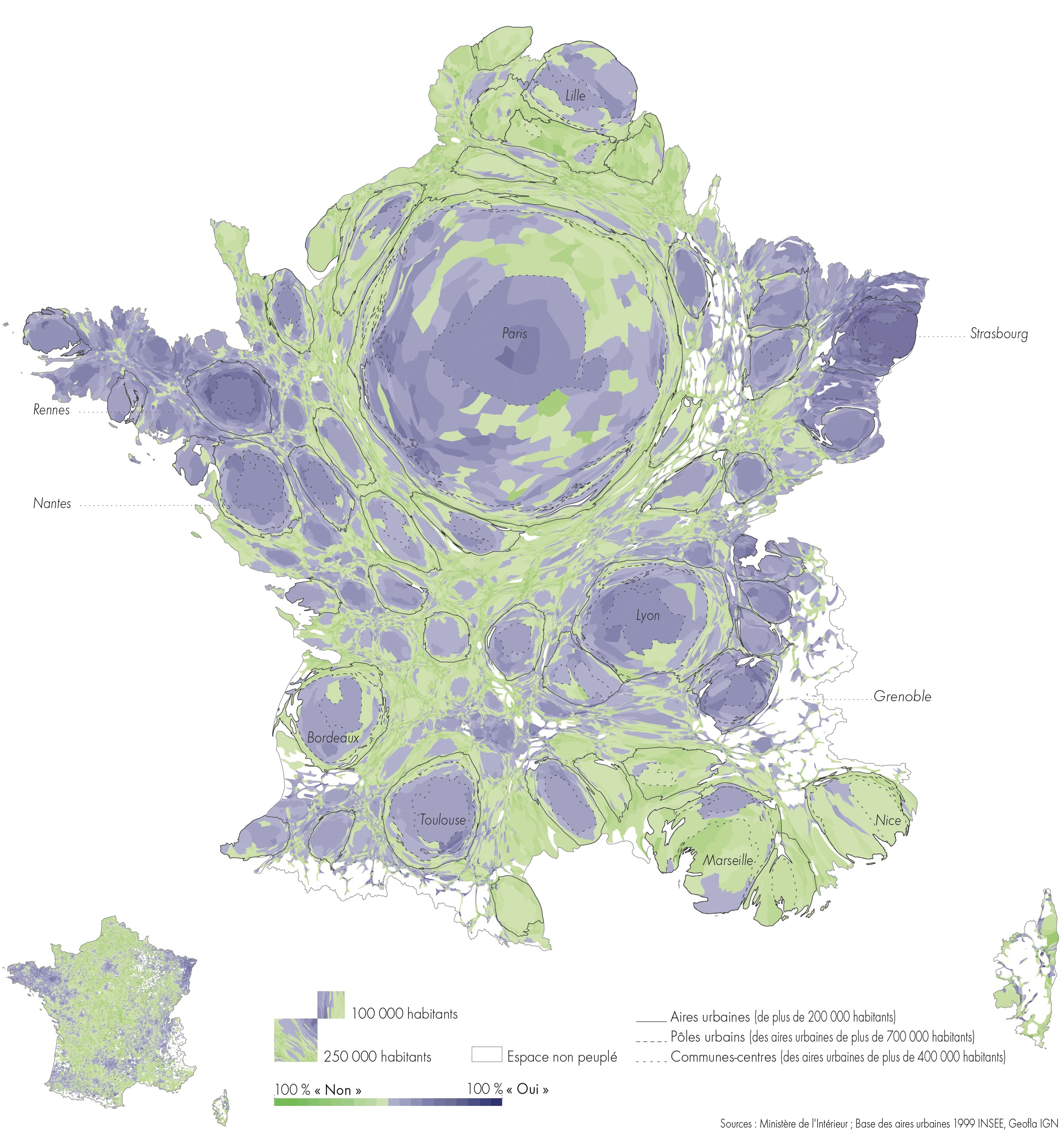

Pour la cartographie, un autre mouvement s’est combiné à cela en France. La Loi NOTRe, portant sur la nouvelle organisation territoriale de la République, reconnait depuis 2015 la place des régions pour coordonner l’information géographique au niveau local. Certaines collectivités ont maintenant de véritables « petits IGN » qui collectent des données, les analysent, les utilisent au service des politiques locales, souvent de manière très innovante.

Pour ce qui est de l’IGN, l’institut a été pris dans un mouvement général du public dans les années 80-90 qui conduisait à monétiser ses données. La puissance publique demandait aux établissements de diversifier leurs sources de revenus, comme les musées l’ont fait, par exemple. Cela a freiné la capacité d’ouverture de l’IGN. Du coup, l’ouverture s’est faite très progressivement.

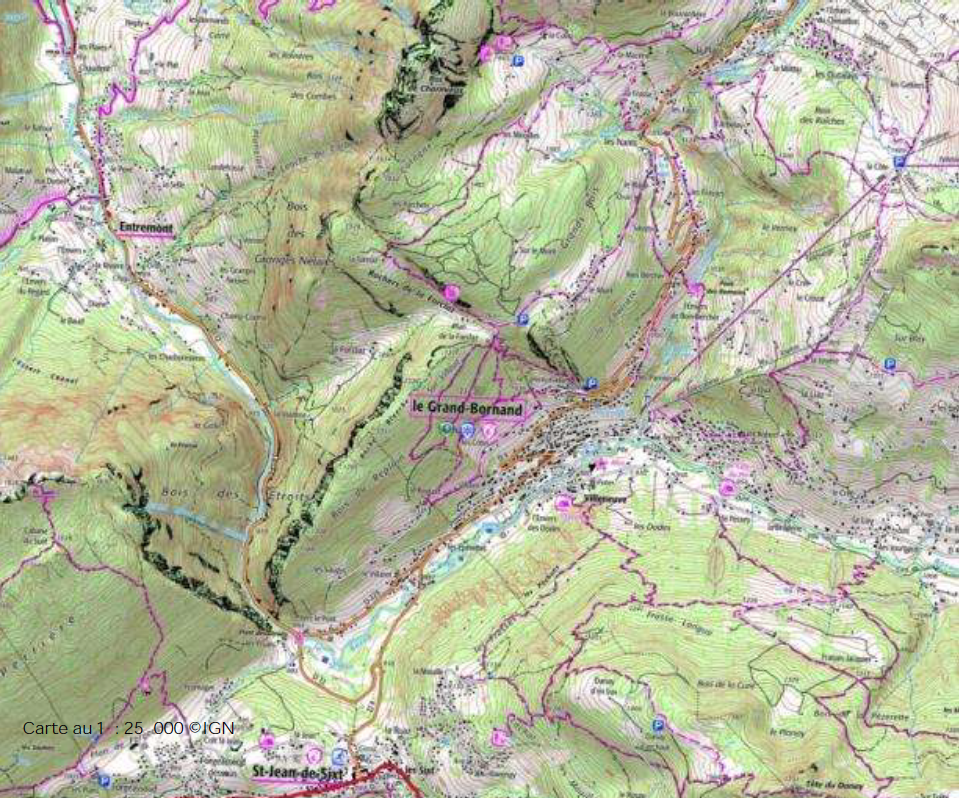

A partir de 2010, les données sont devenues gratuites pour l’éducation et la recherche puis progressivement pour toutes les missions de services publics. En 2015, la loi Lemaire a généralisé cette gratuité à tous les organismes publics. Depuis le 1er janvier 2021, toutes les données de l’IGN sont ouvertes, en anticipant d’un an sur le calendrier prévu. Seule la carte au 1 : 25 000, bien que gratuitement accessible en ligne, reste encadrée quant à sa réutilisation pour les usages grand public.

Il faut voir que tout cela a conduit l’IGN à un profond changement de modèle économique, et aussi un changement de culture. L’institut n’est plus porté aujourd’hui que pour 10% de son budget par la vente de cartes ou de prestations commerciales. Ensuite, 45% correspondent à la SCSP – la subvention pour charge de service public. Il nous faut aller chercher les autres 45% sur des financements de projets publics de différents ministères. Nous sommes au service de la puissance publique. Mais on ne nous fait pas un chèque en blanc. Nous devons en permanence convaincre de l’utilité de ce que nous faisons.

b : Peux-tu maintenant nous parler du futur ?

SSo : Nous avons défini une nouvelle stratégie, « les géocommuns ». Et en fait, c’est une démarche plus qu’une stratégie.

L’IGN est un miroir tendu au territoire national pour se regarder et pour se comprendre. On doit bien-sûr poser la question : quelle est l’intention de ce miroir ?

À une époque, les cartes étaient d’abord conçues dans des buts guerriers. Puis l’IGN, lancé dans les années 40, a accompagné l’aménagement du pays et sa reconstruction. Il nous faut aujourd’hui nous replacer dans deux grands bouleversements de nos sociétés : l’anthropocène, une transformation rapide, et la révolution numérique. Notre but est d’apporter à la nation des informations qui lui permettent de maitriser son destin dans ce double mouvement. Notre méthode, c’est de faire cela avec les autres services publics et en travaillant avec tous ceux qui veulent contribuer, par exemple avec des communautés comme OpenStreetMap.

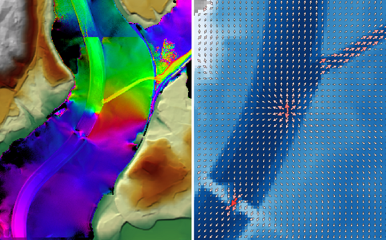

Réaliser une cartographie de l’anthropocène est un objectif ambitieux. Pour cela, il faut savoir mettre en évidence les transformations rapides voire brutales, et l’évolution de la planète. La carte au 1 : 25 000 décrit le territoire de manière statique. Nous devons décrire désormais des phénomènes comme la propagation hyper rapide de maladies forestières. Si cela prend 25 ans, on risque de ne plus avoir de forêt à l’arrivée. Alors, on croise des sources, on s’appuie sur le monde académique, on utilise l’intelligence artificielle.

sur la « BD TOPO », Site Web IGN, 2021

b : Pourrais-tu nous expliquer ce qu’est pour toi un commun ?

SSo : La notion fondamentale est à mon sens la coproduction. Un commun, c’est une ressource, par exemple un ensemble de données, qui est coproduit. L’idée est de construire des communautés ad hoc suivant le sujet pour produire cette ressource ensemble. La gouvernance de la communauté est un aspect essentiel de la notion de commun.

Pour certains, les communs doivent nécessairement être ouverts et gratuits, mais cela n’est pas forcément intrinsèque selon moi. De manière générale, il faut avoir une approche pragmatique. Si on est trop puriste sur l’idée de communs, il ne reste que les ZAD et Wikipédia. Bien sûr, dans l’autre direction, on voit le risque de commons washing. Selon moi, par exemple, une règle importante pour pouvoir parler de commun, c’est que la porte reste ouverte, que cela ne puisse pas être un club fermé. Tout le monde a droit d’entrer ou de sortir de la production. La gouvernance doit permettre d’éviter que le commun soit accaparé par quelques-uns.

Je peux prendre un bel exemple qui illustre ces principes. Dans le cadre de la « Fabrique des géocommuns » que nous mettons en place, nous ouvrons un chapitre sur un service du style street view, une vue immersive, le petit bonhomme jaune de Google. Pour faire cela, Google fait circuler des véhicules dans toutes la France avec des capteurs. Nous n’avons pas les moyens de faire cela. Alors, nous allons chercher des partenaires, lancer un appel à tous ceux qui ont envie de faire cela avec nous et qui ont parfois déjà des données à mettre en commun. On va se mettre d’accord sur une gouvernance pour définir le régime d’accès aux données. En particulier, il faut choisir la licence : la licence Etalab 2.0 que l’IGN utilise pour le moment (une licence inconditionnelle) ou la licence ODbL utilisée par OpenStreetMap par exemple, qui spécifie que celui qui utilise les données doit accepter de partager ce qu’il en fait de la même façon.

Qui va répondre ? On espère pouvoir compter sur OpenStreetMap. La communauté existe déjà, on n’a pas de raison d’en créer une nouvelle. Ils sont capables de se réunir à une dizaine de personnes pendant un weekend pour « faire » un arrondissement de Paris. Pas nous ! Mais nous espérons aussi attirer des entreprises qui travaillent pour des collectivités et ont déjà des mines de photos. Certains ont donné un accord de principe pour les mettre en commun.

Il ne faut pas voir de concurrence entre ces mondes. Les données cartographiques en accès ouvert viennent massivement de données publiques. Les fonds de carte sur OpenStreetMap proviennent pour beaucoup de sources publiques. La foule est utile pour apporter des données complémentaires, qui ne sont pas dans ces données publiques.

Après l’ouverture des données IGN au 1er janvier 2021, l’ambition est aujourd’hui de co-construire les référentiels de données, les services et les outils d’une information géographique au service de l’intérêt général. Avec les citoyens et pour les citoyens, avec les territoires et pour les territoires, c’est ça les géo-communs ! (Site web de l’IGN, 2021)

b : Qu’est-ce qui se passe au niveau international pour les données cartographiques ?

SSo : Cela bouge lentement. Les Suisses ont mis leurs données cartographiques en données ouvertes. Le cas des États-Unis est intéressant. La loi états-unienne ne permet pas de vendre des données publiques à des citoyens, parce que ceux-ci ont déjà payé en quelque sorte pour les construire, en payant leur impôt.

b : Pourrais-tu nous parler maintenant du gouvernement ouvert ?

SSo : Je milite dans mon livre pour une trilogie État-Marché-Commun parce que le duo État-Marché n’arrive plus à résoudre des problèmes qui sont devenus trop complexes. Il faut raisonner dans un jeu à trois. L’État participe avec sa légitimité, sa capacité de rassembler, sa violence légitime. Le marché apporte sa capacité à mobiliser des moyens financiers, sa capacité d’innovation. La société permet de faire participer les citoyens qui sont aujourd’hui plus éduqués, ont plus de temps libre, cherchent du sens à leurs actions. Cette force sociale, on peut l’appeler les communs, même si l’utilisation de ce terme n’est qu’un raccourci.

Le numérique apporte une puissance considérable pour accélérer les coopérations, les échanges. Mais c’est à mon avis restrictif que de se limiter au seul numérique. C’est pour cela que je n’aime pas trop le terme « open gov » parce qu’il est souvent compris comme se limitant au numérique.

Prenez une initiative comme « Territoires zéro chômeurs longue durée ». Le constat de départ, c’est qu’il existe une frange de la population que, une fois écartée du marché du travail, on ne sait plus remettre sur ce marché. Il faut arriver à casser la spirale qui éloigne ces personnes du monde du travail. L’approche est de créer un tissu local qui leur trouve des emplois ; ce sont de vrais emplois pour ces personnes mais ces emplois ne sont le plus souvent pas rentables économiquement. Le rôle de l’État est de créer une tuyauterie financière, en s’appuyant sur une loi, pour réunir de l’argent qui est prévu pour cela et s’en servir pour financer en partie ces emplois. Après deux ans, ces ex-chômeurs retournent sur le marché du travail.

Le rôle de l’État est de mettre tout le monde en réseau et de faire appel à des initiatives locales. Vous voyez, on n’est pas dans le numérique, même si le numérique est un outil qui peut être utile pour aider à mettre cela en place. Je crois qu’il faut plutôt le voir comme une coproduction permise par l’État en réseau.

b : Deux questions. D’abord, on accorde selon toi trop d’importance au numérique dans la transformation de l’État.

SSo : Oui. La transformation de l’État n’est pas juste une question numérique même si, bien sûr, le numérique a une place très importante à jouer.

b : Ensuite, pour ce qui est de « Territoires zéro chômeurs longue durée », dans l’Économie Sociale et Solidaire, des initiatives semblables n’existaient-elles pas déjà avec des acteurs comme le Groupe SOS ou ATD Quart Monde ?

SSo : Bien sûr. D’ailleurs, ATD Quart Monde est au cœur de ce dispositif. Mais l’associatif n’arrivait pas seul à régler ce problème. Il fallait l’idée de transformer les allocations chômages en revenus. Seul l’État pouvait faire cela. C’est selon moi le rôle de l’État. Mettre en place le mécanisme et, peut-être, coconstruire un réseau pour arriver ensemble à résoudre le problème.

b : Un mot pour conclure ?

SSo : Un sujet qui m’interpelle est la perte de légitimité des structures d’autorités, la puissance publique mais aussi les scientifiques. Les autorités naturelles ne sont plus reconnues. Je pense qu’il est important d’aller discuter avec les communautés sur les sujets qui fâchent. En particulier, l’administration doit accepter le dialogue. On change de paradigme. L’administration descend de son piédestal pour coconstruire avec d’autres même si ce n’est pas facile. C’est une nécessité pour l’administration qui peut ainsi retrouver une certaine légitimité.

Serge Abiteboul, Inria et ENS, Paris, François Bancilhon, serial entrepreneur

Pour aller plus loin

[1] Sébastien Soriano, Un avenir pour le service public, Odile Jacob, 2020.

[2] IGN, Changer d’échelle, site web de l’IGN, 2021

https://binaire.socinfo.fr/page-les-communs-numeriques/

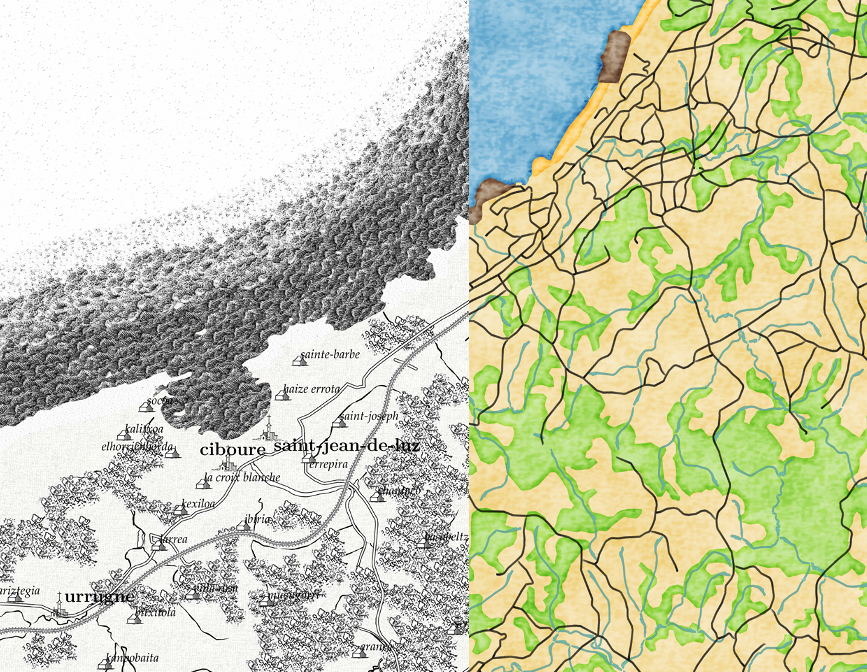

Continuum de styles topographiques (Hoarau & Christophe 2017)(1)

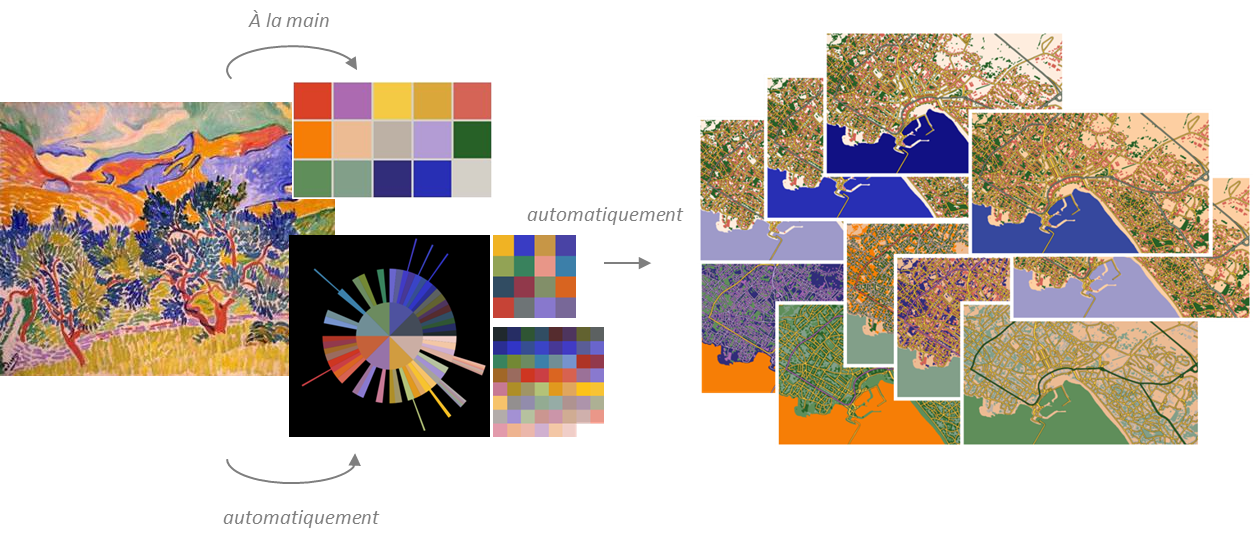

Continuum de styles topographiques (Hoarau & Christophe 2017)(1) Multiplexer des données (

Multiplexer des données (

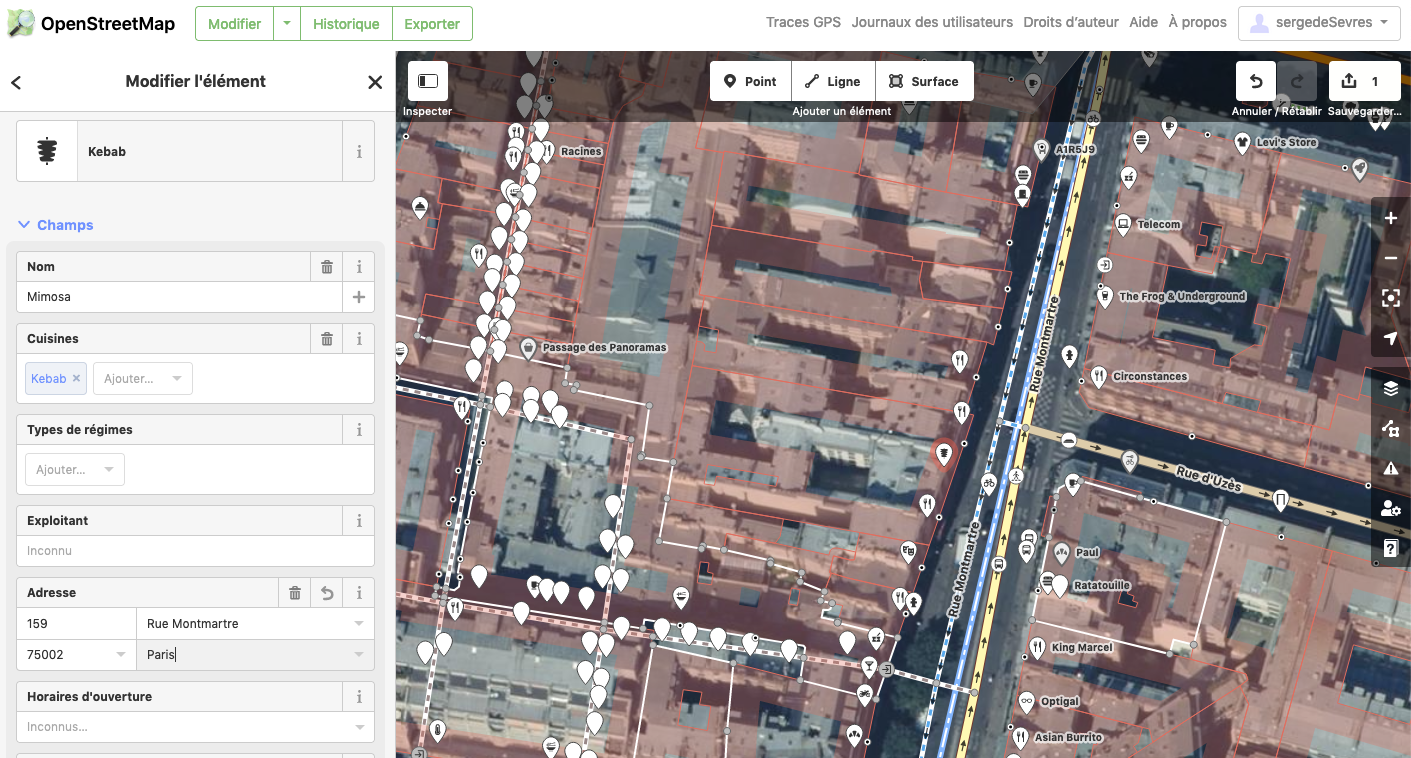

Différents points de vue d’une montée des eaux, selon les usages (

Différents points de vue d’une montée des eaux, selon les usages (

Comparaison de scénarios de montée des eaux à l’horizon 2100

Comparaison de scénarios de montée des eaux à l’horizon 2100