B : Quel est ton domaine de recherche actuel ?

JK : Je travaille à l’intersection de deux domaines, d’une part l’algorithmique, et d’autre part les réseaux sociaux et les réseaux d’information tels que le web et internet. Plus généralement je m’intéresse aux algorithmes, à leurs actions au sein de la société humaine, et à leurs applications aux problèmes de société.

B : Y a-t-il d’autres domaine de l’informatique qui interagissent avec ce domaine ?

JK : Ce domaine a des interactions fortes avec de nombreuses facettes de l’informatique. On peut citer l’apprentissage automatique, ou les systèmes distribués de grande taille. Ainsi, le modèle de calcul “Mapreduce” a été créé en partie pour gérer l’infrastructure de réseaux sociaux géants tels que Google ou Facebook. De plus, par leur nature même, ces systèmes dépendent de données sensibles, d’où l’importance de déterminer quelles informations sont révélées quand on se met à utiliser des données personnelles pour d’autres buts que ceux pour lesquels elles avaient été initialement obtenues. Cela soulève des questions dans le domaine de la sécurité et de la protection de la vie privée. Enfin, comme une part croissante de l’information se présente sous forme d’image ou de vidéo, nous avons de plus en plus d’interactions avec le domaine de la vision par ordinateur.

B : Quel est le rôle des universitaires dans cette transformation de la société par le numérique ?

JK : D’une part, de nombreux concepts introduits sur internet ces vingt dernières années sont au moins en partie le fruit de projets universitaires conduits par des enseignants-chercheurs ou des étudiants. Dans les premiers temps du domaine, la barrière technique à l’innovation était relativement basse, d’où un rôle important des universitaires. A un stade expérimental, les coûts d’introduction de nouvelles idées sont peu élevés, et cela favorise un cadre où de nombreuses personnes, à la fois motivées et techniquement talentueuses, peuvent tester des projets très divers, dans la plus grande liberté intellectuelle pour suivre les directions qui les intéressent et focaliser leur énergie sur ce qui leur semble prometteur. Le milieu universitaire est propice à cela, et les résultats ont une influence significative sur la société. Pour passer à l’échelle d’un milliard d’utilisateurs, cela devient plus coûteux, ne fût-ce qu’en termes de serveurs et de centres de données. C’est alors le rôle des entreprises de prendre le relais pour développer les idées des universitaires et en faire de grands succès financiers en les commercialisant.

D’autre part, un défi pour les universitaires informaticiens actuellement est de chercher des partenariats avec les disciplines qui ont déjà une tradition établie d’étude de ce type de questions, par exemple la sociologie ou l’économie. À la frontière avec l’informatique, il existe un terrain très prometteur de flux d’idées dans les deux sens.

Dans un sens, on voit que quand on développe une plate-forme telle que Twitter, penser aux aspects techniques ne suffit pas ; il est indispensable de réfléchir aussi à ce qui se passe lorsqu’un nombre important de personnes se mettent à utiliser cette plate-forme, ainsi qu’aux conséquences économiques, qu’elles soient fortuites ou intentionnelles.

Dans l’autre sens, j’aime à croire que les spécialistes de ces disciplines ont des choses à apprendre de nous. En sociologie en particulier, traditionnellement l’acquisition de données sur le fonctionnement des groupes de personnes est une difficulté majeure du domaine, parce que cela requiert des observations, et donc des interactions de personne à personne. Désormais, avec Facebook par exemple, on a accès à des interactions extrêmement riches, à un niveau de détail extrême, et à grande échelle. Pour étudier un problème de sociologie, l’analyse des données de Facebook à beaucoup à enseigner sur les interactions entre les individus, même si on ne comprend pas vraiment ce que chaque interaction signifie. Comment reprendre les questions sophistiquées traditionnellement posées par des sociologues à un petit nombre d’individus, et les faire passer à l’échelle des données sur internet ?

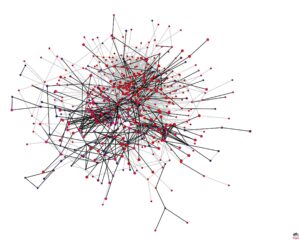

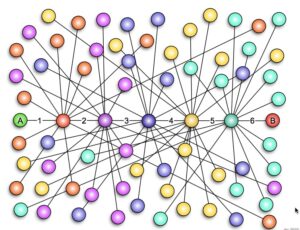

Un exemple d’un tel travail : le phénomène de petit monde dans les graphes. Considérons la question des degrés de séparation qui nous séparent les uns des autres. « Les six degrés de séparation » est une propriété suggérée par le Hongrois Frigyes Karithy dans une de ces nouvelles datée de 1929 qui évoque la possibilité que toute personne sur le globe puisse être reliée à n’importe quelle autre, au travers d’une chaîne de relations individuelles comprenant au plus six maillons. Il est plus facile de raisonner sur ce problème de façon qualitative que quantitative, ce qui peut expliquer pourquoi ce thème a d’abord fait surface dans la fiction. Puis, dans les années 60, Stanley Milgram, qui avait un talent pour la conception d’expériences en sciences sociales pour tester des phénomènes dont tout le monde avait une compréhension intuitive mais qu’on ne savait pas formaliser, a conçu la célèbre expérience “six degrés de séparation” étudiant le cheminement de lettres jusqu’à leurs destinataires. C’est là un bon exemple d’un travail expérimental qui était très difficile à faire avant internet. Il découvrit que la médiane du nombre d’étapes dans le chemin était de six, ce qui, grâce à l’auteur de pièce de théâtre John Guare, est devenu connu sous le nom de “six degrés de séparation”. Deuxième apparition de travail de fiction dans l’histoire de ce problème, car c’est sa pièce de théâtre, puis le film qui en a été tiré, qui ont popularisé ce phénomène.

Plus tard, dans le domaine des mathématiques, Watts et Storgetz ont proposé un modèle de graphe aléatoire, et c’est par leur travaux que j’ai été amené à m’intéresser au problème. Je souhaitais particulièrement l’étudier du point de vue algorithmique, auquel les gens n’avaient pas prêté attention jusqu’alors. En fait, l’expérience de Milgram a montré deux propriétés distinctes : premièrement, qu’il existait des chemins très courts entre la plupart des paires de points dans un graphe aléatoire ; et deuxièmement, que les gens étaient capables de découvrir ces chemins. Notons que Milgram n’aurait jamais découvert cette deuxième propriété s’il avait simplement eu accès à des données massives et à de puissants outils de calcul : il lui aurait suffi de faire un calcul de plus courts chemins, court-circuitant la deuxième propriété. Parfois, le manque de ressources nous oblige à faire des études plus intéressantes que ce à quoi on aurait pensé sinon ! Enfin, depuis 2005 ou 2006, l’explosion soudaine des réseaux sociaux a permis d’étudier les données qui ont alors émergé et de vérifier certaines des prédictions précédentes.

B : Comment t’es-tu retrouvé à faire de l’informatique ?

JK : Enfant, j’aimais les maths. Jeune adolescent au moment de l’arrivée de l’ordinateur personnel Apple 2, j’écrivais des programmes de jeux que je partageais avec mes amis du collège, et étais toujours à la recherche d’idées de jeux qui intéresseraient mes amis. Cette découverte de l’informatique par la programmation des ordinateurs personnels est typique de ma génération. La discipline scientifique informatique était déjà bien développée, mais nous n’en étions pas conscients. Pour les générations antérieures, les ordinateurs étaient peu accessibles ; pour les suivantes, il est devenu évident que l’informatique était une discipline. Étudiant, j’étais parti pour étudier les maths, mais j’ai suivi en première année de licence un cours d’introduction à l’informatique. Je me suis alors rendu compte qu’il était possible de marier mes deux intérêts, les maths et la programmation. C’était passionnant de découvrir le raisonnement mathématique appliqué à la programmation, et l’informatique était un sujet que je pouvais étudier sans être pour autant obligé d’abandonner les maths.

B : Ton domaine de recherche actuel existait-il alors ?

JK : On peut toujours mentionner des articles isolés, mais en tant que domaine de recherche identifié comme objet d’étude, cela n’est apparu que lorsque j’étais en doctorat. Le catalyseur a été l’adoption massive du web par le grand public, entre 1993 et 1997. Le web s’est transformé, d’une simple application pour partager des fichiers sur internet, en quelque chose que tout un chacun utilisait quotidiennement. Les informaticiens se sont alors rendu compte qu’il ne suffisait plus, comme auparavant, de construire des systèmes d’exploitation, des compilateurs, et des raisonnements logiques pour les analyser, mais que désormais il était indispensable de prendre en compte le comportement des millions d’utilisateurs sans lesquels le web lui-même n’existerait pas.

B : Quels en ont été les conséquences en dehors de l’informatique ?

JK : Bien évidemment, il y a eu des changements dans la vie quotidienne, dont sont conscients tous ceux qui ont vécu les années 90. Nous avons désormais des outils qui nous permettent, dès qu’on a une question factuelle, d’obtenir la réponse quasi immédiatement. Cela nous semble maintenant normal, mais ça n’existait pas dans les années 80. Deuxième conséquence, alors qu’autrefois seules quelques personnes avaient la responsabilité de produire et partager l’information dans des médias traditionnels, désormais ce sont des centaines de millions de personnes qui produisent et partagent l’information. Du coup, chacun doit désormais adopter une démarche similaire à celle de la recherche académique, en évaluant l’information, en comparant des sources différentes sur un même sujet, en tenant compte des objectifs probables et des biais potentiels de ceux qui ont écrit l’information. Par exemple, allez sur internet et recherchez combien de temps des restes de poulet peuvent se garder dans un réfrigérateur. La diversité des réponses est phénoménale. On peut trouver un blog avec une opinion très tranchée sur la question, mais on ne sait pas si l’auteur est crédible, une page sur le site d’une entreprise d’agro-alimentaire, mais on ne sait pas si on peut leur faire confiance, une page sur le site du ministère de la santé, mais on ne sait pas exactement d’où ça sort. Ainsi, toutes ces sources prétendent une expertise qu’on n’a pas moyen d’évaluer, ils tentent tous de répondre à la même question, et les résultats sont tous différents. Ce genre de choses, on le voit tous les jours.

JK : Bien évidemment, il y a eu des changements dans la vie quotidienne, dont sont conscients tous ceux qui ont vécu les années 90. Nous avons désormais des outils qui nous permettent, dès qu’on a une question factuelle, d’obtenir la réponse quasi immédiatement. Cela nous semble maintenant normal, mais ça n’existait pas dans les années 80. Deuxième conséquence, alors qu’autrefois seules quelques personnes avaient la responsabilité de produire et partager l’information dans des médias traditionnels, désormais ce sont des centaines de millions de personnes qui produisent et partagent l’information. Du coup, chacun doit désormais adopter une démarche similaire à celle de la recherche académique, en évaluant l’information, en comparant des sources différentes sur un même sujet, en tenant compte des objectifs probables et des biais potentiels de ceux qui ont écrit l’information. Par exemple, allez sur internet et recherchez combien de temps des restes de poulet peuvent se garder dans un réfrigérateur. La diversité des réponses est phénoménale. On peut trouver un blog avec une opinion très tranchée sur la question, mais on ne sait pas si l’auteur est crédible, une page sur le site d’une entreprise d’agro-alimentaire, mais on ne sait pas si on peut leur faire confiance, une page sur le site du ministère de la santé, mais on ne sait pas exactement d’où ça sort. Ainsi, toutes ces sources prétendent une expertise qu’on n’a pas moyen d’évaluer, ils tentent tous de répondre à la même question, et les résultats sont tous différents. Ce genre de choses, on le voit tous les jours.

Historiquement, les choses ont commencé à changer dans les années 90, quand les gens ont commencé à mettre des informations sur le web ; ça s’est accéléré avec Wikipédia, puis, entre 2004 et 2006, le monde de l’information a changé. Les grandes plateformes que nous utilisons maintenant, Facebook, Twitter, YouTube, sont toutes apparues au cours de cette période très brève. Il y a eu une convergence de progrès technologiques qui ont facilité l’accès à internet pour y mettre des informations de façon collaborative, et les gens se sont mis à sortir de derrière l’écran de leurs pages web et à interagir plus directement les uns avec les autres. Dans les années 90, même après la démocratisation du web, il s’agissait fondamentalement encore de lecture de documents, alors que depuis 2006, il s’agit plus d’interaction avec des personnes. Cela a modifié les attentes. Maintenant, s’il se passe quelque chose quelque part dans le monde, je me connecte à un réseau social, et j’ai immédiatement accès aux réactions de dizaines de milliers de gens. Dès qu’il arrive quelque chose, un désastre naturel par exemple, on va tout naturellement sur Twitter et on voit les réactions en temps réel. Les mêmes questions se posent alors : ces informations sont-elles crédibles ? Adopter la démarche de la recherche académique traditionnelle ne suffit plus, car il s’agit maintenant de discerner la vérité à partir de centaines de milliers de minuscules fragments de réactions. C’est encore plus compliqué !

Souvent, on compare la période présente à la constellation d’activités nouvelles aux début du 16e siècle (dont la création du Collège de France) liées à la démocratisation de l’information. L’ensemble des personnes qui avaient accès à l’information s’est élargi, et le type d’informations auxquelles ils avaient accès s’est considérablement élargi. Il y a eu une combinaison de facteurs comme la diffusion de l’imprimerie, la diminution de l’analphabétisme, ou le changement dans l’organisation du système éducatif. Tout cela a modifié les conditions de création et dissémination de l’information. Incorporer ces changements a été un défi pour la société de l’époque ! Il me semble que nous sommes maintenant confrontés à un défi analogue.

B : Le prix MacArthur que tu as reçu a-t’il eu un impact significatif sur ta carrière ?

JK : J’ai obtenu ce prix en 2005, juste au moment de la soudaine émergence de très grands réseaux sociaux. Auparavant, j’avais travaillé sur la conception et l’analyse d’algorithmes de recherche sur le web, et il semblait que ces grands réseaux sociaux posaient des questions importantes, mais difficiles à formaliser puisqu’il s’agissait de s’aventurer dans le monde extérieur à l’informatique. Le prix MacArthur m’a donné une impulsion pour travailler à définir une direction de recherche qui ait à voir avec ces nouveaux développements, et à penser aux conseils à donner aux étudiants débutants. Ainsi, parmi les étudiants que nous avons formés, on peut citer Haggstrom, qui a rejoint Facebook en 2009, et qui est maintenant vice-président de l’ingénierie responsable du classement des articles : d’une certaine manière, on peut tracer un chemin allant du prix MacArthur jusqu’à ces développements.

B : As-tu des regrets ?

JK : J’ai eu beaucoup, beaucoup de chance avec mes collaborateurs et avec nos sujets d’étude. J’ai appris de mes mentors, de mes collaborateurs, de mes étudiants, et c’est extraordinaire que de faire ainsi partie d’une communauté scientifique. Si je devais avoir un regret, ce serait celui des occasions manquées, lorsque j’ai hésité à me lancer sur un nouveau sujet, parce que je craignais que le sujet ne soit pas assez mûr, trop mal défini, pas assez sérieux. Je n’ai jamais regretté de m’être lancé trop tôt sur quelque chose.

B : Comment imagines-tu l’avenir de ton domaine ?

JK : Un problème important du domaine est de comprendre comment ces systèmes influencent le comportement de ces individus. Quand on regarde Facebook, on a tendance à s’imaginer qu’on contemple le comportement d’êtres humains dans leur état naturel, mais en réalité, il y a des algorithmes sous-jacents qui régulent leurs interactions. Ainsi, les résultats des recherches sur Google orientent les choix ultérieurs, et les articles qu’on consulte sur Facebook dépendent de ceux qu’on voit, et cela est déterminé par des algorithmes. Dans de telles situations, on n’a actuellement aucune notion de l’impact des décisions de conception d’algorithme sur les utilisateurs de la plate-forme. C’est un problème grand ouvert, et rendu plus compliqué encore par la boucle de rétroaction. Par exemple, en ce qui concerne les habitudes des consommateurs, l’algorithme de recommandations est entraîné à partir des décisions passées des consommateurs, mais bien évidemment les décisions ultérieures des consommateurs sont à leur tour influencées par ce que l’algorithme décide de leur montrer, et il y a ainsi une boucle infinie de rétroaction, où les décisions de l’algorithme dépendent des décisions des utilisateurs, et vice-versa. Avec ce type de boucles de rétroaction, nous ne comprenons pas vraiment ce que font nos algorithmes, et ce phénomène est présent partout dans le monde de l’internet, qui lui-même interagit avec le monde réel.

Plus largement, ceci conduit au deuxième domaine où nous avons un besoin urgent de travaux de recherche : le rôle des algorithmes dans les décisions de nature politique, de protocole ou de règlementation. Des experts ou groupes d’experts prennent des décisions qui ont des conséquences sur la vie des personnes ordinaires, par exemple liées à l’embauche, à la justice, ou à la médecine avec des recommandations de traitements. Ces décisions ont des conséquences significatives sur la vie d’individus. Il y a probablement là une place pour des algorithmes qui pourraient aider à réduire le nombre de décisions erronées, mais c’est là un grand défi.

B : Quelle formation envisages-tu pour les informaticiens de demain ?

JK : À l’université de Cornell, nous tentons d’incorporer à notre enseignement dans notre formation d’ingénieur des concepts issus d’autres disciplines. Par exemple, pour concevoir notre cours sur les réseaux informatiques, nous sommes partis de la question suivante : quels sont les concepts des sciences sociales utiles à savoir pour la conception d’applications massives sur internet, et qui peuvent être enseignés en un semestre ? Cela nous a conduit à centrer notre cours sur les idées techniques et mathématiques à la frontière entre sciences sociales et systèmes technologies. Plus récemment, conscients que nos étudiants, dans leur vie professionnelle, construiront des systèmes informatiques qui auront un impact sur un segment de plus en plus large de la société, nous avons introduit un cours qui donne aux étudiants du cursus d’ingénieur des connaissances de base sur l’éthique et les grandes questions générales en matière de droit.

Inversement, même pour les étudiants non-informaticiens, il est de plus en plus important de connaître les idées de base de l’informatique et de comprendre les principes de fonctionnement des nombreux systèmes qu’ils utilisent dans leur vie quotidienne. De plus en plus, ils seront responsables de l’évaluation d’argumentaires basés sur des données, et doivent être capables de raisonner sur les aspects fondamentaux de la science des données et de l’apprentissage statistique.

Bien entendu, ces sujets ont vocation à être enseignés de plus en plus tôt dans le cursus éducatif. Nous connaissons l’évolution de sujets enseignés d’abord en 3e cycle, puis en licence, et enfin dès le lycée : les notions de base de l’informatique en sont un bon exemple.

Personnellement, je pars de l’hypothèse que, dans presque tous les domaines, il y a des connaissances importantes à acquérir. Il y a de plus de plus de choses à apprendre, et elles ont toutes leur importance, mais nous ne disposons que d’un temps fini pour apprendre. Pour gérer ce paradoxe, on pourrait compresser et mélanger les disciplines, et c’est en ces termes que j’essaie de penser nos formations, plutôt que de faire le choix d’écarter un champ disciplinaire spécifique.

B : Aurais-tu un conseil à donner à une jeune étudiante ou un jeune étudiant en informatique ?

JK : En général, il est préférable de se laisser guider par ce qui nous intéresse plutôt que parce ce que quelqu’un d’autre juge intéressant. Il y a tant de questions qui ouvrent des directions passionnantes que parfois on ne sait trop laquelle choisir, et nous sous-estimons souvent la largeur de spectre couvert par l’informatique ainsi que la rapidité à laquelle les nouveautés se développent. Si vous êtes en fin de licence ou de mastère, il se peut tout à fait que certaines questions vous “branchent” mais que vos enseignants ne soient pas aussi conscients du sujet que vous-même. Mais ce n’est pas parce qu’une question est trop nouvelle pour faire l’objet d’un cours que ce n’est pas un bon sujet d’étude, au contraire ! Il est tout à fait possible que ce soit précisément les questions importantes à étudier maintenant. L’histoire des développements de l’informatique le démontre.

Serge Abiteboul, Inria & ENS Paris, Claire Mathieu, CNRS, Paris, et Collège de France