A l’heure où Elon Musk fait un peu n’importe quoi au nom de la liberté d’expression, quand des grands patrons du numérique lui emboitent le pas sans doute pour pousser leurs intérêts économiques, il devient encore plus indispensable de comprendre les mécanismes qui causent des dysfonctionnements majeurs des plateformes numériques. Ce deuxième épisode d’un article de Fabien Gandon et Franck Michel nous aide à mieux comprendre. Serge Abiteboul & Thierry Viéville.

Dans le précédent billet nous vous avons donné l’excuse parfaite pour ne pas avoir fait de sport ce week-end : ce n’est pas de votre faute, votre cerveau a été hacké ! Nous avons vu que, à coup de likes, de notifications, de flux infinis et d’interfaces compulsogènes, les grands acteurs du Web ont mis au point des techniques capables de piller très efficacement notre temps de cerveau. Nous avons aussi vu que, en s’appuyant sur des données comportementales massives, les algorithmes apprennent à exploiter notre biais de négativité et favorisent les contenus qui suscitent colère, peur, indignation, ressentiment, frustration, dégoût, etc. Nous avons constaté que, en nous enfermant dans un espace informationnel où rien ne contredit nos croyances, les algorithmes de recommandation ont tendance à créer des visions du monde différentes pour chaque utilisateur. Nous avons enfin conclu que cette combinaison d’émotions, de biais cognitifs et de recommandations automatisées peut conduire à une escalade émotionnelle, à la polarisation et la radicalisation des opinions.

En manque… d’attention et en over-dose d’inattention

Finalement, ce premier billet nous amène à nous interroger sur le caractère addictogène de certains médias sociaux. Une addiction peut survenir dans toute activité pour laquelle une personne développe un appétit excessif. Il peut s’agir d’une dépendance à une substance (ex. une drogue) ou d’une dépendance comportementale, cette dernière se caractérisant par l’impossibilité de contrôler la pratique d’une activité comme les jeux d’argent, ou dans notre cas, l’utilisation d’un média social. On sait qu’une dépendance se développe lorsqu’un comportement particulier est incité et encouragé, qu’il est récompensé d’une manière ou d’une autre, et que rien n’incite à l’arrêter. Or les algorithmes de captation de l’attention sont des héritiers directs de la captologie et suivent à la lettre la formule de développement d’un comportement addictif : les utilisateurs font l’objets de notifications régulières pour initialiser et enclencher l’habitude ; la récompense de l’utilisation repose sur de multiples mécanismes (ex. nombre de likes, émotions, etc.) ; et l’absence de moyens de « décrocher » est au cœur des interfaces (ex. fil infini, auto-play, opt-out par défaut, etc.). On dit souvent qu’un algorithme est une recette, ici on pourrait même parler de la recette d’une drogue de synthèse numérique.

Voilà… Maintenant que le doute est là, vous voyez votre téléphone non seulement comme un espion qui vend vos données, mais aussi comme un traître, un manipulateur et même un dealer numérique ! Et vous vous interrogez sur les dégâts que font ces hackers du cerveau. Mais le problème va plus loin car le Web et Internet forment de vastes toiles qui couplent toutes leurs ressources, et les impacts de ces manipulateurs automatiques se propagent et se combinent par l’effet de mise en réseau.

Fausses informations pour vraie attention

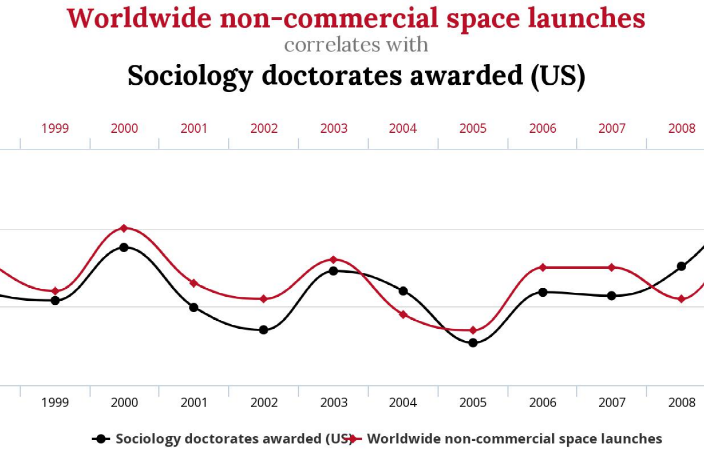

Partant des constats déjà sombres du précédent billet, il faut noter que les choses s’aggravent encore lorsque les contenus dont nous parlons sont des fake news, des fausses informations. En effet, celles-ci s’appuient souvent sur la colère, la frustration ou le dégoût pour hameçonner notre attention. Elles trouvent ainsi sur les réseaux sociaux un terrain particulièrement fertile. Par leurs affirmations choquantes, elles sont vécues par beaucoup comme une injonction à prendre parti en les re-partageant plutôt que de faire appel à l’esprit critique et vérifier leur véracité. Ainsi des études ont montré que les algorithmes de recommandation tendent à favoriser les fausses informations véhiculant des idées clivantes ou des événements choquants. Et comme ces informations sont souvent relayées par des connaissances, le biais de la preuve sociale nous incite à les juger crédibles et dignes de confiance. Répétées encore et encore, associées à des représentations du monde convoquant les théories du complot, renforcées sous la pression des bulles de filtres, et propulsées par l’effet de réseau, les fausses informations instaurent une économie du doute où la vérité est remplacée par la vraisemblance. Avec une éditorialisation qui ne fait pas la différence entre un article écrit par des journalistes professionnels d’un côté, et des fausses informations relayées par un bot malveillant de l’autre, « la presse n’est plus perçue comme celle qui publie, mais comme celle qui cache« . Progressivement et insidieusement, le doute sape notre confiance dans les experts (savants, journalistes…), entraînant des risques pour la santé publique et favorisant l’émergence d’idées extrêmes et de populismes qui mettent en danger les démocraties. Ce que Giuliano Da Empoli résume par la phrase : « le populisme naît de l’union de la colère et la frustration avec les algorithmes« .

Attentions troubles et troubles d’attention

Qui plus est, des études ont montré que la personnalité, les valeurs, les émotions et la vulnérabilité des utilisateurs influencent leur propension à propager de la désinformation. Chacun de nous aura donc des réactions différentes face aux mécanismes que nous avons vus. Mais au-delà de ce fait, nous avons jusqu’ici considéré des utilisateurs lambda sans problème de santé particulier. Il convient cependant d’envisager ce qui se passe pour les utilisateurs souffrant de handicaps ou de troubles mentaux comme la dépression, l’anxiété, le trouble d’achat compulsif, la paranoïa, le FOMO, le FOBO, etc.

On peut penser en particulier au trouble de déficit de l’attention (TDA). Des études attestent que les symptômes du TDA peuvent être aggravés par l’utilisation des médias numériques et de leurs applications conçues pour capter l’attention. Plus inquiétant encore, ces applications pourraient provoquer des TDA chez des personnes n’ayant aucun antécédent de ce trouble. Si ces études sont préliminaires elles nous encouragent à davantage de recherches sur le sujet ainsi qu’à nous poser la question du principe de précaution.

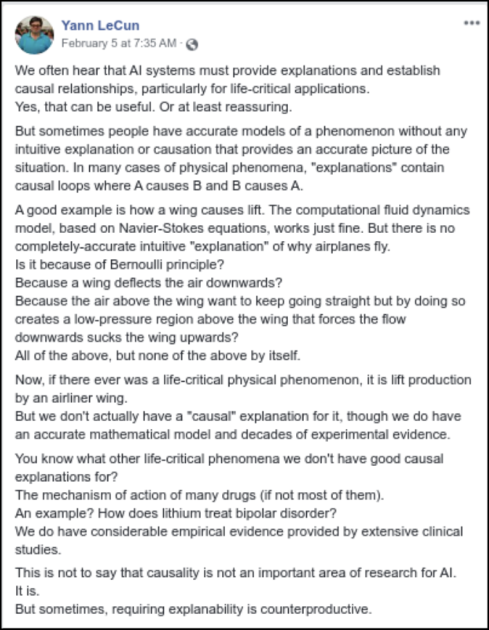

A l’attention des créatifs

Nous, les auteurs de ce billet, sommes des scientifiques. Comme d’autres collègues nous nous sommes reconnus dans l’article de David R. Smith : « Attention, attention : vos atouts scientifiques les plus précieux sont attaqués ». Dans cet article, Smith appelle à se pencher sur ce que les plateformes du Web font à la recherche et au domaine académique. En effet, même les scientifiques et ingénieurs les mieux informés sur ces sujets ne sont pas immunisés contre ces problèmes. Tout comme lire le “Petit traité de manipulation à l’usage des honnêtes gens” et “La soumission librement consentie” n’immunise pas contre la manipulation, connaître les méthodes de captation de l’attention n’est pas suffisant pour leur échapper.

Les « gadgets numériques », comme les appelle Smith, contribuent à ce qu’il appelle « un trouble de déficit de l’attention académique ». On sait que la concentration, mais aussi les moments d’ennui, de flânerie intellectuelle et de rêverie, sont essentiels à la pensée créative. Beaucoup d’entre nous ont déjà expérimenté l’éclair d’une idée soudaine au milieu d’un moment de détente. En volant ces moments, les systèmes de captation de l’attention entravent le processus créatif.

Bien sûr, ces remarques peuvent être généralisées à de nombreuses autres activités et professions nécessitant concentration, créativité et imagination. On peut en effet se demander ce que les systèmes de captation de l’attention font à des domaines comme la politique, la santé, l’éducation ou la création artistique, par exemple. En d’autres termes : attention penseurs et créateurs ! Nous devons repenser ces systèmes pour qu’ils répondent à nos besoins, et non l’inverse car la véritable monnaie d’échange de nos métiers est celle des idées.

Attention Fragile ! Vers des principes de préservation de l’attention

Après ces constats anxiogènes, essayons maintenant d’être constructifs. Puisque, dans un monde de plus en plus numérique, notre attention sur-sollicitée s’avère fragile, nous proposons d’aller vers une gouvernance responsable de l’attention sur le Web en posant plusieurs principes.

Un premier groupe de principes concerne les utilisateurs. Pour renforcer leur autonomie, le principe de la réflexivité continue propose que les plateformes leur fournissent régulièrement des retours d’information leur permettant d’être conscients de leurs usages (temps passé, exposition à des contenus négatifs, diversité, etc.), et permettant ainsi de garantir leur consentement éclairé à chaque instant. En outre, le principe de transparence préconise de leur expliquer clairement les motivations et les raisons derrière chaque recommandation, et le principe de soutien à la diligence raisonnable insiste sur l’importance de leur fournir les moyens et les informations nécessaires pour échapper aux boucles et processus imposés par les systèmes. Enfin, le principe d’opt-in par défaut suggère que les notifications et la personnalisation des recommandations soient désactivées par défaut, et activées uniquement après un consentement éclairé et un paramétrage volontaire.

Attention by design

Un deuxième groupe de principes vise à s’assurer que les plateformes intègrent dès leur conception (by design) le respect des utilisateurs. Le principe d’incitation orientée recommande d’utiliser des moyens légaux (interdire certaines pratiques) et économiques (taxes) pour encourager les plateformes à adopter des comportements ayant un impact sociétal positif (éducation, soutien à la collaboration et au débat constructif, élaboration collective de solutions sur les grands problèmes de société…). Et inversement, sanctionner les comportements nuisibles, une sorte de politique de la carotte et du bâton.

De plus, le principe de conception d’interactions bienveillantes appelle à placer le bien-être des utilisateurs au cœur de la conception des interfaces et de leurs objectifs algorithmiques, en s’alignant sur les bonnes pratiques des bright patterns plutôt que celles des dark patterns. D’autres médias sociaux sont en effet possibles, comme Wikipédia qui fait émerger du contenu de qualité sans jamais rechercher la viralité des contenus ni la popularité des contributeurs qui restent pour l’essentiel des citoyens anonymes.

Le principe des recommandations équilibrées vise à éviter la spécialisation excessive des contenus recommandés et à prévenir la formation de bulles de filtres. Notons aussi que lorsqu’une fausse information est corrigée ou démentie, il est fréquent que le message portant la correction ou le démenti soit quasiment invisible en comparaison de la viralité avec laquelle la fausse information a circulé. Aussi, pour aller vers plus de transparence, le principe de la visibilité équilibrée propose que les mesures préventives et correctives d’un problème soient rendues aussi visibles que le problème qu’elles traitent.

Enfin, pour que ces principes soient appliqués, le principe d’observabilité stipule que les plateformes doivent fournir aux institutions, à la société civile et aux chercheurs les instruments juridiques et techniques leur permettant d’effectuer un contrôle et une vérification actifs de l’application et de l’efficacité des réglementations.

L’attention comme bien commun

Dans une perspective plus large, si nous considérons l’attention comme un bien commun au sens économique, le principe de la préservation des communs numériques stipule aussi que les services ayant un impact mondial sur nos sociétés doivent être considérés comme des communs numériques, et à ce titre, protégés et soumis à des règles spécifiques de « préservation ». Cela pourrait par exemple passer par le fait de doter ces services (ou au moins les nouveaux entrants) d’une mission de soutien à un débat public constructif.

Enfin, le principe de transfert des meilleures pratiques invite à s’inspirer des approches éprouvées dans d’autres domaines, comme le droit encadrant la publicité, les casinos ou le traitement de certaines addictions, pour réguler efficacement les pratiques sur le Web. Prenons l’exemple de l’industrie du jeu vidéo : il a été montré qu’un lien existe entre les « loot boxes » (sortes de pochettes surprises des jeux vidéos) et l’addiction aux jeux d’argent. Celles-ci seraient comparables aux jeux de hasard, pouvant entraîner des comportements addictifs et mettre les joueurs en danger. Ce constat a donné lieu à plusieurs régulations. La manière d’étudier et de traiter cette exploitation indésirable de nos comportements et la transposition de connaissances issues d’autres domaines sont des sources d’inspiration pour d’autres pratiques problématiques sur le Web, telles que celles dont nous venons de parler.

Faisons attention… à nous

Résumons-nous. Avec l’objectif initial, somme toute banal, de rendre la publicité plus efficace, la généralisation des techniques de captation de l’attention et l’utilisation qu’elles font des biais cognitifs et des émotions ont des effets délétères très préoccupants sur nos sociétés : polarisation des opinions, diffusion de fausses informations, menace pour la santé publique, les économies et les démocraties. Et oui ! Ce sont donc des (ro)bots qui hackent notre attention car ils sont conçus pour cela ou, plus précisément, pour la capter de façon optimale en vue de la monétiser. De fait, ils utilisent le Web dans un but économique qui va à l’encontre du bien commun. Mais en adoptant les principes proposés ci-dessus, nous pensons qu’il est possible de construire un Web qui continue de soutenir l’activité économique sans pour autant entraîner la captation systématique de l’attention.

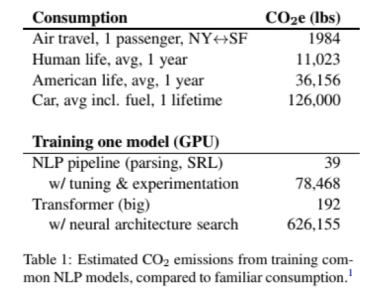

Dans ses essais, Montaigne nous disait “quand on me contrarie, on éveille mon attention, non pas ma colère : je m’avance vers celui qui me contredit, qui m’instruit.”. Or les plateformes nous poussent à faire le contraire : éveiller l’émotion négative et s’éloigner d’autrui. Mais il n’est pas raisonnable de laisser de multiples moyens technologiques hacker nos cerveaux et créer un déficit mondial d’attention, nous empêchant ainsi de la porter sur des sujets qui devraient actuellement nous « contrarier ». A une époque où nous devons modifier nos comportements (par exemple, la surconsommation de biens et d’énergie) et porter notre attention sur des questions cruciales comme le changement climatique, nous devrions nous demander si les algorithmes de recommandation font les bonnes recommandations, et pour qui. Compte tenu des quatre milliards d’utilisateurs pris chaque jour dans leurs boucles de recommandation, il est important de surveiller en permanence comment et dans quel but ces systèmes captent notre attention. Car lorsque notre attention est consacrée à un contenu choisi par ces plateformes, elle est perdue pour tout le reste.

Merci… pour votre attention 🙂

Fabien Gandon, Directeur de Recherche Inria et Franck Michel, ingénieur de recherche, Université Côte d’Azur, CNRS, Inria.

Image du jeu classique « snake »

Image du jeu classique « snake »

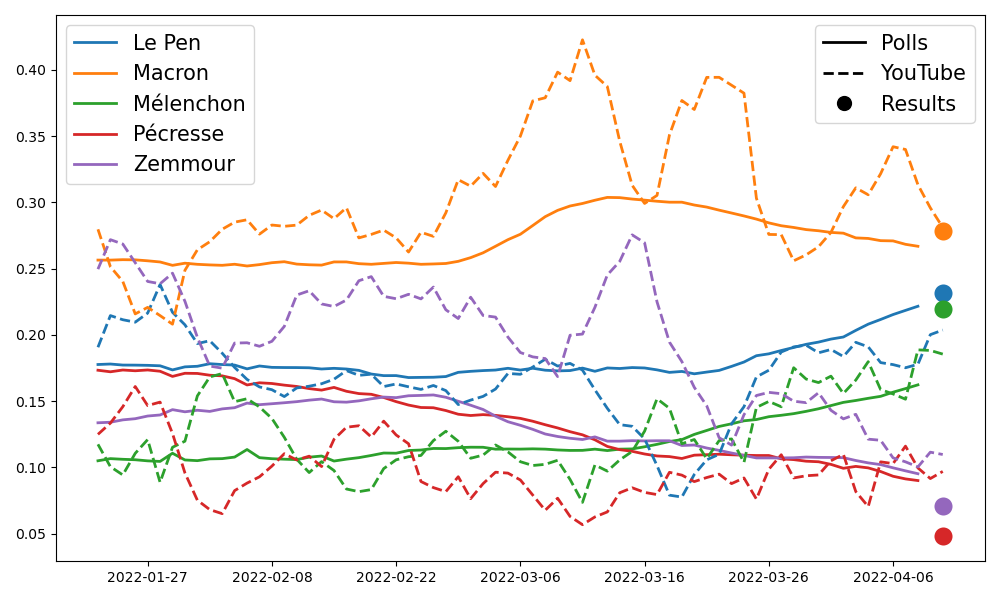

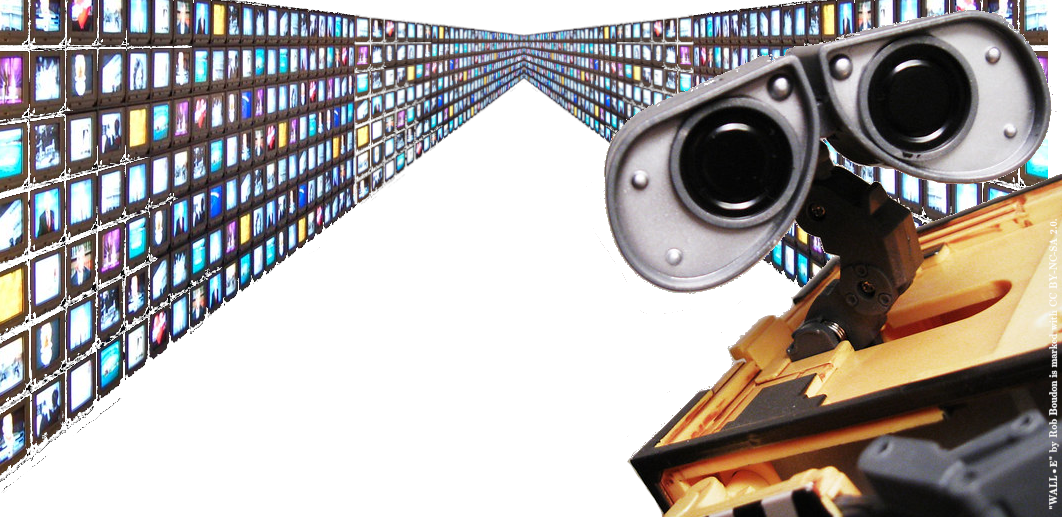

Un système de recommandation est un objet informatique ayant pour but de sélectionner de l’information pertinente pour les utilisateurs d’une plateforme (vidéos, articles, profils…). Sur YouTube par exemple, ces recommandations sont omniprésentes: en 2018, 70% des vues de vidéos provenaient de recommandation (par opposition à des vues provenant des recherches intentionnelles). On comprend alors que cet objet est à la fois critique pour l’entreprise, qui compte sur son efficacité pour maintenir l’utilisateur sur sa plateforme le plus longtemps possible, mais aussi critique pour l’utilisateur lui même, pour qui la recommandation façonne l’exploration, puisque c’est principalement via ce prisme qu’il accède à l’information.

Un système de recommandation est un objet informatique ayant pour but de sélectionner de l’information pertinente pour les utilisateurs d’une plateforme (vidéos, articles, profils…). Sur YouTube par exemple, ces recommandations sont omniprésentes: en 2018, 70% des vues de vidéos provenaient de recommandation (par opposition à des vues provenant des recherches intentionnelles). On comprend alors que cet objet est à la fois critique pour l’entreprise, qui compte sur son efficacité pour maintenir l’utilisateur sur sa plateforme le plus longtemps possible, mais aussi critique pour l’utilisateur lui même, pour qui la recommandation façonne l’exploration, puisque c’est principalement via ce prisme qu’il accède à l’information.