Alors que le numérique s’impose dans tous les aspects de notre quotidien, ses impacts environnementaux interrogent.

Martin Deron, responsable du Défi numérique de Chemins de transition (Université de Montréal) et doctorant à l’université Concordia, et Benjamin Ninassi, adjoint au responsable du programme Numérique et Environnement d’Inria, nous partagent ici des réflexions émergentes sur comment repenser le numérique pour le rendre compatible avec les contraintes environnementales et énergétiques, tout en lui permettant de contribuer à la construction de sociétés plus résilientes et soutenables ?

Antoine Rousseau et Thierry Viéville .

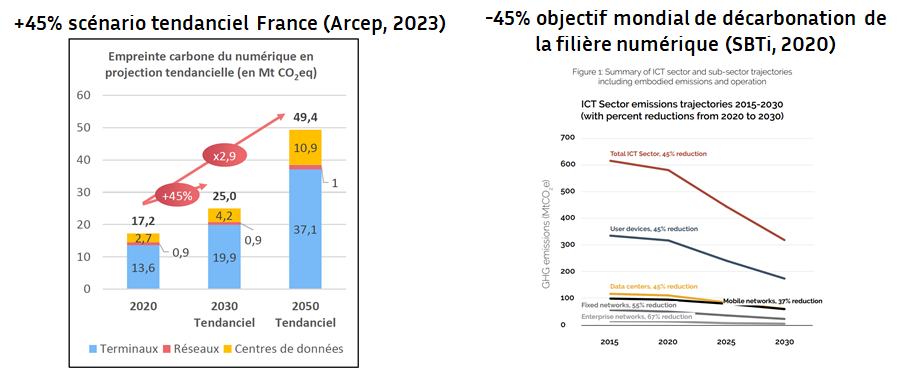

Les discussions sur les impacts environnementaux du numérique gagnent en importance, s’inscrivent dans les pratiques professionnelles et commencent même à s’institutionnaliser, notamment en France mais aussi dans d’autres pays, comme la Suisse, la Belgique et le Québec [1].

Ces initiatives convergent vers une conclusion commune : la nécessité de maîtriser les impacts environnementaux du développement numérique pour ne pas compromettre les efforts de transition socio-écologique.

Dans ce contexte, la notion de “sobriété numérique” émerge comme une réponse : elle se concrétise par diverses stratégies visant à prolonger la durée de vie des équipements, alléger les services numériques et réduire leur consommation énergétique. Bien que ces initiatives soient encourageantes et méritent d’être soutenues, elles restent toutefois insuffisantes face aux trajectoires insoutenables de la numérisation.

En réalité, l’enjeu dépasse la simple optimisation technologique. Le numérique s’intègre dans toutes les sphères de la société, y compris celles qui portent directement atteinte à l’intégrité de la planète[2]. Des optimisations appliquées sans discernement risquent ainsi d’amplifier des activités insoutenables, comme le minage de cryptomonnaies ou l’exploration pétrolière automatisée. Par ailleurs, le développement numérique repose largement sur des modèles d’affaires axés sur l’accumulation perpétuelle, qu’il s’agisse d’appareils connectés ou de données collectées, qui doivent également être remis en question pour réorienter les trajectoires actuelles.

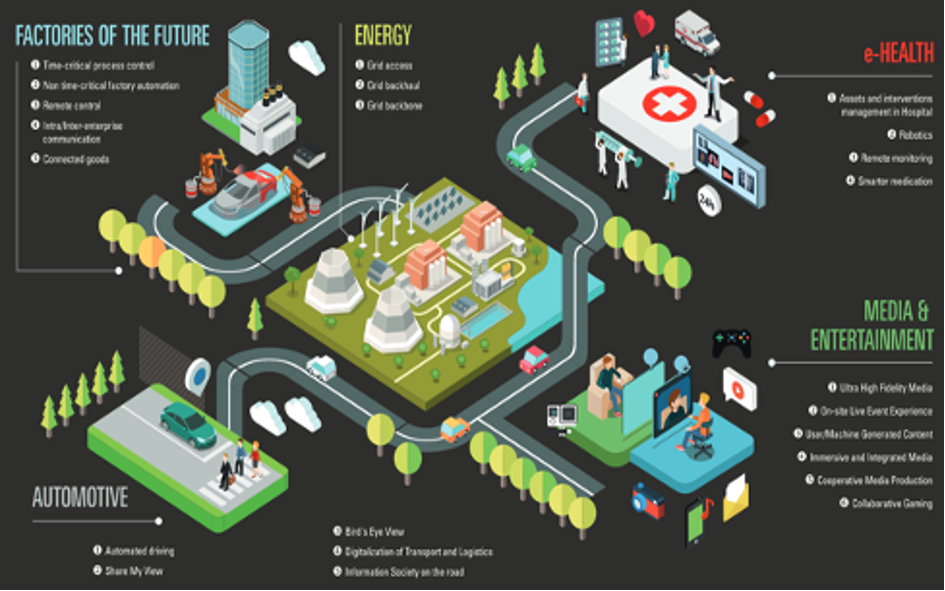

La course effrénée à l’intelligence artificielle (IA) générative, la multiplication d’objets connectés et de centres de données illustrent des dynamiques incompatibles avec un cadre de soutenabilité à long terme, même avec les meilleures stratégies d’optimisation. À cela s’ajoute la menace grandissante de l’épuisement progressif de ressources essentielles aux technologies numériques, notamment certains métaux critiques.

Rendre le développement numérique compatible avec la transition socio-écologique exige une remise en question profonde des dynamiques dont il dépend et de sa compatibilité avec les contraintes énergétiques, climatiques et matérielles à venir. Il s’agit alors de le prioriser collectivement, d’en définir les paramètres de déploiement, et d’inventer de nouveaux rapports aux technologies qui sont à la fois véritablement utiles et durables. L’optimisation, prise isolément, n’est pas suffisante pour atteindre la sobriété : elle n’a de sens que lorsqu’elle s’inscrit dans un système qui intègre et respecte les contraintes socio-écologiques, et nécessite des efforts de formation adaptés.

Une priorisation dans d’autres secteurs

La réflexion entre optimisation et sobriété dépasse le numérique et s’inscrit plus généralement dans le cadre de la transition socio-écologique. Ainsi, les optimisations techniques, telles que celles observées dans les véhicules électriques ou les systèmes de chauffage bas carbone ne sont véritablement efficaces que lorsqu’elles s’intègrent dans des systèmes repensés : une mobilité axée sur le collectif, des habitats mieux isolés, le tout soutenu par des énergies renouvelables.

Cette problématique se pose également dans d’autres secteurs, où les impacts environnementaux et la disponibilité des ressources rendent la question plus pressante. En France, par exemple, le Secrétariat général à la planification écologique (SGPE) propose une hiérarchisation des usages de la biomasse locale (page 15), privilégiant la souveraineté alimentaire à la production de biocarburants pour l’aviation civile, le chauffage ou la production énergétique.

De même, l’hydroélectricité québécoise fait face à une multiplication de projets industriels sollicitant son accès. Depuis 2023, tout projet de plus de 5 mégawatts doit obtenir l’approbation du ministère de l’Énergie, suite à une demande d’Hydro-Québec. Ce changement législatif, initié par la société d’État responsable de la production électrique, répond à son incapacité à satisfaire toutes les demandes de raccordement. La priorisation s’opère selon des critères définis : les capacités techniques de raccordement et les incidences sur le réseau électrique du Québec, les retombées sur l’économie et le développement régional, l’impact environnemental et social, ainsi que la cohérence avec les orientations gouvernementales.

Prioriser les projets numériques utiles ?

Les réflexions autour de la priorisation commencent à émerger également dans les travaux récents consacrés au numérique et à l’IA responsable, notamment à travers le prisme de l’utilité. Le Référentiel général d’écoconception de services numériques, porté par l’ARCEP, invite ainsi à mettre en dialogue l’utilisation d’un service avec ses impacts environnementaux. De même, le Référentiel général pour l’IA frugale de l’Afnor souligne que toute analyse technique doit être précédée d’une réflexion sur les besoins et usages, en s’assurant qu’ils “visent à rester dans les limites planétaires et ont été préalablement questionnés”. Par ailleurs, la Net Zero Initiative for IT va encore plus loin en établissant des critères d’éligibilité pour qu’un service numérique puisse prétendre éviter des émissions de gaz à effet de serre. Ces critères incluent le secteur d’activité de l’entreprise, excluant explicitement les industries considérées comme structurellement contraires aux objectifs de développement durable de l’ONU, comme l’extraction ou l’exploration d’énergies fossiles, l’industrie du tabac ou encore la pornographie (cette dernière considérée comme contraire aux objectifs 3 et 5, voir page 21 de la méthodologie).

L’émergence de ces cadres méthodologiques amène dans le débat une question fondamentale commune à ces différentes initiatives : qu’est-ce qu’un numérique utile ?

La question n’est pourtant pas si nouvelle, puisque depuis l’essor du numérique au 20ᵉ siècle, deux visions antagonistes se dessinent quant à sa finalité. La première, largement dominante, aborde le numérique comme un outil de substitution, destiné à exécuter des tâches à la place des humains. Cette approche, qui est omniprésente dans l’industrie et le quotidien (des caisses automatiques aux applications de guidage GPS), vise avant tout la maximisation des profits et le gain de temps. Pourtant, ce “gain de temps” s’accompagne paradoxalement d’un sentiment d’accélération : le temps libéré est immédiatement réinvesti dans des activités productives, comme l’illustrent les enchaînements de réunions en visioconférence, sans pauses permises par les déplacements physiques. Cette approche crée également une dépendance, en dépossédant les utilisateurs de compétences auparavant essentielles. Par exemple, l’usage systématique des applications de guidage via GPS pour générer et suivre un itinéraire élimine la nécessité de maîtriser la géographie ou les repères topologiques.

À l’inverse, une seconde vision promeut un numérique au service de la complémentarité. Ici, l’objectif principal est d’aider les individus à apprendre et à agir. Le projet “Back to the Trees”, par exemple, propose un outil éducatif minimaliste qui accompagne les utilisateurs dans l’identification des plantes à travers un questionnaire reprenant les caractéristiques d’identification des livres de botaniste. Ce numérique “low-tech” favorise l’acquisition de savoir de façon ludique tout en consommant peu de ressources.

Au-delà des projets futurs, on peut légitimement se demander si ce questionnement de l’utilité, largement invisibilisé dans le débat public jusqu’à présent, ne devrait pas également concerner l’existant.

Que faire des usages existants, incompatibles avec une transition à long terme ?

L’univers numérique est en constante évolution et il est certainement plus facile de planifier ou de réorienter des projets qui n’existent pas encore plutôt que de le faire une fois déployés. Se pose cependant la question de la possibilité de faire atterrir l’univers numérique actuel dans le cadre des limites planétaires. Avec le déclin des ressources naturelles (métaux, minéraux, eau, énergie, etc.) et l’aggravation des aléas climatiques, il devient impératif d’évaluer la compatibilité de nos infrastructures numériques, dont nos modes de vie dépendent de plus en plus, avec un avenir marqué par ces contraintes.

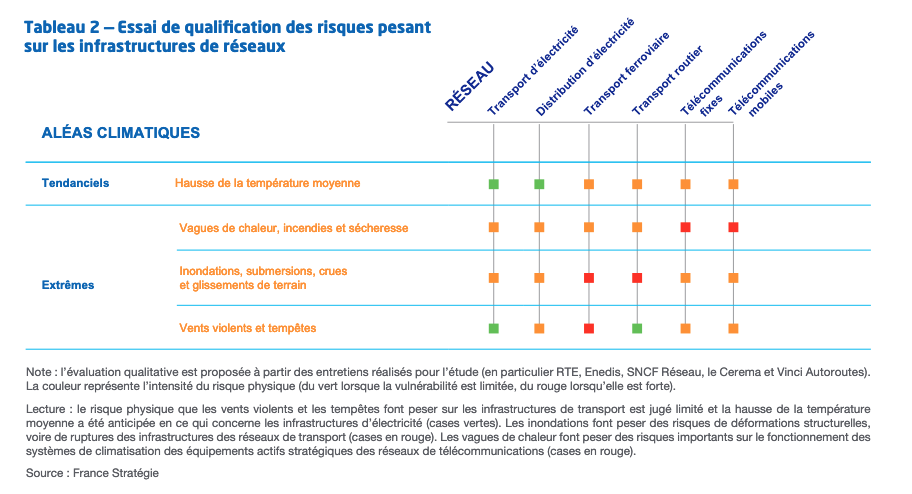

Au-delà de la raréfaction des ressources nécessaires à leur fonctionnement, ces infrastructures devront également affronter des conditions climatiques de plus en plus difficiles. Sécheresses, montées des eaux, inondations et stress hydrique sont autant de phénomènes dont la fréquence et l’intensité continueront à croître. Or, les infrastructures numériques sont particulièrement vulnérables à ces risques.

Par exemple, selon l’intensité des aléas climatiques, les réseaux numériques, notamment essentiels pour l’électricité, les communications, et le transport, pourraient subir des déformations structurelles, voire des ruptures, à cause des vagues de chaleur, des vents violents ou des inondations extrêmes. Cette fragilité est exacerbée par la complexité et l’interdépendance de ces infrastructures : une simple défaillance dans un élément critique, même situé à l’extérieur d’un territoire donné, peut entraîner sa déconnexion totale. Bien que renforcer leur résilience soit possible, cela nécessiterait une redondance accrue des infrastructures, impliquant à son tour une consommation accrue de ressources.

Imaginer un numérique compatible avec un futur contraint

Dans ce contexte, une réflexion s’impose : à quoi ressembleraient des infrastructures, appareils, modèles d’affaires et usages numériques compatibles avec des sociétés limitées en ressource tout en étant résilients face à l’augmentation des risques climatiques? Cette question, cruciale, nous invite à nous projeter dans l’avenir pour mieux éclairer les choix collectifs à faire aujourd’hui.

– Quelles branches existantes de l’univers numérique actuel pourraient rester pertinentes, voire devenir essentielles, pour soutenir des sociétés plus soutenables et résilientes ?

– Quelles branches pourraient être repensées pour répondre aux nouvelles contraintes ?

– Quelles branches sont fondamentalement incompatibles avec ces perspectives et nécessitent une redirection, un renoncement ou un abandon ?

Ces questions peuvent être traduites en implications opérationnelles. Par exemple, les systèmes d’IA particulièrement énergivores, comme ceux basés sur des modèles de langage massifs (LLM), sont-ils compatibles avec un monde aux ressources limitées ? Est-il raisonnable de rendre nos sociétés toujours plus dépendantes de ces technologies ?

Planification et priorisation : un impératif pour le numérique

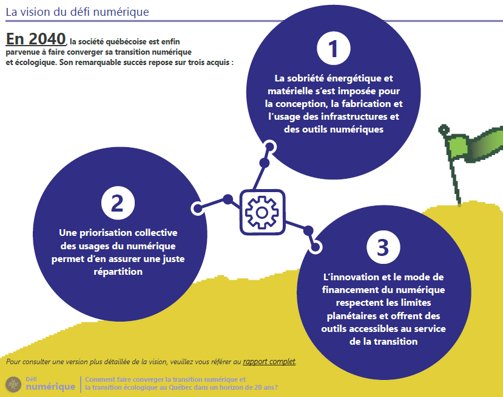

Pour devenir compatible avec le cadre des limites planétaires, en réduisant ses impacts directs et en renforçant sa résilience, le numérique devra s’éloigner de ses paradigmes expansifs actuels. Il devra s’inscrire dans une logique de planification et de priorisation. Allant dans ce sens, la Commission de l’Éthique en Science et Technologie (CEST) du Québec a récemment rédigé un avis complet de 112 pages sur l’impératif de la sobriété numérique, appelant explicitement dans ses recommandations à enclencher rapidement une démarche de réflexion sur la priorisation des usages du numérique.

Quelques questions majeures subsistent pour accompagner ces transformations, notamment :

– Comment opérationnaliser ces arbitrages ?

– À quelle échelle agir, et qui doit être impliqué dans ces décisions ?

– Sur quels critères éthiques, sociaux, environnementaux, économiques, voire opérationnels, peut-on fonder ces choix ?

Plusieurs individus et collectifs explorent ces questions essentielles, offrant des pistes de réflexion qui méritent que l’on s’y attarde. Bien sûr, aucun ne propose de solution prête à l’emploi, et c’est compréhensible : prioriser le numérique implique de le recontextualiser, de le repolitiser, et donc de nourrir des discussions et des choix collectifs. Parmi les initiatives notables, certains tentent de définir les contours d’un numérique alternatif, que ce soit à travers l’Alternumérisme radical ou le concept de Numérique d’Intérêt Général. Pour envisager une réelle redirection des systèmes techniques vers un cadre de soutenabilité non basé sur des formes de “technologies zombies”, Alexandre Monnin et ses collègues rappellent l’importance de cartographier nos attachements, qu’ils soient positifs ou contraignants. Mobilisant des approches prospectives et participatives, Chemins de transition explore les implications sociétales d’une convergence entre transition numérique et transition socio-écologique. Le groupement de recherche CNRS “Centre internet et société” propose des pistes de réflexion à travers son groupe de travail “Politiques environnementales du numérique”. Enfin, la conférence annuelle LIMITS rassemble des recherches qui esquissent un système d’information en phase avec un monde limité, qu’il s’agisse de réinterroger l’internet des objets avec le cadre des limites planétaires ou d’imaginer des approches de désescalade numérique.

Vers le fini, et pas au-delà

Adapter le numérique aux défis de demain exige de dépasser les défis technologiques et nous invite à nous engager dans une réflexion collective sur les modalités de son déploiement dans nos sociétés. Utiliser des critères éthiques, démocratiques, environnementaux et sociaux devient alors incontournable pour guider une redirection du numérique afin de le rendre compatible avec la transition vers des modes de vie plus soutenables. Il s’agit de décider collectivement de quel numérique nous voulons, de se donner les moyens de le faire advenir et de renoncer aux formes insoutenables.

Martin Deron, responsable du Défi numérique de Chemins de transition (Université de Montréal) et doctorant à l’université Concordia,

Benjamin Ninassi, adjoint au responsable du programme Numérique et Environnement d’Inria

[1] Quelques exemples d’initiatives en dehors de France :

– https://isit-ch.org

– https://isit-be.org

– https://w3c.github.io/sustyweb

– https://agitquebec.org

– https://cheminsdetransition.org/les-ressources/defi-numerique

– https://www.obvia.ca/recherche/axes/sobriete-numerique-et-transition-socio-ecologique

– https://www.linkedin.com/company/collectif-numerique-responsable-soutenable/posts

– https://ethique.gouv.qc.ca/media/wayd3cqj/cest_avis-sur-la-sobri%C3%A9t%C3%A9-num%C3%A9rique.pdf

[2] Martin, J. et Durand Folco, J. (2023) Le capital algorithmique. Accumulation, pouvoir et résistance à l’ère de l’intelligence artificielle. Écosociété.

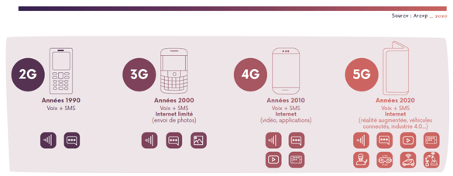

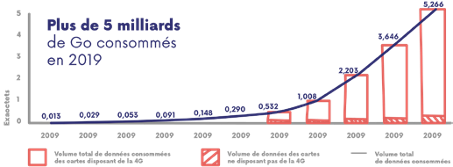

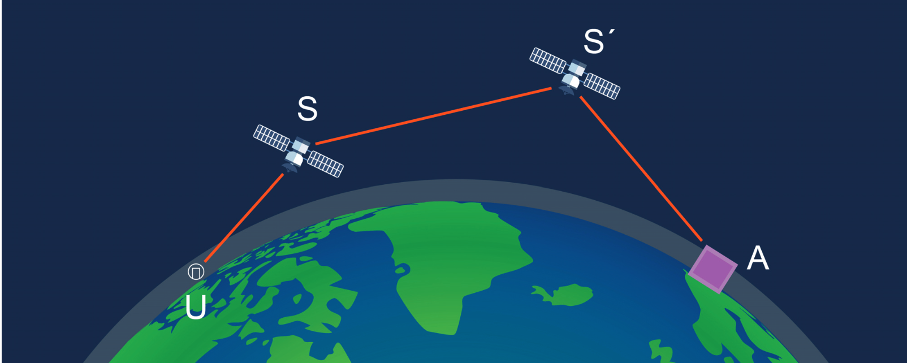

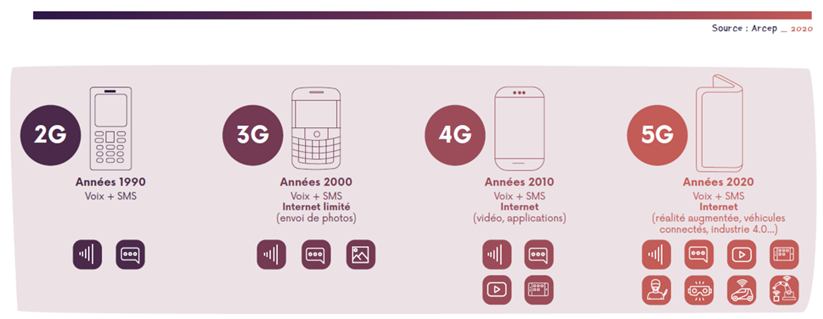

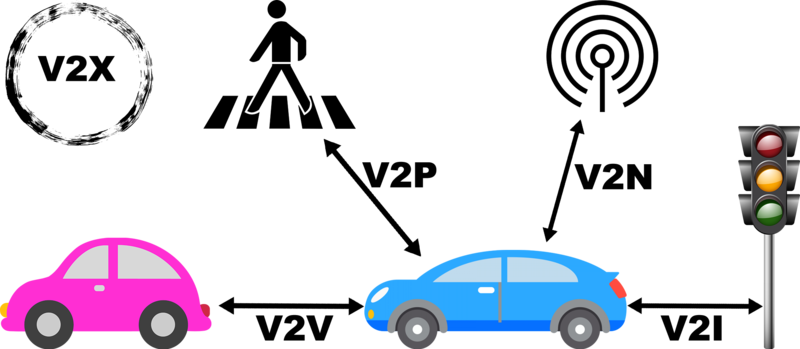

Oui binaire s’adresse aussi aux jeunes de tous âges que le numérique laisse parfois perplexes. Avec « Petit binaire », osons ici expliquer de manière simple et accessible cette notion de 5G. Marie-Agnès Enard et Pascal Guitton.

Oui binaire s’adresse aussi aux jeunes de tous âges que le numérique laisse parfois perplexes. Avec « Petit binaire », osons ici expliquer de manière simple et accessible cette notion de 5G. Marie-Agnès Enard et Pascal Guitton.