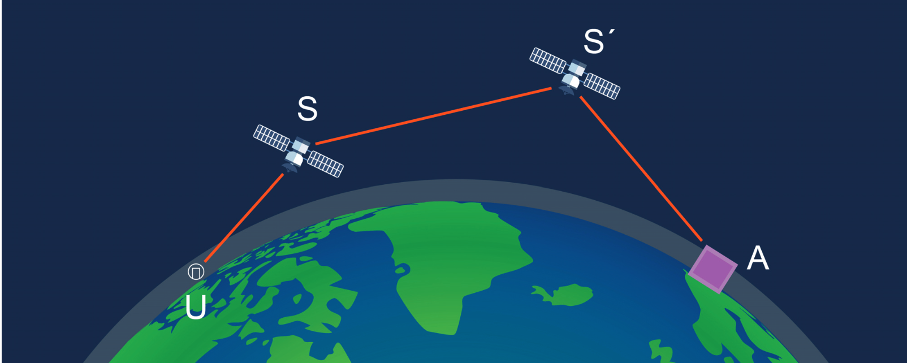

Nous assistons au déploiement de constellations de satellites avec des

dizaines de milliers de satellites en orbite basse. Les fonctionnalités

de ces constellations sont essentiellement les télécommunications haut-débit,

la géolocalisation et l’observation de la Terre. Quelles sont les avancées

scientifiques et technologiques qui permettent ces développements ?

Quels sont les enjeux économiques et géostratégiques associés ?

Ces constellations conduisent à une densification de l’espace et à

une multiplication des lancements et des débris. Elles ont un impact

négatif sur sur l’observation astronomique dans le domaine optique et dans

celui de la radioastronomie. Quels sont les dangers encourus avec la

multiplication des débris en orbite basse ? Quel est l’impact des lancements

sur la stratosphère et celui des rentrées de satellites dans l’atmosphère ?

Un groupe de travail de l’Académie des sciences s’est penché sur le sujet,

a auditionné de nombreux spécialistes, et publié un rapport en mars 2024,

rédigé par François Baccelli, Sébastien Candel, Guy Perrin et Jean-Loup

Puget.

Les deux premiers auteurs nous éclairent sur le sujet. Serge Abiteboul (qui a

participé au groupe de travail), voici la deuxième partie de ce partage, après la première.

Impact sur l’astronomie

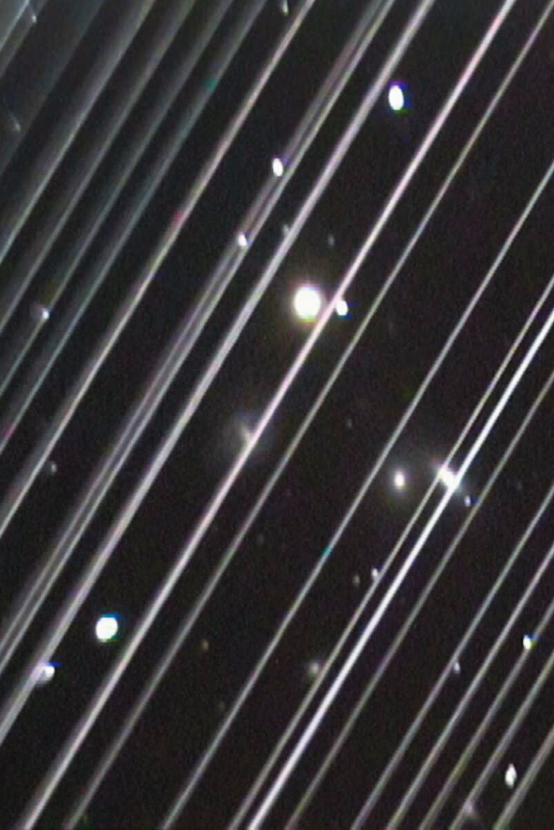

Le lancement de milliers de satellites en orbite basse change fondamentalement l’accès de l’être humain au ciel nocturne. Ses effets se font déjà ressentir pour l’astronomie au sol dans un ensemble de domaines.

Pour l’astronomie optique (incluant l’infrarouge proche et moyen), le problème principal est celui de la réflexion du flux solaire par les satellites défilant dans le champ de vision des télescopes avec des effets marqués au lever et au coucher du Soleil avec des effets marqués sur la prise d’images par les instruments à grand champ de vue. S’il y a une bonne coopération avec Starlink pour la réduction de la lumière solaire réfléchie par les satellites, le futur est loin d’être sous contrôle avec la multiplication des interlocuteurs et des constellations stratégiques et commerciales.

Pour la radioastronomie, la perspective d’une perturbation permanente venant par le haut est préoccupante. La politique de sanctuaire radio local (qui consiste à ne pas émettre dans les régions qui hébergent les grands observatoires radio) acceptée par Starlink atténue les problèmes pour les fréquences adjacentes à celles des émissions des satellites. Mais les électroniques des satellites rayonnent aussi à basse fréquence et constituent une source de bruit pour les observations radio dans une autre gamme de fréquences même si les émissions de signaux de télécommunication des satellites sont momentanément interrompues. À cela s’ajoute des besoins de protection des observations en mode interférométrique qui impliquent des installations réparties sur plusieurs continents et nécessitent des actions coordonnées spécifiques.

Les conséquences négatives pour l’astronomie d’une multiplication incontrôlée de ces constellations doivent impérativement être prises en compte et des mesures pour pallier ces problèmes doivent être mises en œuvre par leurs promoteurs.

Impact sur l’environnement

Dans un contexte de multiplication des lancements, il est important d’examiner la question de l’impact des émissions sur la haute atmosphère. Ces émissions dépendent du type de motorisation, de la masse au décollage et du nombre de lancements. C’est le lanceur Falcon de SpaceX qui réalise actuellement le plus grand nombre de lancements, plus d’une centaine en 2023.

Les émissions correspondantes de 140 kilotonnes de carbone, de vapeur d’eau, d’hydrocarbures imbrûlés et de particules de suies sont en valeur absolue relativement faibles si on les compare à celles issues des transports mais elles sont cependant non-négligeables car ces émissions vont s’accumuler dans la haute atmosphère. C’est le cas notamment des particules de carbone, désignées sous le nom de “black carbon » (BC), qui sont nettement plus nombreuses par unité de masse de kérosène, dans les gaz éjectés par les moteurs du lanceur, et nettement plus importante que celles qui existent dans les jets des moteurs d’avion (le rapport serait de l’ordre de 104). Comme une partie de ces émissions est faite au-dessus de la tropopause, les aérosols formés par les particules BC peuvent s’accumuler pendant plusieurs années, interagir avec la couche d’ozone, modifier le bilan radiatif et changer la distribution de température. Il y a des incertitudes sur ces effets, car les niveaux d’émissions sont faibles, mais la question de l’impact sur la haute atmosphère mérite d’être approfondie. L’impact sur l’environnement des fins de vie opérationnelle des satellites est lui aussi à prendre en compte même si la masse associée au retour sur Terre de 2400 objets, d’une masse totale de 340 tonnes, reste finalement modérée par rapport aux 15 à 20000 tonnes de météorites qui pénètrent chaque année dans l’atmosphère terrestre.

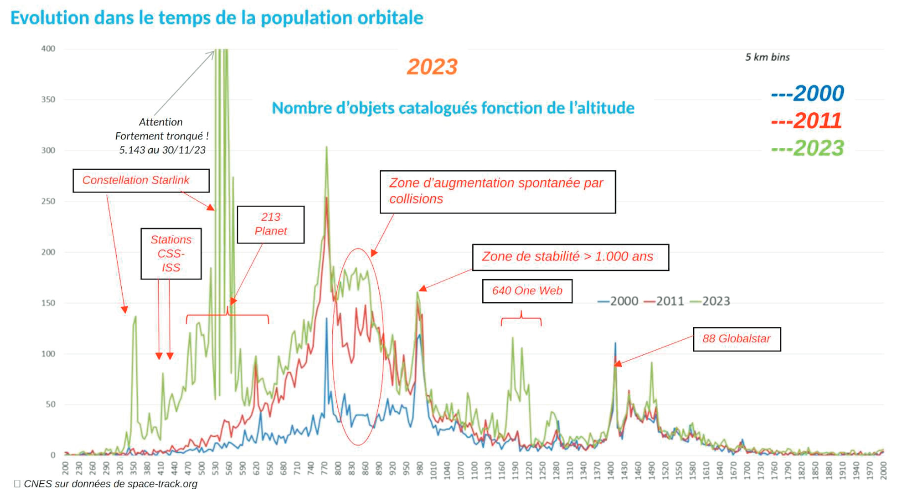

Un problème majeur est celui des débris spatiaux. Il y aurait déjà en orbite un demi-million à un million de débris de 1 à 10 cm et cent à cent trente millions de taille entre 1 mm et 1 cm selon l’ESA et la NASA. Sur les 14 000 satellites en orbite, environ 35% ont été lancés au cours de ces trois dernières années et 100 000 autres sont prévus dans la décennie à venir, toujours selon l’ONU. Ces données communiquées – récemment par l’AFP montrent la nécessité de la mise en place d’une régulation contraignante sur le contrôle des fins de vie opérationnelle des satellites.

Nécessité d’un renforcement de la régulation internationale

L’analyse des impacts négatifs fait apparaître un besoin de régulation internationale d’un domaine qui pour le moment se développe en l’absence de toute contrainte (si ce n’est celle du coût des lancements) et elle souligne la nécessité d’initiatives et d’actions engagées par les parties prenantes pour identifier des principes et des codes de bonnes pratiques qui puissent être adoptés par un nombre croissant de pays. Une autre question importante est celle des solutions techniques permettant de prendre en compte ces impacts négatifs et de se prémunir des scénarios les plus inquiétants. Les règles internationales se construisent par l’identification de principes et de codes de bonne pratique adoptés par un nombre croissant de pays. Plusieurs exemples d’efforts de ce type sont décrits dans le rapport. Il est essentiel que les États et les communautés scientifiques concernées contribuent à la formalisation de ces principes et codes dans le but d’obtenir rapidement une régulation internationale du secteur.

Constat d’ensemble et perspectives

Les constellations de satellites ouvrent des perspectives intéressantes, elles offrent des possibilités nouvelles pour les communications, l’observation de la Terre, la géolocalisation et la connectivité et cela, avec des capacités de résilience supérieures à celles des infrastructures terrestres. Sans pouvoir remplacer les réseaux actuels pour l’accès à internet, elles peuvent compléter ces réseaux et assurer une couverture des zones blanches dans lesquelles cet accès n’est pas disponible ou encore permettre des connexions lorsque ces infrastructures sont détruites à la suite de catastrophes naturelles ou de conflits armés. Les constellations de satellites font aussi apparaître des enjeux de souveraineté résultant de la dépendance et de la perte de contrôle induite par la prééminence de certains acteurs privés. L’expansion du nombre et de la taille des constellations pose aussi des questions majeures en matière d’impact sur l’environnement spatial par la densification en satellites et en débris, sur l’environnement atmosphérique par l’augmentation du nombre de lancements et par les retours sur Terre des satellites en fin de vie opérationnelle. Dans un contexte de croissance incontrôlée qui prévaut actuellement, l’augmentation du nombre d’objets en orbite fait que les manœuvres d’évitement deviennent de plus en plus fréquentes et elle conduit à une multiplication du nombre de collisions. L’impact des constellations sur l’astronomie est également préoccupant car il touche à la fois les observations optiques et infrarouges et celles qui sont réalisées dans le domaine radioélectrique. L’analyse des impacts négatifs fait apparaître un besoin de régulation internationale d’un domaine qui pour le moment évolue en l’absence de toute contrainte (si ce n’est celle du coût des lancements) et elle souligne la nécessité d’initiatives et d’actions engagées par les parties prenantes pour identifier des principes et des codes de bonnes pratiques qui puissent être adoptés par un nombre croissant de pays.

François Baccelli, Inria et Télécom-Paris, membre de l’Académie des sciences et Sébastien Candel, Centrale Supélec, membre de l’Académie des sciences