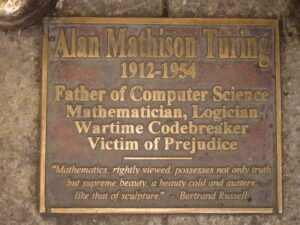

2012 a été l’année du centenaire de la naissance d’Alan Turing. Cette icône de l’informatique a été célébrée dignement. A la fin du mois, sort un film biographique sur Turing, un blockbuster, « The Imitation Game ». Binaire se devait d’accompagner l’événement et a donc demandé leurs réactions à plusieurs amis. Nous démarrons avec Jean Lassègue, philosophe des sciences. Il remet en jeu quelques idées reçues. Serge Abiteboul.

J’avais eu l’occasion de passer un an à Oxford il y a presque trente ans. J’étais alors tombé par hasard sur la biographie de Turing écrite par le mathématicien Andrew Hodges, Alan Turing, The Enigma. Je fus immédiatement subjugué par ses qualités littéraires : la beauté de cette prose, les exergues du poète Walt Witman, mais aussi la culture britannique – des rites propres aux écoles secondaires à la campagne anglaise – me parlaient d’un monde que je connaissais bien mieux que la logique mathématique que j’avais commencé à étudier cette année-là. Je lus le livre d’une traite et le relus un certain nombre de fois dans les années qui suivirent, pendant lesquelles Turing fut pour moi tout à la fois une sorte d’interlocuteur, une grille d’interprétation et une source d’interrogation sur la façon dont la science s’inscrit dans le siècle.

Me voici de retour à Oxford. Entre temps, Turing est devenu l’une des figures les plus célèbres de l’histoire de l’informatique et, ce 18 décembre, on joue, au cinéma de Walton Street où j’allais de temps en temps à l’époque, le film de Morten Tyldum « The Imitation Game » qui porte sur la biographie de Turing et qui sortira en France le 28 janvier 2015. Quoi de plus normal, vingt-huit ans après avoir quitté Oxford, que d’aller voir ce film, et de renouer, sur le mode d’une fiction, avec ce qui allait devenir l’un des thèmes majeurs de mes préoccupations pendant les années qui suivirent ? Le film allait me rappeler encore une fois, s’il le fallait, combien il est difficile de parler d’un scientifique sans tomber dans l’hagiographie ou le grand spectacle, et ce, même quand le film est basé sur le livre si réussi d’Andrew Hodges.

Je ne compte pas faire une critique détaillée du film, décidément trop « théâtral » pour moi, même s’il m’a paru bien servi par les acteurs et qu’il peut sans doute permettre à un spectateur qui ignorerait tout de la vie de Turing de se faire une première idée du rôle capital qu’il joua pendant la guerre quand, en décryptant les messages codés envoyés aux sous-marins allemands faisant le blocus de l’Angleterre, il réussit à déjouer le blocus et raccourcit de ce fait la guerre de deux ans en sauvant des milliers de vies humaines. Cependant, réussir à faire tourner l’intrigue autour du couple Alan Turing / Joan Clarke, mathématicienne avec qui il fut fiancé à l’époque où ils faisaient tous les deux partie de l’équipe de décryptage, tient pour moi d’un véritable prodige quand on sait, comme le montre d’ailleurs le film, que Turing était homosexuel et que son homosexualité lui valut condamnation pénale et contribua à son suicide. D’autres films récents, relevant plus du genre « documentaire » (voir en fin de blog) me paraissent plus proches de la vérité historique.

Je ne compte pas faire une critique détaillée du film, décidément trop « théâtral » pour moi, même s’il m’a paru bien servi par les acteurs et qu’il peut sans doute permettre à un spectateur qui ignorerait tout de la vie de Turing de se faire une première idée du rôle capital qu’il joua pendant la guerre quand, en décryptant les messages codés envoyés aux sous-marins allemands faisant le blocus de l’Angleterre, il réussit à déjouer le blocus et raccourcit de ce fait la guerre de deux ans en sauvant des milliers de vies humaines. Cependant, réussir à faire tourner l’intrigue autour du couple Alan Turing / Joan Clarke, mathématicienne avec qui il fut fiancé à l’époque où ils faisaient tous les deux partie de l’équipe de décryptage, tient pour moi d’un véritable prodige quand on sait, comme le montre d’ailleurs le film, que Turing était homosexuel et que son homosexualité lui valut condamnation pénale et contribua à son suicide. D’autres films récents, relevant plus du genre « documentaire » (voir en fin de blog) me paraissent plus proches de la vérité historique.

Je m’en tiendrai à un aspect particulier du film de Tyldum parce qu’il témoigne d’une attitude générale : sa fidélité stricte à l’interprétation de la biographie écrite par Andrew Hodges. Or il se trouve que, malgré les qualités éminentes que je reconnais volontiers au livre de Hodges dans lequel j’ai tant appris, je suis devenu, au fil du temps, fondamentalement en désaccord avec son interprétation. Le film « The Imitation Game », par fidélité à Hodges, me semble donc fondamentalement infidèle à Turing et c’est de cela dont je voudrais parler. Il ne s’agit pas seulement d’un débat entre spécialistes sur quelques vagues points de détail de l’histoire intellectuelle de Turing qui n’intéressent qu’eux et qui n’ont aucune portée. Il s’agit au contraire d’un point fondamental qui distingue deux façons radicalement différentes de concevoir la nature de l’informatique en général et le cadre philosophique et épistémologique de ses résultats.

L’interprétation canonique du parcours intellectuel de Turing

Voilà comment je vois la façon dont Hodges interprète la vie et l’œuvre de Turing, appuyée en cela par toute une tradition dérivée de l’empirisme logique dont l’audience est aujourd’hui mondiale, comme les cérémonies, hommages, colloques et événements pour le centenaire de Turing l’ont montré de par le monde en 2012. La notion fondamentale à étudier serait celle d’« intelligence » et la question pertinente à se poser serait celle de savoir si elle peut être conçue de façon mécanique ou pas. La réponse de Turing à cette question serait alors conçue comme le travail consistant à faire évoluer la mécanisation du renseignement (‘intelligence’ pris au sens anglais de collecte des données par les services secrets, ce qui renvoie au travail de Turing sur le décryptage au moyen de la machine Enigma des codes allemands pendant la guerre) à l’intelligence artificielle (‘intelligence’ pris au sens de l’esprit, ce qui renvoie à la construction du premier ordinateur et l’idée que le fonctionnement du cerveau est analogue à celui d’un ordinateur) : l’originalité – immense – de Turing serait ainsi d’avoir accompli ce passage du « renseignement » à l’« esprit » en s’en tenant strictement au paradigme mécanique tel qu’il a été pleinement réalisé par l’ordinateur. Dans cette optique, le « jeu de l’imitation », rebaptisé « Test de Turing » pour les besoins de la cause, deviendrait capital parce qu’il serait un « test » – entendez un algorithme mécanisable – qui prouverait que la notion d’intelligence peut se concevoir comme détachée du support biologique de l’humanité et peut dès lors se transférer à un ordinateur, à peu près comme un logiciel peut tourner sur n’importe quel type de machine, pourvu qu’il s’agisse d’un ordinateur digital.

C’est à cette interprétation que je m’oppose parce qu’elle reconduit la différence logiciel et matériel (en reproduisant ce faisant un dualisme de l’âme et du corps) au lieu de tenter de penser cette différence et de la concevoir comme rendant possible une dynamique de leur rapport.

Un indice devrait tout d’abord nous mettre immédiatement la puce à l’oreille : qu’en est-il, dans cette interprétation désormais canonique, du travail de Turing en biologie théorique ? Il passe à la trappe, purement et simplement. Or je rappelle d’une part que les recherches de Turing en biologie théorique ont occupé toutes les dernières années de sa vie entre 1950 et 1954 une fois qu’il eut définitivement abandonné toute recherche fondamentale en informatique et d’autre part qu’il considérait ses résultats dans ce domaine comme aussi fondamentaux que ceux de son article de 1936 fondant la théorie de la calculabilité. S’agit-il donc seulement d’un passe-temps secondaire que l’on pourrait oublier, le temps d’un film grand public, ou minorer, comme dans l’interprétation canonique du parcours intellectuel de Turing ? C’est impossible si l’on veut rendre justice à ce que Turing disait de son propre travail en biologie théorique. Il faut donc reprendre complètement le cadre interprétatif proposé par Andrew Hodges et revenir à ce qui fait le nerf de la preuve de son argumentation, le jeu de l’imitation.

Le jeu de l’imitation

Contrairement à la façon dont il est présenté dans le film de Tyldum, suivant en cela la majorité des interprètes puisqu’une entrée « Turing test » se trouve depuis longtemps dans le dictionnaire anglais Collins(*), le « jeu de l’imitation » ne consiste pas à montrer qu’il n’est pas possible de distinguer les réponses d’un homme des réponses d’un ordinateur convenablement programmé à qui on poserait des questions pendant une durée de jeu de cinq minutes et en cachant à l’interrogateur tout indice tenant à l’apparence physique des joueurs, c’est-à-dire en se limitant à des réponses imprimées. Le jeu est plus complexe car il est constitué de deux étapes distinctes, indispensables pour tenter d’obtenir le résultat escompté : l’indifférence entre les réponses humaines et les réponses de la machine et, partant, la « preuve » que l’intelligence mécanique est possible. Dans la formulation du jeu décrite par Turing dans son seul article de philosophie publié en 1950 dans la revue Mind, trois joueurs participent au jeu. L’un, appelé l’interrogateur, est séparé des deux autres, un homme et une femme, et doit tenter de deviner qui est l’homme et qui est la femme – bref doit tenter de déterminer quelle est la différence physique maximale entre deux êtres humains. Une fois en position d’échec pendant un certain temps, relativement court, la seconde étape du jeu consiste à remplacer le joueur masculin par un ordinateur convenablement programmé sans prévenir l’interrogateur et à se demander si celui-ci sera capable de déceler qu’il n’a plus affaire au même joueur mais que celui-ci a été remplacé par un ordinateur, bref que la différence entre humains et ordinateurs dans la deuxième étape du jeu ne sera pas plus décelable que la différence des sexes entre les humains dans la première.

Je soutiens que le jeu tel qu’il est décrit par Turing ne peut pas parvenir au résultat escompté pour une raison très simple : pour réussir à monter une partie du jeu, il faudrait à la fois prendre en compte la différence physique entre homme et femme dans la première étape et la différence physique entre un être humain et un ordinateur dans la seconde – car il faut avoir la capacité de choisir deux joueurs physiquement les plus opposés – et ne pas prendre en compte cette différence physique – puisqu’il s’agit de parvenir à la conclusion que la mise en échec de l’interrogateur a une portée universelle qui rend toute différence physique entre les joueurs indifférente. Bref, la conclusion à laquelle le jeu doit parvenir détruit les conditions de possibilité de sa propre construction. Autrement dit, pour que tout lecteur de l’article puisse parvenir à faire sienne la mise en échec de l’interrogateur et la conclusion que l’intelligence artificielle est bien réelle, il faudrait que tout lecteur puisse à la fois se dire que, s’il était à la place de l’interrogateur dans le jeu, il serait lui aussi mis en échec dans les deux étapes du jeu tout en se disant aussi qu’il doit cependant être toujours capable de faire physiquement la différence entre les deux joueurs (masculin et féminin dans la première étape, féminin et mécanique dans la seconde) pour monter une partie. Bref, la différence physique entre les joueurs doit en même temps être à tout jamais indécelable tout en étant pour toujours présupposée pour que le jeu puisse fonctionner. La position exigée de la part du lecteur quant à la détermination du rapport d’identité ou de différence entre humain et ordinateur est donc un indécidable au sens technique que ce terme revêt depuis l’article de Turing de 1936 puisque les condition d’accès à cette information rendent impossibles l’accès à l’information en question.

Déterminisme prédictif ou pas

Comment concevoir alors le jeu de l’imitation et plus globalement l’article de Turing de 1950 ? En remarquant qu’il y a une toute autre superposition dans cet article que celle existant entre les deux sens de la notion d’intelligence dont j’ai parlé plus haut. Turing remarque en effet que l’ordinateur en tant que machine physique est une machine « laplacienne » (relevant du déterminisme prédictif) mais que le monde physique ne l’est généralement pas pour des raisons ayant trait à la nature même de la matière, susceptible de comportements chaotiques (relevant du déterminisme non-prédictif). C’est donc la superposition de ces deux sens du déterminisme qui fait le fond de l’article de Turing et il faut le lire à ces deux niveaux : le niveau « grand public » (celui du film de Tyldum) dans lequel on débat (littéralement : à n’en plus finir pour des raisons ayant trait à l’indécidabilité dont j’ai parlé plus haut) pour savoir si et comment une machine peut être considérée comme « intelligente » et le niveau « de l’indécidable » dans lequel on sait pertinemment que la véritable question n’est pas là mais qu’elle se situe dans le rapport entre le calculable et l’incalculable et que ce rapport est précisément celui que Turing a exploré tout au long de sa vie et ce, jusqu’en biologie où les formes vivantes persistent – pour le temps de leur vie – à la frange du chaos qui mettra un terme à leur cohérence interne, comme l’a si profondément montré Giuseppe Longo (cf. F. Bailly & G. Longo, Mathématiques et sciences de la nature; La singularité physique du vivant, Hermann, 2007 et G. Longo & M. Montévil, Perspectives on Organisms: Biological Time, Symmetries and Singularities, Springer, Berlin, 2014).

Il y a donc une continuité théorique totale dans le parcours de Turing, que l’on pourrait résumer dans cet aphorisme quasi-mallarméen dans son aspect paradoxal : jamais un surcroît de programmation n’abolira le non-programmé, comme le prouve la théorie de la programmation. Turing est en effet parvenu à montrer les limitations internes à la théorie de la programmation à partir de cette théorie même. Un problème capital se pose alors : comment réussir à manifester et à explorer plus avant ce non-programmable si c’est seulement dans son rapport au programmable qu’il devient pensable ?

Où se situe le non-programmable ?

Turing passera le reste de sa vie, après son article de 1936, à essayer de répondre à cette question et la réponse qu’il a élaborée continue d’occuper le champ de la recherche aujourd’hui. Celle-ci me paraît être la suivante : la production de formes cohérentes que ce soit dans la pensée (l’invention du concept de machine de Turing, par exemple) ou dans la nature (l’apparition des formes vivantes, par exemple) est une manifestation de ce non-programmable.

Je soutiens que l’article de 1950 dans lequel Turing propose à la sagacité de son lecteur le « jeu de l’imitation » est une méditation sur les deux notions de la « pensée » et de la « nature » et plus encore sur leurs rapports. Or, pour avancer plus avant sur cette question difficile, on ne peut pas envisager la « pensée » ou la « nature » comme des notions fixées une fois pour toutes dont on pourrait étudier les produits complètement constitués (telle pensée, telle forme vivante) : il faut au contraire envisager la « pensée » et la « nature » comme des processus d’individuation progressive de formes. Or Turing a proposé, dans les dernières années de sa vie, un modèle de développement des formes vivantes à partir de brisures de symétrie dans la matière physique et c’est, à mon sens, en poursuivant une idée analogue sur le mode du désir qu’il construit le jeu de l’imitation quand il s’agit de rendre compte de l’invention du concept de « machine de Turing » : il s’agit de savoir si on peut remplacer la pensée d’un homme par un ordinateur à partir d’une brisure de symétrie dans la matière, c’est-à-dire d’une différence physique.

Vu sous cet angle, le jeu de l’imitation prend une tout autre tournure que celle de savoir si la « pensée » est un concept universel, indifféremment incarné dans l’être humain ou l’ordinateur : il consiste en la description d’un processus d’individuation d’une forme de la pensée (l’invention du concept de « machine de Turing » chez l’individu Turing) et du rapport ambivalent que cette forme entretient avec les deux modalités (programmable et non-programmable) de son incarnation possible – le jeu devenant alors typique d’un « double entendre » (comme on dit en anglais !). De ce point de vue, la différence physique entre les joueurs et, en tout premier lieu, comme Turing n’a pas manqué de le voir, la différence des sexes, joue un rôle capital dans la dynamique du jeu puisque c’est son possible dépassement, pour les formes vivantes que nous sommes, qui en fait le moteur. L’aphorisme quasi-mallarméen dont je parlais plus haut prend alors la forme suivante : jamais un surcroît de programmation n’abolira la différence des sexes, comme le suggère le jeu de l’imitation.

Aussi peut-on dire que si le jeu parvenait à ses fins, la différence des sexes serait effectivement dépassée et la sexualité personnelle de Turing définitivement cachée. Turing apprit, à ses dépens, que ce n’était pas le cas et il y a presque de la prophétie dans le jeu de l’imitation, comme le film de Tyldum le laisse d’ailleurs entendre, lui qui finit par avouer la nature de sa sexualité après un interrogatoire de police et qui fut condamné à une castration chimique.

La signification générale du parcours de Turing ne se situe donc pas, selon moi, dans le passage d’un sens de la notion d’intelligence à un autre (on en resterait à une perspective algorithmique visant à étendre indéfiniment le périmètre du calculable, ce que l’informatique n’a pas manqué de faire depuis qu’elle existe) mais dans le passage de la forme au sens du formalisme et de ses limitations internes à la forme au sens de la production des formes, idéales comme celles de la machine de Turing ou naturelles comme celles des formes biologiques, en se plaçant d’emblée du point de vue du rapport programmable / non-programmable. Et c’est évidemment dans cette production que se situe l’énigme de l’invention des formes que ce soit celle produite par Turing dans le concept de machine de Turing ou que ce soit celle produite par la nature. Il reste encore un film à faire sur le sujet, et il n’y a aucune raison de ne pas espérer le voir réalisé un jour.

Jean Lassègue, CNRS – Institut Marcel Mauss, École des Hautes Études en Sciences Sociales.

(*) Test de Turing : test visant la capacité de l’ordinateur à penser, requérant que la substitution cachée d’un participant par un ordinateur dans un dialogue par télétype soit indétectable pour le participant humain qui reste. » On va voir combien cette description est trompeuse.

Filmographie

- Le modèle Turing, de Catherine Bernstein, produit par CNRS Images

- La drôle de guerre d’Alan Turing, de Denis van Waerebeck, récemment passé sur Arte

- The strange Life and Death of Dr Turing, de Christopher Sykes, produit par la BBC (en ligne sur YouTube).

Bibliographie

- F. Bailly & G. Longo, Mathématiques et sciences de la nature; La singularité physique du vivant, Hermann, 2007

- G. Longo & M. Montévil, Perspectives on Organisms: Biological Time, Symmetries and Singularities, Springer, Berlin, 2014

Elle a été largement critiquée dans la presse étrangère et comparée au Patriot Act post-11 septembre des États-Unis. Ce même Patriot Act dont les Américains souhaiteraient aujourd’hui sortir.

Elle a été largement critiquée dans la presse étrangère et comparée au Patriot Act post-11 septembre des États-Unis. Ce même Patriot Act dont les Américains souhaiteraient aujourd’hui sortir.

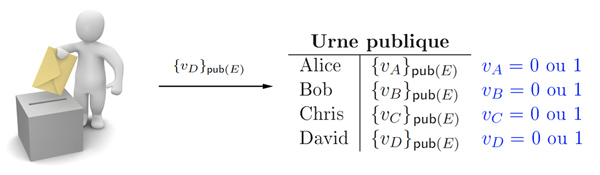

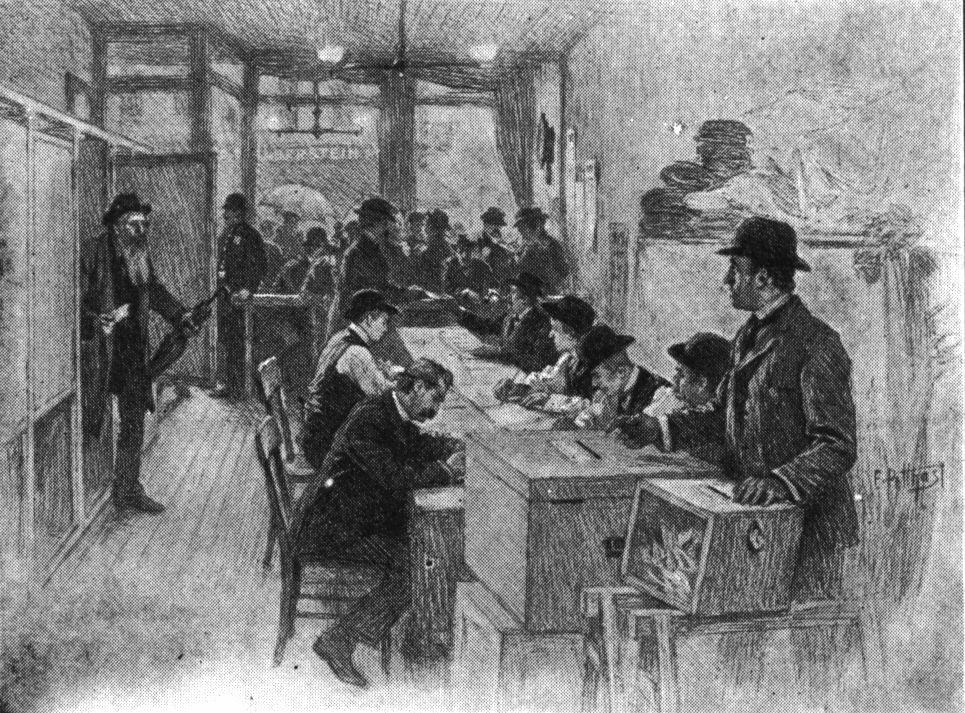

Mettre au point un système de vote électronique sûr est un exercice délicat. En particulier, la vérifiabilité et la résistance à la coercition sont des propriétés antagonistes : il faut à la fois démontrer qu’un certain vote a été inclus dans le résultat et ne pas pouvoir montrer à un tiers comment on a voté.

Mettre au point un système de vote électronique sûr est un exercice délicat. En particulier, la vérifiabilité et la résistance à la coercition sont des propriétés antagonistes : il faut à la fois démontrer qu’un certain vote a été inclus dans le résultat et ne pas pouvoir montrer à un tiers comment on a voté.