Corinne Vercher-Chaptal a mené une étude approfondie sur sept plateformes considérées comme alternatives aux plateformes dominantes. Entre transition écologique et renouveau démocratique, elle nous décrit les promesses de ces plateformes innovantes. Cet article a été publié le 21 octobre 2022 sur le site de cnnumerique.fr et est remis en partage ici, les en remerciant. Serge Abiteboul et Thierry Viéville.

Vous avez piloté une équipe de recherche qui a étudié 7 plateformes dites alternatives : en quoi ces plateformes se différencient des GAFAM ?

Ces modèles étaient alternatifs, non pas parce qu’ils proposaient de faire différemment ce que font les modèles dominants, mais plutôt parce qu’ils créent une offre de valeurs qui n’existe pas dans le secteur dans lequel trône la plateforme dominante.

Les cas que nous avons étudiés sont dits alternatifs par le modèle économique, de gouvernance et le service qu’ils proposent dans un secteur où domine une grande plateforme. Assez rapidement, il nous est apparu que ces modèles étaient alternatifs, non pas parce qu’ils proposaient de faire différemment ce que font les modèles dominants, mais plutôt parce qu’ils créent une offre de valeurs qui n’existe pas dans le secteur dans lequel trône la plateforme dominante.

Le secteur du tourisme est en cela assez emblématique. Il est fortement dominé par Airbnb. Nous avons étudié la plateforme coopérative « Les Oiseaux de passage » qui propose une autre manière de voyager en mettant en relation des habitants, professionnels et voyageurs, pour aller vers une forme sociale du tourisme s’approchant de l’hospitalité. La particularité de ce modèle est que, contrairement à Airbnb, il s’extrait des standards marchands et poursuit une finalité sociale et patrimoniale. La plateforme propose une tarification qui ne repose pas sur un algorithme de prix (tarification dynamique) mais qui est modérée en fonction de l’hôte et du voyageur, permettant une diversité d’échanges, gratuits ou tarifés.

Mobicoop, plateforme coopérative de covoiturage libre, est un autre cas intéressant. Son origine est une réaction à la marchandisation du covoiturage. En 2007, une association appelée « Covoiturage.fr » crée une plateforme pour mettre gratuitement en contact des personnes pour covoiturer. En 2011, au moment où le covoiturage connaît une expansion, la plateforme instaure une commission sur les trajets effectués par les co-voitureurs, et devient Blablacar. Les militants de la communauté initiale ont alors réagi en recréant une nouvelle plateforme pour maintenir une mise en relation gratuite des annonces de covoiturage. C’est ainsi qu’est apparue Mobicoop. L’objectif premier n’est pas seulement le covoiturage en tant que tel et le remboursement de ses frais du voyage, mais de proposer un moyen de participer à la réduction de la prolifération des véhicules individuels (autosolisme), et donc à la transition écologique. Ainsi, Mobicoop est développée en logiciel libre et ne prélève aucune commission puisque cela serait antinomique avec sa finalité : plus la plateforme est ouverte, plus l’objectif écologique sera atteint. Pour faire vivre la plateforme et ses besoins en développement, la coopérative a recours aux appels au don et au sociétariat mais surtout à la vente en marque blanche de plateformes et de prestations de mobilité partagée aux collectivités territoriales. Ce versant marchand permet donc à la plateforme de proposer au grand public un service d’intermédiation gratuit en accord avec son éthique et son objectif environnemental.

Au-delà de ces exemples, il existe une diversité de modèles économiques alternatifs. Tous ont le même défi : pérenniser leur modèle. Même si pour la plupart, ces modèles n’ont pas vocation à se substituer entièrement aux dominants, il faut qu’ils aient les moyens de constituer et de fidéliser des communautés d’usagers et de contributeurs prêts à valider, sous une forme ou une autre, (don, sociétariat, cotisation…) la valeur sociale et environnementale créée, et qui n’a pas été formatée pour le marché et ses exigences.

Voyez-vous un rapprochement entre ces modèles et les mondes du logiciel libre et des communs, qui sont classiquement cités comme des alternatives aux modèles dominants sur Internet ?

Le monde coopératif se mêle de plus en plus au monde des communs et du logiciel libre, ce qui n’était pas évident au départ.

Originellement, l’objet des communs numériques est l’ouverture des services numériques, et celui du coopérativisme est la propriété partagée visant à protéger les intérêts des membres. Ces deux objectifs sont distincts mais ne sont pas incompatibles. En France, nous avons la chance d’avoir le dispositif SCIC (société coopérative d’intérêt collectif) qui permet de rassembler les deux approches en ouvrant la gouvernance des coopératives à une diversité de parties prenantes. Le dispositif SCIC renforce la prise en compte de l’intérêt général, et la dimension délibérative qui est le propre des communs. La propriété est ainsi repensée pour qu’elle ne soit plus exclusive à quelques sociétaires prédéfinis mais accessible à toutes les parties prenantes, devenant ainsi plus inclusive. Ce dispositif participe donc grandement au rapprochement des coopératives avec les communs.

Le rapprochement avec le logiciel libre est moins évident puisque la notion de propriété est en tant que telle antinomique de l’esprit du libre, qui en rejette toute forme. Aujourd’hui, on assiste à une politisation d’une partie du mouvement qui a pensé dès ses débuts un Internet émancipateur via la non-propriété et l’universalité de l’accès. Certains militants du logiciel libre estiment avoir fait une erreur en n’articulant pas les logiciels libres à des finalités sociale et/ou environnementale. Cela a provoqué une forme de scission au sein du mouvement entre ceux qui ont une vision fonctionnelle et individuelle des libertés numériques, prônant une liberté sans limite, et ceux qui ont une approche collective et délibérative s’attachant à préserver l’éthique du projet.

Ainsi, des outils tels que les licences à réciprocité ont été développés par cette deuxième branche du mouvement pour essayer de répondre à ce qu’ils estiment être les limites des logiciels libres initiaux. L’objectif de ces licences est de restreindre l’ouverture et l’usage de la licence soit en décidant de la nature de l’organisation usagère (organisation de l’économie sociale et solidaire par exemple), soit en restreignant l’usage commercial à certaines finalités. Par exemple, CoopCycle, une coopérative de livraison à vélo, a autorisé uniquement l’usage de la licence aux collectifs de livreurs constitués en coopératives. Cela va encore plus loin avec les Hippocratic licenses (licences hippocratiques) qui imposent un critère éthique aux projets open source et restreignent l’utilisation au respect des droits humains. L’Hippocratic License fait cependant l’objet de controverses au sein du mouvement du logiciel libre.

Ces licences, qui peuvent permettre de restaurer une relation de réciprocité entre le secteur marchand et les communs, rapprochent le coopérativisme du mouvement du logiciel libre tout en préservant l’esprit des communs.

Quel rôle l’État doit-il adopter vis-à-vis de ces modèles alternatifs ?

Les communs offrent une formidable opportunité de renouveau démocratique en permettant une co-construction avec l’État d’actions publiques nouvelles et adaptées aux crises écologique, sociale et sanitaire.

Ce qui est certain c’est qu’en l’absence de dispositifs financiers et institutionnels adaptés à leurs spécificités, les modèles alternatifs ne peuvent se développer et se pérenniser. J’en veux pour preuve l’initiative Les Oiseaux de passage qui doit en grande partie son développement à l’attribution du statut de jeune entreprise innovante (JEI). Cependant, ce ne fût pas sans difficulté car cette plateforme a longtemps eu du mal à se voir reconnaître comme étant innovante. Il y a sans doute des dispositifs à créer ou à modifier dans l’écosystème de l’innovation pour clarifier cette caractérisation et aider à la pérennisation de ce type d’initiatives, dont l’objectif est de mobiliser le numérique au service de projet solidaire, de transition socio-environnementale.

Il y a aussi un véritable enjeu à lutter contre la précarité des contributeurs, phénomène bien connu dans le monde du logiciel libre. De nombreux acteurs de la communauté du logiciel libre vivent dans une précarité certaine. Il est donc primordial de s’attacher à réfléchir à des innovations institutionnelles pour sécuriser le travail des contributeurs aux communs.

Enfin, au sein de l’équipe du rapport TAPAS, nous avons pointé l’opportunité d’un rapprochement entre les communs (numériques et non-numériques) avec l’acteur public. Il est essentiel qu’un espace autre que purement marchand, obéissant à une rationalité autre qu’instrumentale, se développe pour déployer les communs. Il faut enseigner que les communs peuvent être le lieu de solidarités citoyennes, comme le souligne Alain Supiot, inscrites dans les territoires. A cette échelle, les communs peuvent participer à la construction de politique de transition avec les collectivités locales dans les domaines qui leur incombent comme le transport, l’habitation, la qualité de l’eau, l’alimentation…Pour ce faire, l’État doit avoir un rôle facilitateur qui va au-delà du seul soutien financier. A côté d’une régulation contraignante à destination des GAFAM, l’état peut mettre en place une régulation habilitante visant à soutenir les alternatives, dans le respect de leur identité et de leurs spécificités. Cela peut être par la mise à disposition de ressources matérielles ou immatérielles, comme l’initiative “Brest en communs” où la ville a fourni des réseaux d’accès Wifi ouverts et gratuits sur le territoire, par exemple. Finalement, là où il existe des zones où le service public est défaillant ou absent, les communs offrent une formidable opportunité de renouveau démocratique en permettant une co-construction avec l’État d’actions publiques nouvelles et adaptées aux crises écologique, sociale et sanitaire.

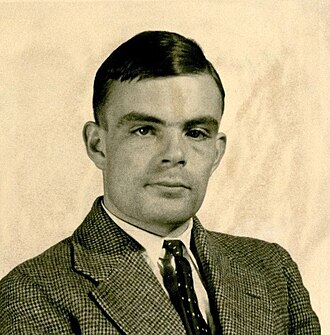

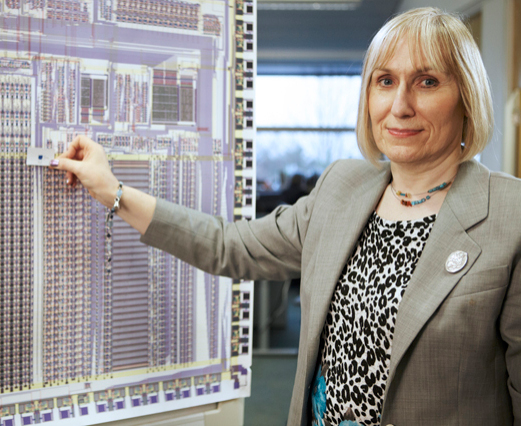

Corinne Vercher-Chaptal , Professeure Université Sorbonne Paris Nord.

Pour aller plus loin :